BuLuoPiaoYu

BuLuoPiaoYu

不开Opencv是可以Cmake成功的,不过VS这边编译还是会报错的,不知道这个要怎么解决?  VS报错信息

GPU  CPU

dll文件是用你百度云发的那个,不是自己编译的呢 训练模型  发布模型

> > dll文件是用你百度云发的那个,不是自己编译的呢 > > 模型 > >  > > 那应该就是CPU、GPU都可以,建议训练和测试都用GPU,修改use GPU参数为True 我用GPU重新训练了,好像没有用。

可以一次加载多个模型对一张图片做预测的吧

@heliqi

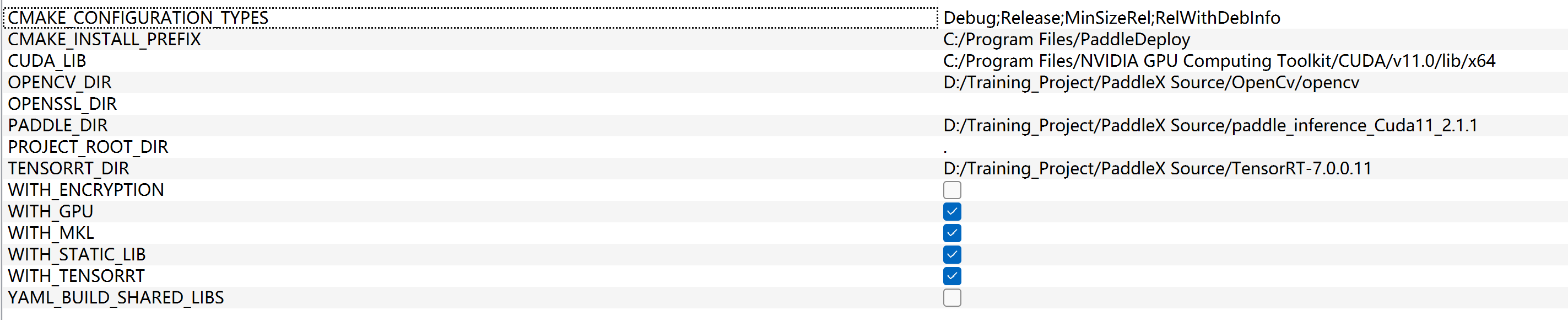

> 编译时把tensorrt选项打开,并填写好地址即可。最新代码的分别是: > > 1. WITH_GPU 启用GPU编译, vs的cmake界面勾选上 或 CMakeSettings.json 里的False改为True > 2. WITH_PADDLE_TENSORRT paddle inference推理引擎 是否启用trt。 勾选 或 改为 True > 3. TENSORRT_DIR tensorrt的解压路径, 需要填写上  我这个应该没错吧,但是我Vs编译出来运行不了啊,如下图:  @heliqi

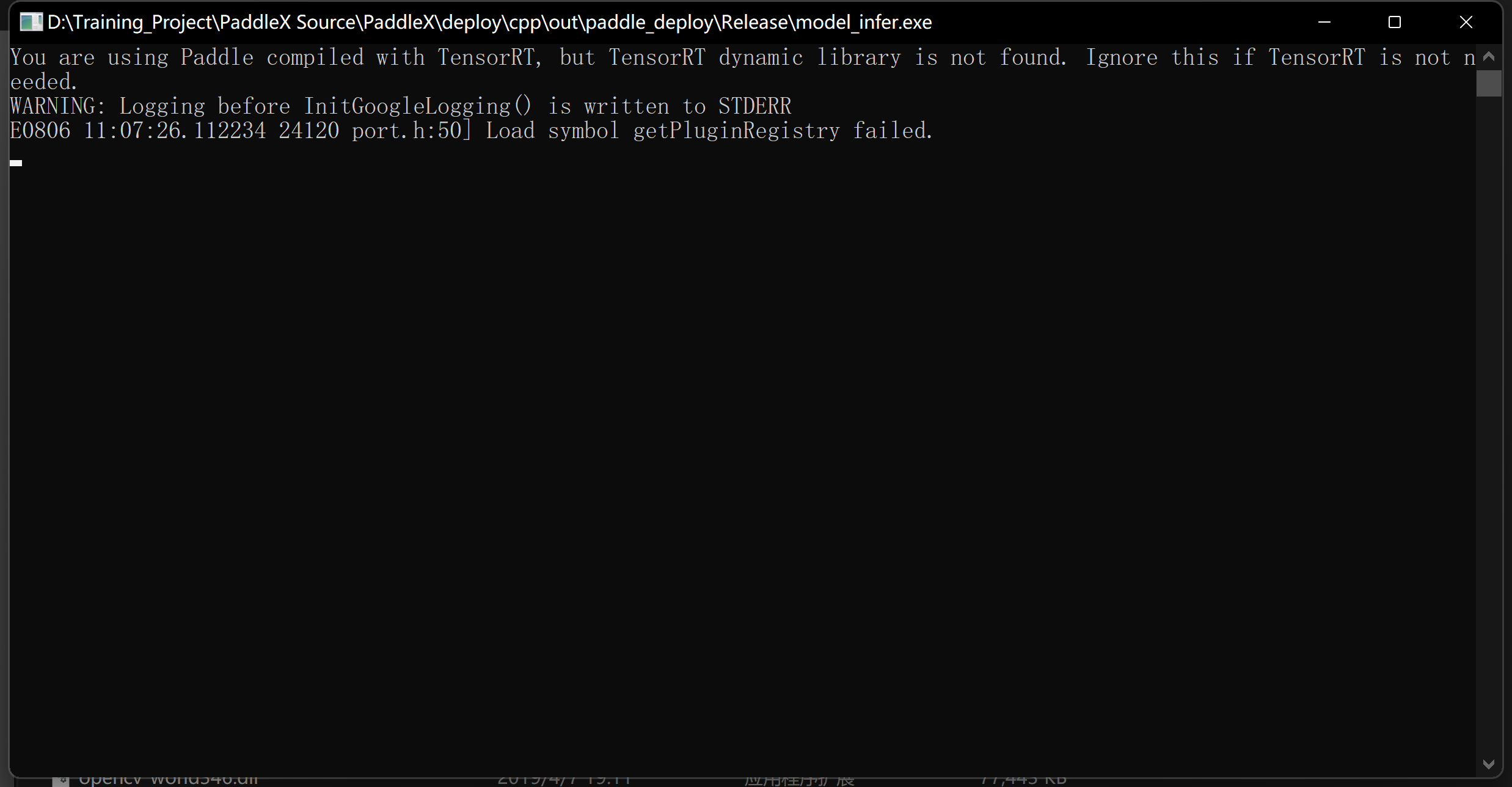

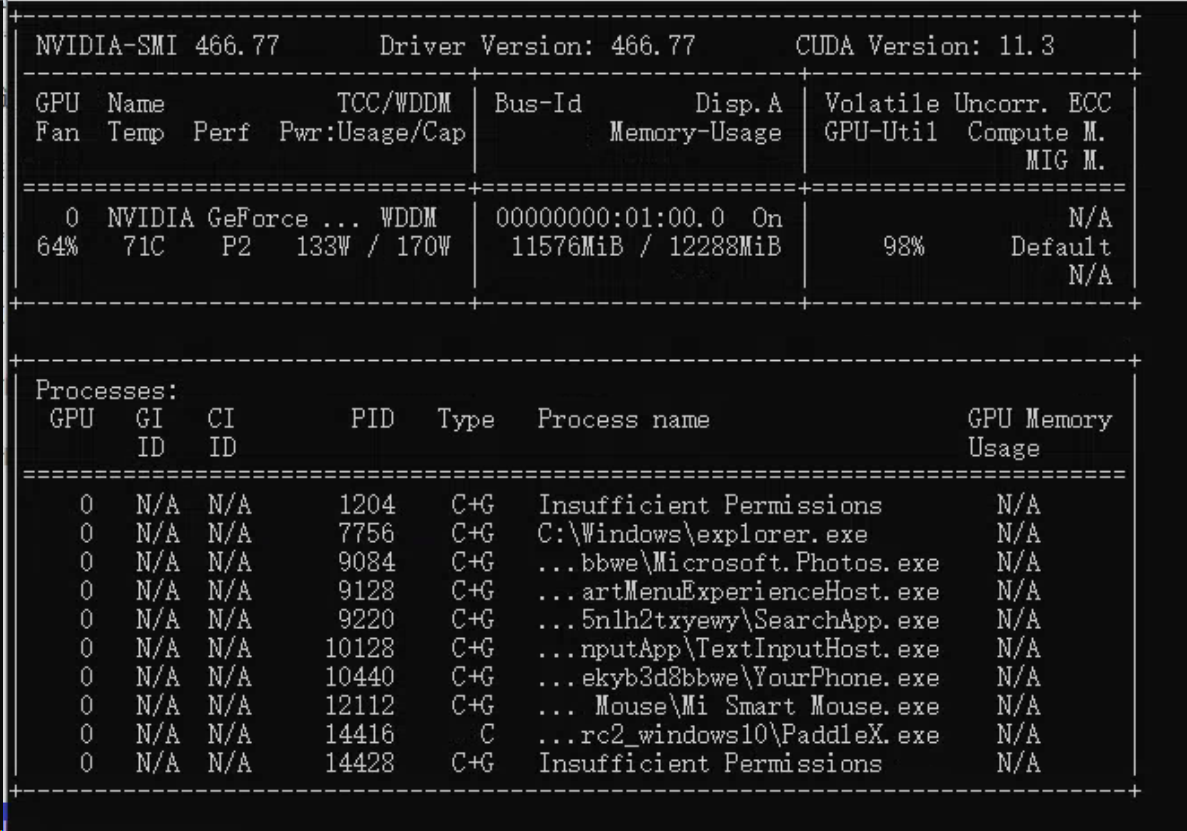

> 1. CUDA_LIBA 路径是否设置正确 ,以及是否配置cuda到环境变量 。 可以用 nvcc --version 指令 和 nvidia-smi 指令 检验下环境变量的设置 > 2. 直接双击 model_infer.exe 看看有没有提示缺少什么dll > > 以上解决完,基本OK。如果还不行: > 3. 你使用的是CMAKE GUI吧,完全按文档用VS自带的cmake重新编译试试   直接双击 model_infer.exe的话就是报那个tensorrt的问题

@heliqi

> 对了,如果你一开始没勾选 WITH_TENSORRT, 后面才勾选。 需要先清空缓存(比如把vs的输出目录out删掉), 然后重新编译一下。 > > 还有一个非常关键的点: > 你下载的paddle inference预测库版本,一定要跟CUDA、CUDNN、TensorRT版本对上。 > 比如: 下载 [cuda11.0_cudnn8.0_avx_mkl_trt7](https://paddle-wheel.bj.bcebos.com/2.1.1/win-infer/mkl/post110/paddle_inference.zip) 预测库 , 那你的cuda一定要是11.0, cuDNN = 8.0、 TensorRT应该是7.2(这个具体看预测库解压后目录中的version.txt文件) 客户端上面需要配置什么环境?跟开发环境一样? @heliqi