xiaosi

xiaosi

## 补充说明 首先,非常感谢 @zhanghongyong123456 同学这份详细的windows下配置lite.ai.toolkit 的教程~ 简直太热心啦~ 用windows的同学可以先看这份教程进行配置~ 以及以下相关issues的讨论。 ## References for Windows10 users windows下的使用可以参考以下这几个讨论(some references for windows users) * 👉 #6 * 👉 #10 * 👉 #32 * 👉...

I looked at several questions to try to use it in Win, but I didn't see if it was successful in Win, so I wanted to ask if it was...

windows10 python3.8.5 pytorch 1.8.1 numpy 1.17.4 cuda 11.1 When I run # 1. Create a conda virtual environment. conda create -n alphapose python=3.8.5 -y conda activate alphapose # 2. Install...

当我只取RGB的均值,我发现会丢失信息,对于由RGB预测alpha的细化模块,我该如何处理RGB输入最为恰当

您好,再次感谢您开源的强大的视频抠像的项目,对于训练自己的数据集,有一些问题想请教一下,希望得到您的及时回复: 1.我制作了合成的数据集,这意味着,不能进行前景预测,对于前景预测,我看到作者回复的一些问题( https://github.com/PeterL1n/RobustVideoMatting/issues/132 ),会影响运动模糊,产生背景泄漏的情况,对于项目我仅仅是注释了代码中对于前景loss的计算,其他的网络架构没有进行修改(尝试修改失败 https://github.com/PeterL1n/RobustVideoMatting/issues/132#issuecomment-1083996533 )。第一次小数据集训练效果感觉很不错,于是制作了更加复杂的数据集,基于更加复杂、数据量很大的数据集,花费的很长时间得到的训练结果各种的不如意,没有小数据集的结果好,( https://github.com/PeterL1n/RobustVideoMatting/issues/150 ),训练的策略基本按照您提供的进行阶段训练(这里没有制作第四阶段数据,于是使用的第三阶段视频数据集,进行第四阶段的训练),我看了训练的tensorboard 的loss 图表没有分析出来任何有用的信息。 2. 对于训练结果的闪烁现象,依然很严重,不确定是我训练超参数设置有问题,还是模型对于复杂区域会出现闪烁的问题,是否有解决或者缓解的方法。 期待您的回复!

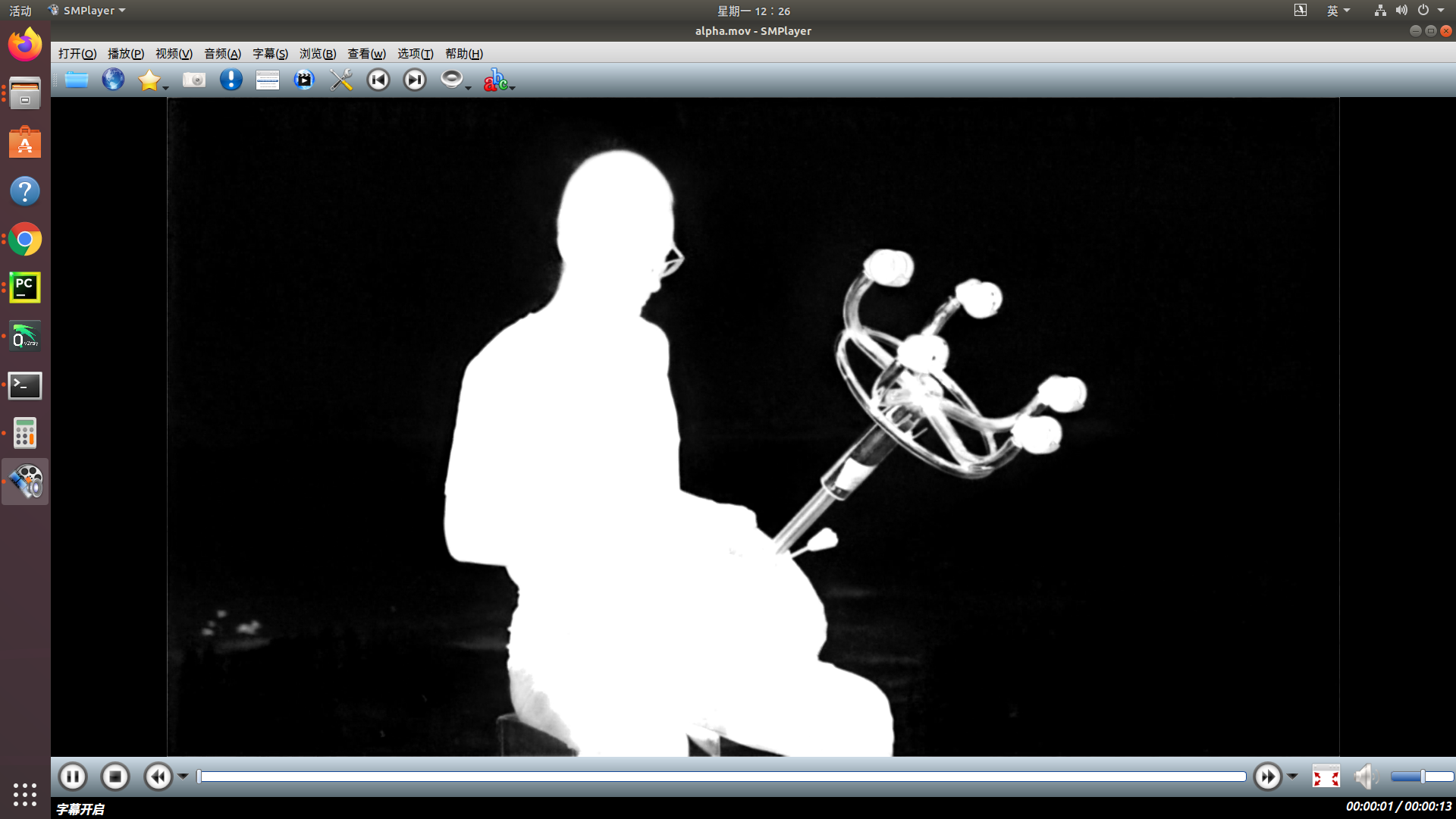

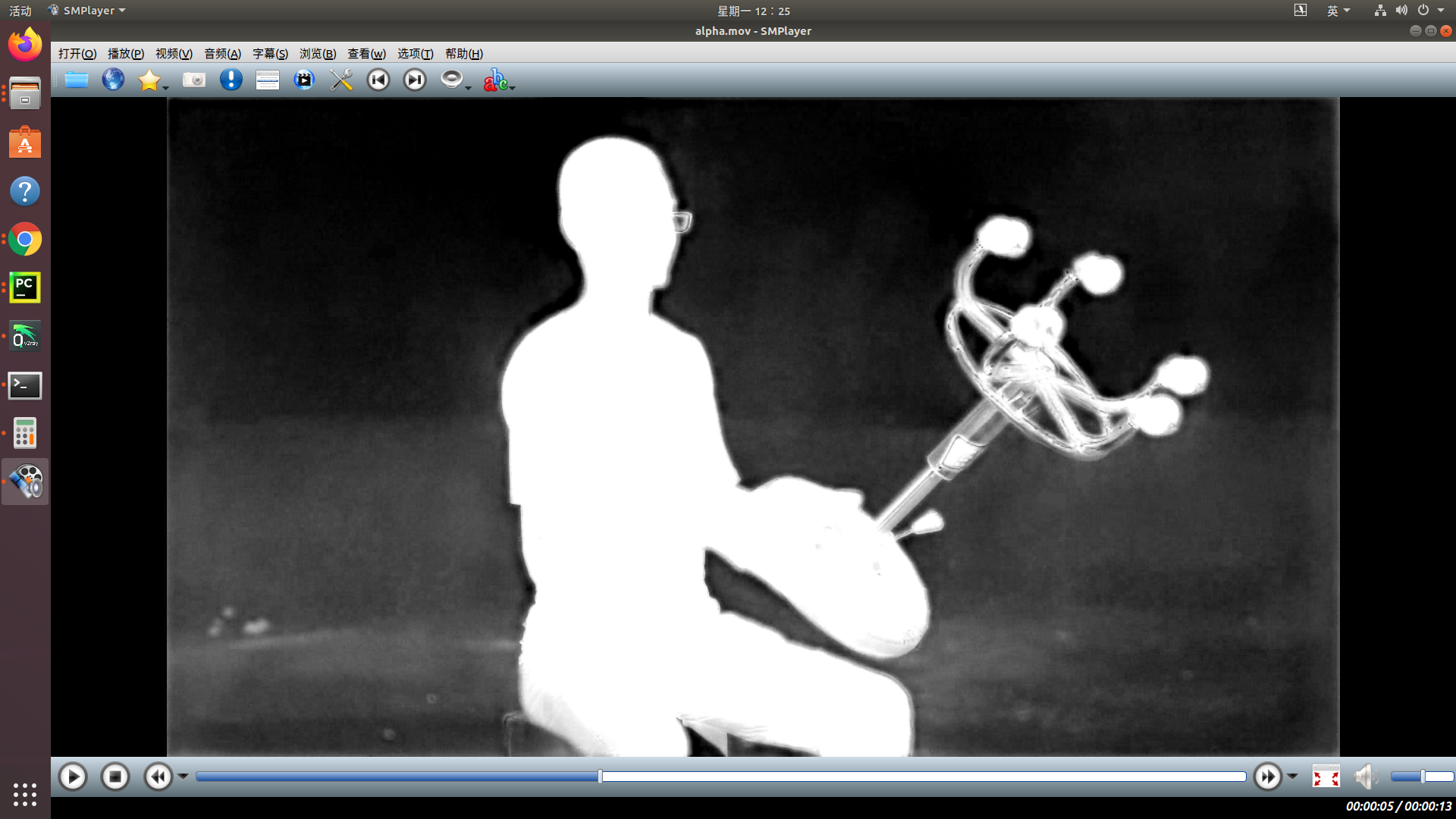

我训练第二阶段测试结果是这样的:  第三阶段训练测试得到这样的结果:  这明显比第二阶段差很多,这是什么原因呢? 我分割数据集采用的是(768,432)像素大小图像,并且也是采用的代码合成图的方式:分为fgr、bgr(分割用的其实就是抠像的低分辨率数据集),会不会和这个有关系呢, 抠像小分辨率是(768,432),高分辨率是(3840,2160)以及(1920,1080),他们属于一个数据集,只是分辨率不同 这是我在tensorboard查看的训练真实alpha以及预测alpha展示图: 真实alpha:  预测的alpha:

1. 我现在的抠像数据集有alpha以及合成图(fg+bg),而非VideoMatte240K_JPEG_SD提供的fg 以及BackgroundVideos提供的bg,我该如何加载数据呢

If I set --preprocess-alignment =True, I must ensure that the background is consistent with the original frame of the video stream, and will report an error if the alignment is...

How can 2-D pose estimation be realized in real time,Whether to use Openpose(https://github.com/CMU-Perceptual-Computing-Lab/openpose),Or any other way,I found this when I was testing  What measures do I need to take...