yulm-1

yulm-1

想问一下就是按照他的相关参数训练的话,4个卡tiny需要训练多久?数据集就用他给的那个街景的数据集

> 训练集指的那两个合成数据集吗,四张a100需要一天多 不是合成数据集是[Chinese Benckmark]那个数据集

https://github.com/PaddlePaddle/PaddleOCR/blob/release/2.6/doc/doc_ch/algorithm_rec_svtr.md 中的  他没有提供合成数据集呀 > 那个是作为测试集吧,训练还是合成的

> 这里都是测试集,训练集都是syth和mj,论文中有提到 好的,非常感谢

> 这里都是测试集,训练集都是syth和mj,论文中有提到 请问你有这两个数据集吗?

我又认真的看了一下这个论文,他应该就是用[Chinese Benckmark]提的数据集进行中文任务的训练,英文的训练用的是syth和mj这两个数据集

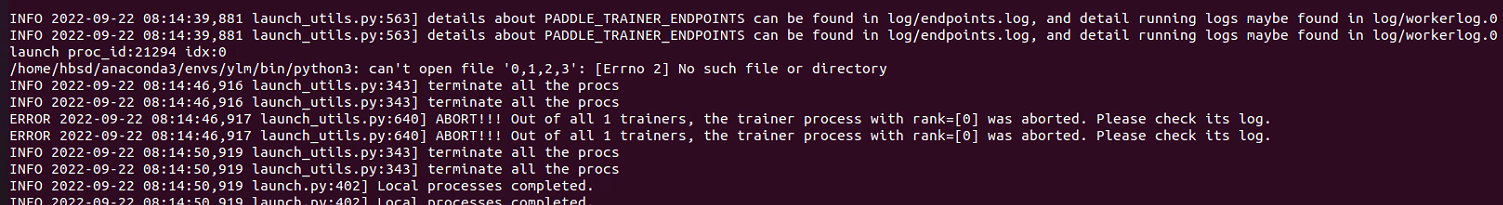

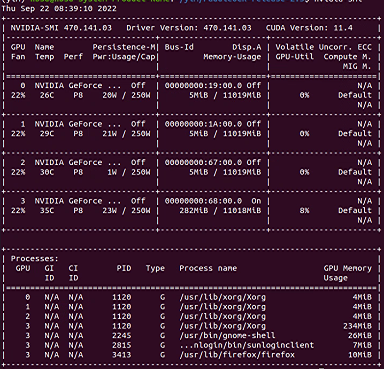

> > > aistud就一个卡,为什么会多卡呢? > > > > > > 可是文档里不是说了可以多卡训练嘛,您的意思是ocr仅支持单卡训练吗。 > > 多卡指的是多个显卡,aistudio就提供了一张显卡,你怎么用多卡训练? 我在自己电脑的多卡上也遇到了这个问题,我的电脑是四个卡的,这个问题怎么解决呢?

> SVTR借鉴Vision Transformer结构,使用了绝对位置编码,无法应对变长的输入,只能识别25个字符以内的文本。因需要统计训练集和测试集样本的宽高比,比如,在中文数据集中发现存在很多宽高比10:1的样本,字符数超过了25,如果直接将这些样本resize到32 100,会造成文本图像的失真,因此我们将图像保留宽高比,高度设为32,如果宽度小于320,这padding,如果宽度大于320,则压缩为320,这样尽可能保留了文本图像的原始信息。 > > 存在问题 由于SVTR使用了绝对位置编码,无法应对变长的输入,一个解决方案即为优化input_size:统计宽高比,例如:1、[3, 32, 100]适应宽高比多数为4:1且单个样本字符数不超过20的数据集;2、如果数据集中存在很多宽高比为10:1样本,则可以将[3, 32, 100]修改为[3, 32, 200]或者[3, 32, 320],也可以参考SVTR中文配置。 > > 如果文本图像中字符个数不确定,但是有的超过了25个,建议采用可以变长输入的模型,比如PP-OCRv3,可以根据图像高宽比设置输入,也可以识别超长的文本。 > > 如果大部分图像都超过了25个字符,建议训练时根据实际情况修改:max_text_length,并将input_size设置为宽高比更大的比例 您好,我想请问一下竖向图片SVTR是怎么对它进行resize的呢?

> > 您好,我想请问一下竖向图片SVTR是怎么对它进行resize的呢? > > 竖向文本进行旋转后再进行resize 我使用Benchmarking Chinese中提供的数据集(格式.lmdb)进行训练,发现可视化结果中竖向文本都被识别为一个字了,代码本身是不包含旋转的代码吗?需要先处理数据集?