vpegasus

vpegasus

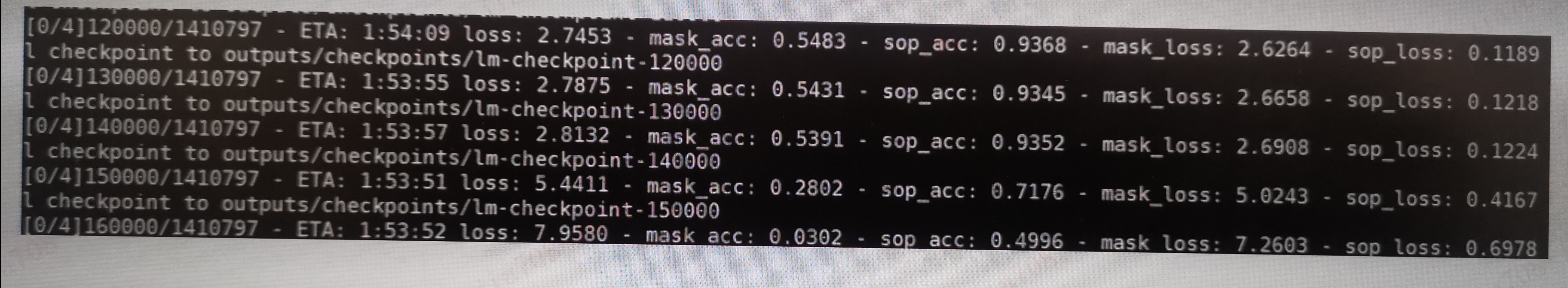

你好,感谢这么漂亮的工作,基于您的工作,我打算预训练一下我们自己的模型, 1 因为语料(英文的)的不同,我把字典替换我们自己的(其实上另一个bert的字典) 2 因为机器限制(8卡 p100)所以把batchsize设为32,其他基本没有变化, 3 第一次尝试只用了140w左右的数据,发现1w的时间大约是1h54m左右 3. 开始时模型进展顺利,但到14w左右,模型突然崩了,即loss突然上涨,acc急剧下降 以上是基本情况 a. 因为发现warmup rate是0.1所以14w差不多正好是140w的0.1, 然后,我去check learning rate的代码,大佬写的完全没有问题 b. 有人说是learning rate太大了,但我想,如果太大的话,在warmup过程后半段就会有异常, c. 就算learning rate 太大,也只是震荡,像这种突然崩掉,似乎也不太可能。 以上是初步分析 check了好久,也没有发现问题,故来请教下,谢谢

I run command: `python train.py --actor-model facebook/opt-1.3b --reward-model facebook/opt-350m --deployment-type single_node` when the process run into `step 2`: ``` Launch command: bash /mnt/disks/data-1/marvin/DeepSpeedExamples/applications/DeepSpeed-Chat/training/step2_reward_model_finetuning/training_scripts/single_node/run_350m.sh /mnt/disks/data-1/marvin/DeepSpeedExamples/applications/DeepSpeed-Chat/output/reward-models/350m ``` we encounter the following error,...

I used `peft` to fine tune baichuan llm via lora way. I ran the same fine-tuning code as 7B for 13B, but something went wrong: ``` /opt/conda/envs/trl/lib/python3.10/site-packages/transformers/optimization.py:411: FutureWarning: This implementation...

你好,谢谢你提供的demo, 不知你是否就是'斗大的熊猫', 反正是真的谢谢了. 我认真的读了原码,发现在生成古诗的函数中,有一个子函数: pick_char(weights). 这是一个随机函数啊, 正常应该是取argmax()啊, 但我修改后,发现进入死循环. 应用pick_char(weights)确实可以避开死循环,不过pick_char因为是随机,也使得训练变得没有意义了~