EveningLin

EveningLin

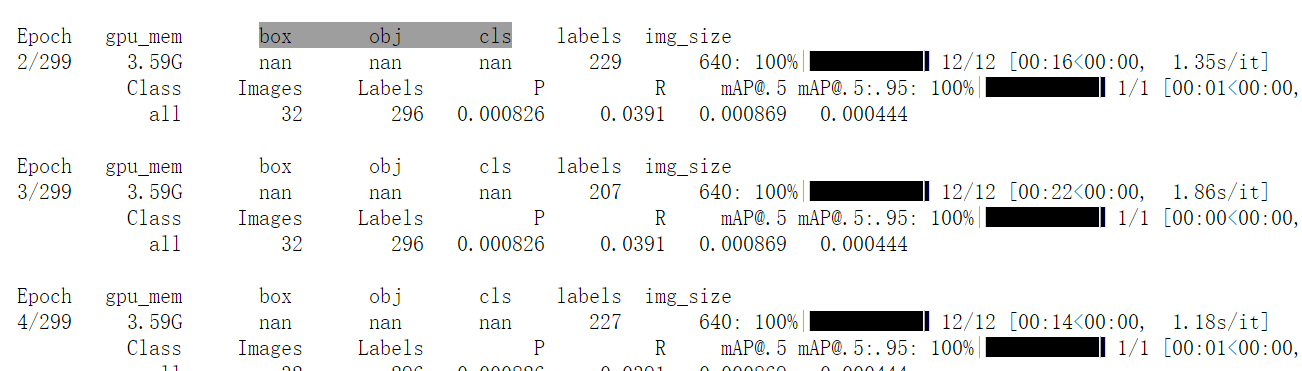

nan really confuse me

@VainF @haodehao @lrh454830526 @Willforcv 大哥们求教一下你们是边训练边剪枝还是训练完进行剪枝的呢?

@VainF 那在这种情况下的Finetuning,有没有什么训练上的细节要注意的?

还有一个问题就是我现在在剪枝的shufflenetv2是否需要像resnet一样在concat跳过剪枝呢?因为我在网上很少看见有这种轻量化骨架,很抱歉还要再次请教你 ---原始邮件--- 发件人: "Gongfan ***@***.***> 发送时间: 2023年2月1日(周三) 凌晨1:50 收件人: ***@***.***>; 抄送: ***@***.******@***.***>; 主题: Re: [VainF/Torch-Pruning] 无法进行剪枝 (#45) @VainF 那在这种情况下的Finetuning,有没有什么训练上的细节要注意的? 最简单的处理是降低初始学习率,一般可以用训练阶段学习率*0.1来finetune模型。另外fintuning的迭代次数可以设的比较小,比如1/2,1/4甚至1/10,不过这取决于问题的复杂度。其他配置基本和训练一致就可以了。 — Reply to this email directly, view it on GitHub,...

> > 还有一个问题就是我现在在剪枝的shufflenetv2是否需要像resnet一样在concat跳过剪枝呢?因为我在网上很少看见有这种轻量化骨架,很抱歉还要再次请教你 > > […](#) > > ---原始邮件--- 发件人: "Gongfan _**@**_._**> 发送时间: 2023年2月1日(周三) 凌晨1:50 收件人: _**@**_.**_>; 抄送: _**@**_._**_**@**_.**_>; 主题: Re: [VainF/Torch-Pruning] 无法进行剪枝 (#45) @VainF 那在这种情况下的Finetuning,有没有什么训练上的细节要注意的? 最简单的处理是降低初始学习率,一般可以用训练阶段学习率_0.1来finetune模型。另外fintuning的迭代次数可以设的比较小,比如1/2,1/4甚至1/10,不过这取决于问题的复杂度。其他配置基本和训练一致就可以了。 — Reply to...

@VainF 我现在还是想尝试手动剪枝一下ShuffleNet,想请教一下如果是通过监督bn的y来实现稀疏化训练的话,对于ShuffleNet中的pw和dw卷积怎么样才是最有效的剪枝方式呢?亦或者是有残差的部分完全不进行剪枝操作?

@dldaisy I'm curious about how your new dataset is used and processed!May you introduce it? i am working almost the same work as you do ! Thank you in advance!

@jiangjiajun @sixsixQAQ @edwardzhou @ZeyuChen @zh794390558 重装到11.7还是不行,各位大佬是怎么解决的

@saunair @samadhiiiii @guppykang @eric-yyjau @Valeyards I have also noticed that the network results seem to be a bit different. During the down-sampling phase, he also performed a max pooling...