戏命师

戏命师

并行化计算事情远远没有这么容易的,我昨天修改的时候也遇到了这个bug,修改好了,在train_model函数里: 将所有的原本DataParallel的变量改成DataParallel.moudle变量类型就能够正常运行了(这里指的是能跑,不是并行计算成功了。。。) 之所以不成功,问题我觉得出在forward函数里,因为DataParallel有这么个问题: 后向计算以更新梯度时,因为grad_fn在dataparallel中,所以也要将更新梯度的方法放入到dataparallel中去。但是遗憾的是DataParallel计算得到的Variable中的属性grad_fn为torch.nn.parallel._function,而普通的网络所得到的对应grad_fn为torch.autograd.function。而前者不能用于backward() 所以还得继续修改代码。。。 加油吧!为了部落!

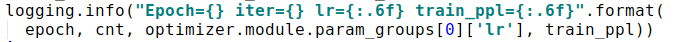

其实也没什么难的,就是如图将train_model()里model和optimizer改一下就好 我刚又仔细看了看,其实我也拿不准,我觉得是forward或者train_model 里有很多Variable数据类型,也使用了很多cuda(),这些应该是制约了GPU的使用,如果真想改的话,应该是从这方面改吧

您好,是training elmo的时候我们想使用fine-tune功能; 另外麻烦问您一下,我们训练语料的时候,想用多显卡进行训练,然后发现 python -m elmoformanylangs.biLM train --gpu 里只能支持一个显卡,是否有方法支持多个显卡呢? 谢谢大佬了!

对于第一个,不好意思没解释清楚~ 就是我们自己的语料是医疗方面的语料,而且十分零散,一来,我们是想用您已经训练好了的模型上再加上自己的语料进行训练(因为我们自己训练出来的模型在专业领域上很好,但是在人名等常识方面就不如您的模型了),二来,是想随时有新的语料更新进来能够再次训练模型; 非常感谢大佬指教~ PS:能和大佬交流真的好兴奋~