Tianhao Gao

Tianhao Gao

meet same problem with same data

you can change the raw data that in Engish/un/timex2norm/alt.vacation.las-vegas_20050109.0133.apf.xml and alt.vacation.las-vegas_20050109.0133.sgm. In this two files,you can search "Doctors Without" and change following é to e .and the problem will solve.

看了一下可能是我数据划分的问题,您使用的数据划分就是ace2005preprocessing里的默认数据划分吗

每个word 对应 token 的index,因为只保留word第一个token进行训练。别的直接扔了

> 还没有正式发布,可以先参考 https://github.com/IDEA-CCNL/Fengshenbang-LM/tree/hf-ds/fengshen/examples/clip_finetune 你好,可否分享一下微调太乙的环境requirements,昨天在单卡以及多卡调试均会报错,单卡错误 AssertionError: Attempted unscale_ but _scale is None. This may indicate your script did not use scaler.scale(loss or outputs) earlier in the iteration. 查了一下感觉是版本的问题,我当前pytorch_lightning版本是1.7.0。

> > 微调示例: https://github.com/IDEA-CCNL/Fengshenbang-LM/tree/main/fengshen/examples/clip_finetune finetune clip的相关版本: pytorch-lightning 1.6.2 torch 1.9.0+cu111 torch-tb-profiler 0.3.1 torchaudio 0.9.0 torchmetrics 0.8.2 torchsummary 1.5.1 torchvision 0.10.0+cu111 感谢分享,代码成功跑起来了,但是依然有一些小问题。 1.单卡训练时,会报 image_mbs = torch.chunk(image, n) RuntimeError: chunk expects `chunks`...

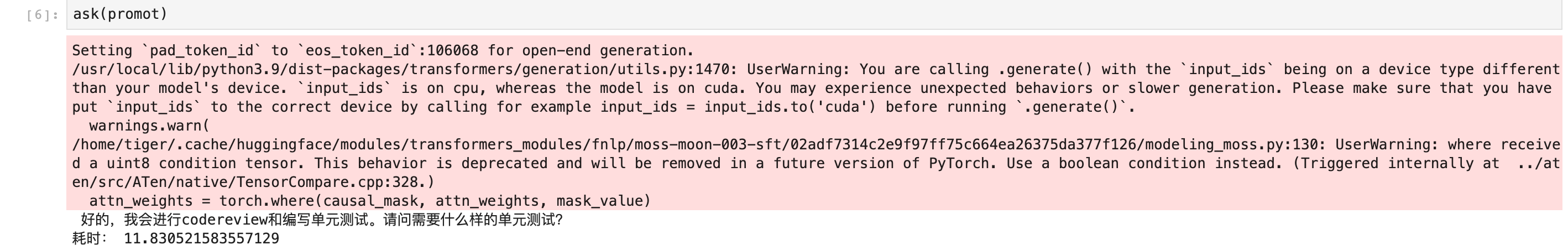

>  估计回答不出来才是正常现象

generate的repetition_penalty设置大一点,no_repeat_ngram设置一下。试试

调bloomz的时候会有同样的错误,alpaca-lora,alpaca-Cot和BELLE上面都会报这个错误。有无好心人告诉怎么解决

> 调bloomz的时候会有同样的错误,alpaca-lora,alpaca-Cot和BELLE上面都会报这个错误。有无好心人告诉怎么解决 破案了,我之前用的P40,换了A100能用了