MOSS

MOSS copied to clipboard

MOSS copied to clipboard

推理结果的长度不足怎么调整,或者怎么让它继续推理

目前设备的量是够的,性能都是够的,配了4卡,但是推理的时候发现性能都没有拉满,慢就不说了,还非常的短,每次废话讲半天到重要的地方就截断了

您好,请问您部署的方式是怎样的,推理用的代码是?截断是指生成了eom还是cuda报错

按照readme里的多卡部署,用jupyter测试的,我这边想用来做一些生成单元测试和代码审查。但是给出的回答tokens很短。说到一半就截止了。不知道该怎么调整,这边用了4张Tesla V100

请问有输出的截图吗

截断截图稍等我晚点上传,我得重新跑下,有点慢

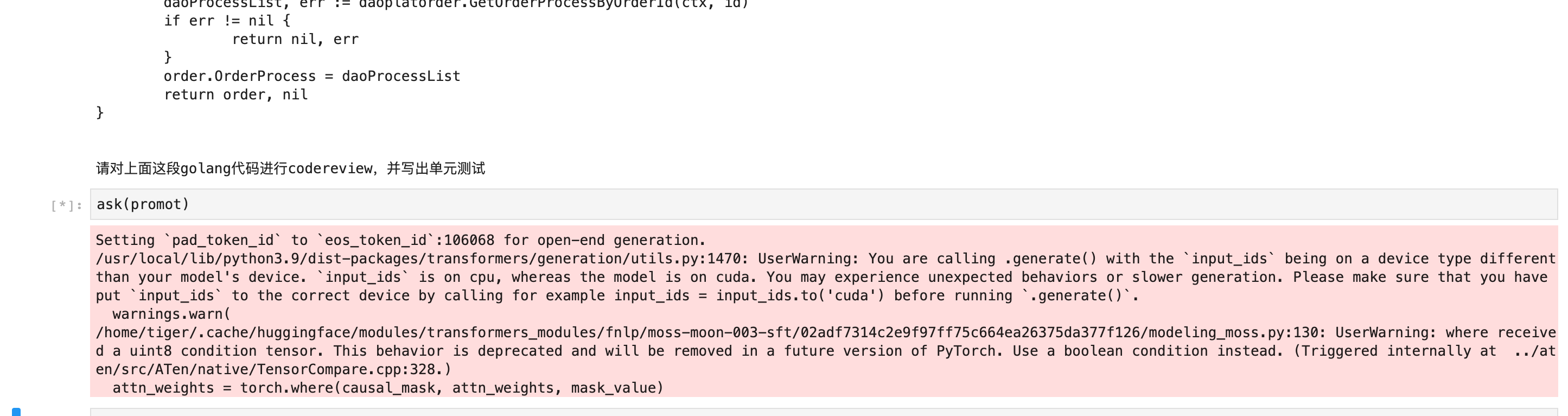

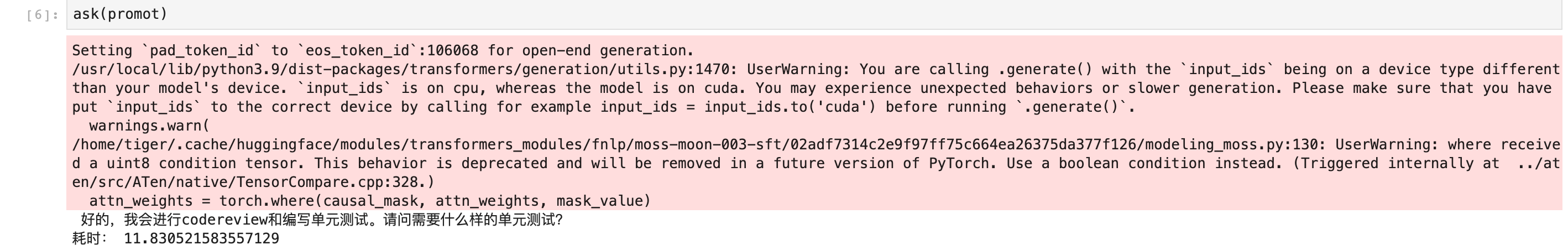

现在是这样,不认真回答了

现在是这样,不认真回答了

估计回答不出来才是正常现象

我部署了一些大语言模型,很多需要设置回复的max_token,目前设备在采购中还未部署,你可以看一下是不是有token的限制

这个只有max_new_tokens=256 这个参数, 但是我改大到2048 似乎没什么变化

设置 skip_special_tokens=False ,打印response看最后是不是 eom,如果是(我觉得大概率是),那说明模型就只给你这点输出。