Wang Yi

Wang Yi

此PR完成了: 为idea创建t5任务 - 搬运了megatron的dataset,并在其中增加了关于tokenizer添加[BOS]、[EOS]、 for i in range(100)等token的代码

此PR完成了: - 在 project/ 下面添加了gpt的loss对齐内容 - 在 project/ 下面添加了T5的loss对齐内容

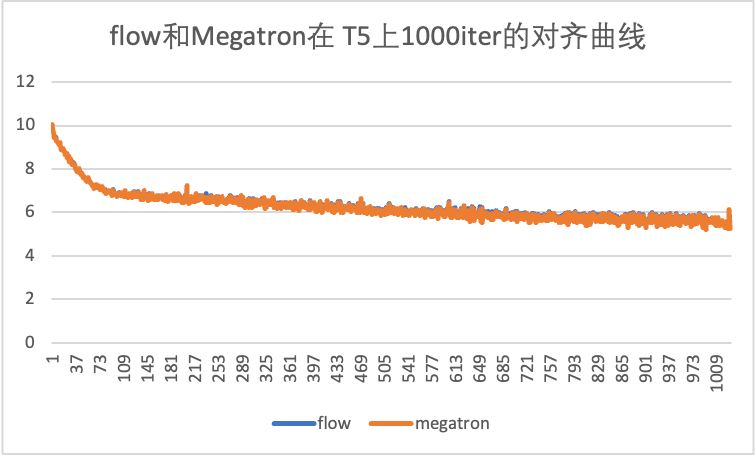

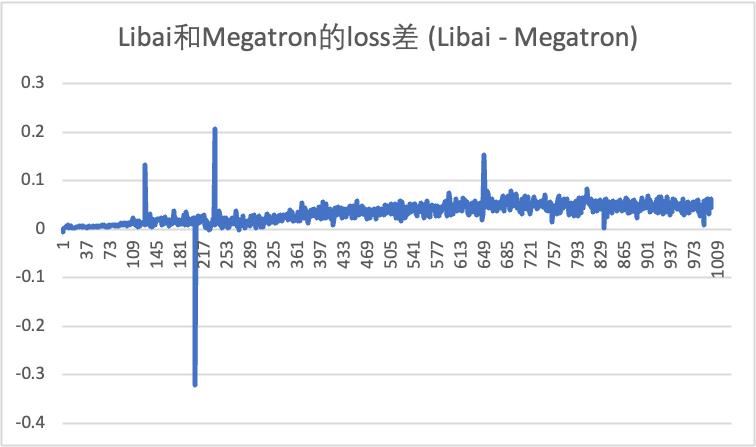

此PR完成了: 复现了和Megatron对齐的T5模型 对齐曲线如下

概述:实现了 oneflow.nansum 算子 实现: - 和 reduce_sum 思路类似,但是增加了一个 binary_func: nansum - backward 和 reduce_sum 相同,都是 ones_like - 原来的 reduce 系列算子中,当某个需要 reduce 的 dim 上的 size 为 1 时,会自动进行 memcpy 操作。这里和...

背景:espnet2需求 概述:增加了缺失的两个 Learning Rate Scheduler:Cyclic LR 和 OneCycle LR 注意事项: 在 torch 中,这两个 scheduler 有如下特点: - 输入有 `lr` 和 `momentum` 相关参数,会在构造函数中覆盖掉 `optimizer.param_group` 的状态,比如 `momentum`、`initial_lr`等 - 输入 `lr` 时,支持输入 list,该 list...

## Summary 带有 BatchNorm2d 的模型在开启 amp 和 grad acc 时会报错。 - 注释掉模型中 BN 层,保留 amp 和 grad acc,不会报错 - 注释掉 grad acc,保留 BN 层和 amp,不会报错 - 注释掉 amp,保留 BN 层和...

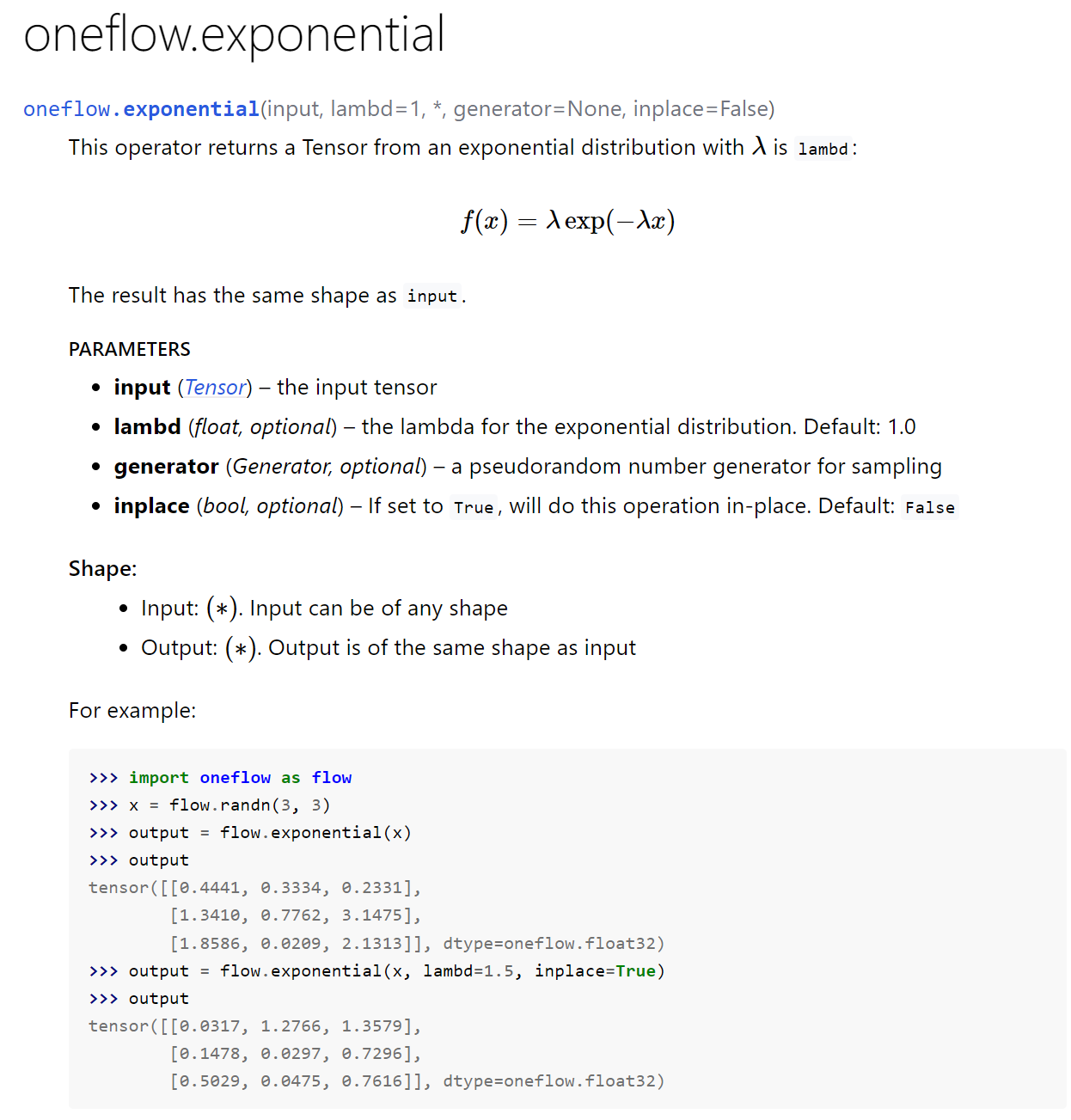

背景:https://github.com/Oneflow-Inc/OneCloud/issues/136#issuecomment-1185260240 概述:缺少指数分布的随机数生成算子 文档截图:

https://github.com/Oneflow-Inc/oneflow/pull/8888 的另一种实现 背景:https://github.com/Oneflow-Inc/OneCloud/issues/104#issuecomment-1156122806 概述:oneflow的ctc_loss不接受int64的target输入而torch能 实现: - 直接在functor层cast,而不是注册kernel - 删除了max_target_lengths参数,在functor里面计算

Add cdist op

cdist 对于两个输入 x1 (shape=[B, R1, C]),x2 (shape=[B, R2, C]),计算每个 batch 内 x1 和 x2 每一行向量之间距离的p范数,得到结果 result (shape=[B, R1, R2])。 torch 文档见 https://pytorch.org/docs/stable/generated/torch.cdist.html