linklist2

linklist2

请问您知道这个问题的答案了吗,我测试也是都接近于0 @wyzwyzzzzz

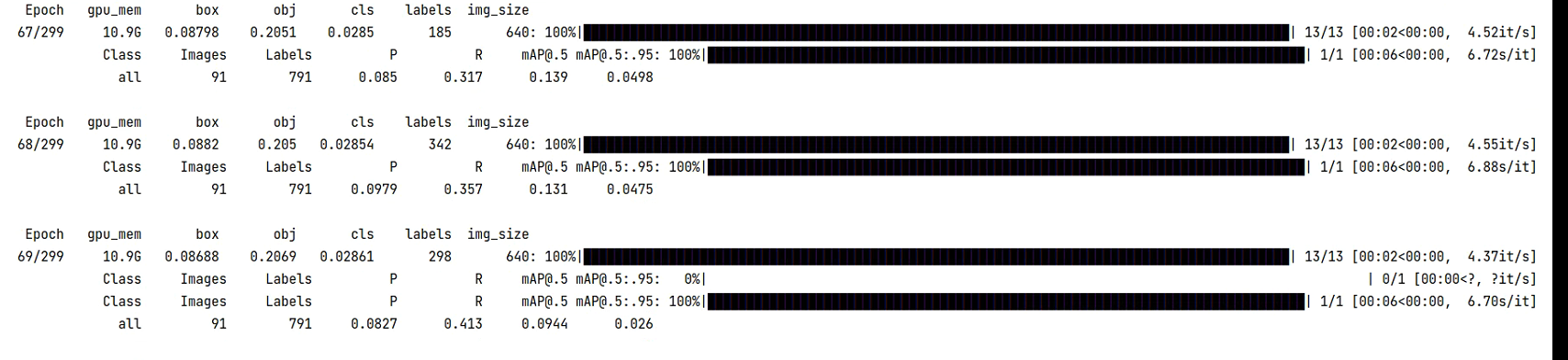

@Gumpest 您好,我在RSOD数据集上进行测试,剪枝部分,但是剪枝后的模型在微调的时候mAP一直上不去该如何解决啊。  是数据集的问题吗?

> 你好,我也有同样的问题,请问你找到调参的教程了吗,能否给个链接 并没有,没人回答我,放弃了

> 朋友,我看了你发的参数,调参的好坏指标相差这么多啊,但是我不知道如何根据自己的数据集调出合适的参数 > […](#) > ------------------ 原始邮件 ------------------ 发件人: "Gumpest/YOLOv5-Multibackbone-Compression" ***@***.***>; 发送时间: 2021年12月13日(星期一) 晚上7:22 ***@***.***>; ***@***.******@***.***>; 主题: Re: [Gumpest/YOLOv5-Multibackbone-Compression] 您好,大佬,训练自己的数据集该如何进行调参呢? (Issue #29) 你好,我也有同样的问题,请问你找到调参的教程了吗,能否给个链接 并没有,没人回答我,放弃了 — You are receiving this because you commented. Reply to...

加载了,不加载的话只有0.7不到的总mAP

加载了 ------------------ 原始邮件 ------------------ 发件人: "Gumpest/YOLOv5-Multibackbone-Compression" ***@***.***>; 发送时间: 2021年12月13日(星期一) 晚上7:50 ***@***.***>; ***@***.******@***.***>; 主题: Re: [Gumpest/YOLOv5-Multibackbone-Compression] 您好,大佬,训练自己的数据集该如何进行调参呢? (Issue #29) 好的,朋友,你使用这个仓库的代码,有继续加载yolov5.pt预训练权重文件,在自己的数据集上训练吗?还是说直接不加载,从头在自己的数据集上训练 ------------------ 原始邮件 ------------------ 发件人: "Gumpest/YOLOv5-Multibackbone-Compression" ***@***.***>; 发送时间: 2021年12月13日(星期一) 晚上7:40 ***@***.***>; ***@***.******@***.***>; 主题: Re: [Gumpest/YOLOv5-Multibackbone-Compression] 您好,大佬,训练自己的数据集该如何进行调参呢? (Issue #29) 朋友,我看了你发的参数,调参的好坏指标相差这么多啊,但是我不知道如何根据自己的数据集调出合适的参数 …...

差别不明显,有点忘了 ------------------ 原始邮件 ------------------ 发件人: "Gumpest/YOLOv5-Multibackbone-Compression" ***@***.***>; 发送时间: 2021年12月13日(星期一) 晚上8:30 ***@***.***>; ***@***.******@***.***>; 主题: Re: [Gumpest/YOLOv5-Multibackbone-Compression] 您好,大佬,训练自己的数据集该如何进行调参呢? (Issue #29) 请问你用这个大佬的代码跑的效果,有比v5原型好吗 ------------------ 原始邮件 ------------------ 发件人: "Gumpest/YOLOv5-Multibackbone-Compression" ***@***.***>; 发送时间: 2021年12月13日(星期一) 晚上8:17 ***@***.***>; ***@***.******@***.***>; 主题: Re: [Gumpest/YOLOv5-Multibackbone-Compression] 您好,大佬,训练自己的数据集该如何进行调参呢? (Issue #29) 加载了 ------------------ 原始邮件 ------------------...

> 因为第二个bn层通道如果减少了,就不能和输入的featuremap相加了。 我明白了,谢谢您

> 对prune_model_keep_size2和update_activation的理解 > > block: conv1-bn1-leaky1-conv2-bn2-leaky2 > > 在prune_model_keep_size2中,依据bn层γ来选择哪些层被剪,小于阈值的层要被剪掉。 但被减去层的bias(β)还是会影响到结果,因此我们对BN1.weight筛选后还需要将被剪通道的bias转移至后续层计算,这样减少bias的影响 为什么说是减少呢? 回顾BN层计算:w*x+b,这儿w即γ,bias即b w小于阈值的直接被置0,但在训练过程中w可能非常小,但也很微妙影响到输出。w趋向0,则对应层输出受bias控制。 > > prune_model_keep_size2处理逻辑: > > 1. 将BN1中γ小于阈值的层权重置0 > 2. 将BN1中γ小于阈值的层的bias转移至后一层计算 > 怎么转移? > 先求取出被剪层cut_layers(即1-mask对应的层)的激活输出,这些激活输出就可以看做是对应层实际计算结果的近似(即bias),因为w趋向0了嘛 > 好了,下面计算cut_layers在后续层的值,后续层是conv2,那么conv后的输出即offset >...

@YeLL0W 非常感谢,我想我明白了