YiTSu

YiTSu

> 可以使用更小的UIE模型来极速 有没有调参的办法呢。比如调整一些参数使速度更快? 另外,我想了解一下对于不同的模型大小,你们那边的预测速度大概是多少呢?想了解下20ms的速度是否跟你们对齐了。

> > > 可以使用更小的UIE模型来极速 > > > > > > 有没有调参的办法呢。比如调整一些参数使速度更快? 另外,我想了解一下对于不同的模型大小,你们那边的预测速度大概是多少呢?想了解下20ms的速度是否跟你们对齐了。 > > 目前比较快的方式就是切换模型到uie更小的模型上,这个相对也是比较方便的; > > 速度方面是没有办法发布出来的,因为速度和每个应用的schema设计有关系,schema越是复杂则耗时越多,没有办法统一一个耗时 小模型和大模型的区别在哪里呢?会不会导致抽取能力有差异呢

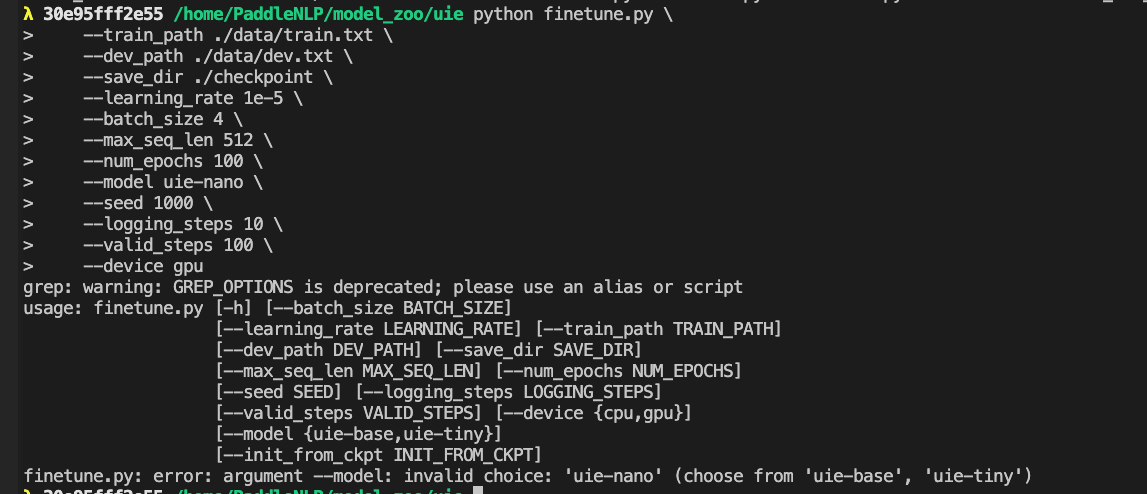

> > > 可以使用更小的UIE模型来极速 > > > > > > 有没有调参的办法呢。比如调整一些参数使速度更快? 另外,我想了解一下对于不同的模型大小,你们那边的预测速度大概是多少呢?想了解下20ms的速度是否跟你们对齐了。 > > 目前比较快的方式就是切换模型到uie更小的模型上,这个相对也是比较方便的; > > 速度方面是没有办法发布出来的,因为速度和每个应用的schema设计有关系,schema越是复杂则耗时越多,没有办法统一一个耗时  为何只能从二者选一个呐

> OK了解,不过uie-tiny这个也是个小模型吧?应该也可以用哈?

> > > > > > > > > OK了解,不过uie-tiny这个也是个小模型吧?应该也可以用哈? > > 可以的, uie-tiny 和 uie-medium 是同一个模型,新发布的tiny系列模型把命名规范统一了 换了小模型后耗时完全没有变化,有什么建议吗。目前耗时20ms的确还是有些长