PaddleX

PaddleX copied to clipboard

PaddleX copied to clipboard

PaddlePaddle End-to-End Development Toolkit(『飞桨』深度学习全流程开发工具)

问题类型:模型部署 **问题描述** ======================== 使用paddleX提供的deploy/cpp代码,根据官方说明修改cmakelist,修改model_infer.cpp,生成dll文件进行部署。 在c#项目加载dll后进行推理报错,跟踪dll的代码后:在如下部分报错0x00007FFDE64B742C (paddle_inference.dll)处(位于 cs_paddle_infer_dll.exe 中)引发的异常: 0xC0000005: 写入位置 0x000000000000000F 时发生访问冲突。 ``` bool PaddleInferenceEngine::Init(const InferenceConfig& infer_config) { const PaddleEngineConfig& engine_config = *(infer_config.paddle_config); paddle_infer::Config config; if ("" == engine_config.key) {...

问题类型:模型部署 **问题描述** ======================== 请在这里描述您在使用过程中的问题,说明您的部署环境,部署需求,模型类型和应用场景等,便于开发人员快速响应。

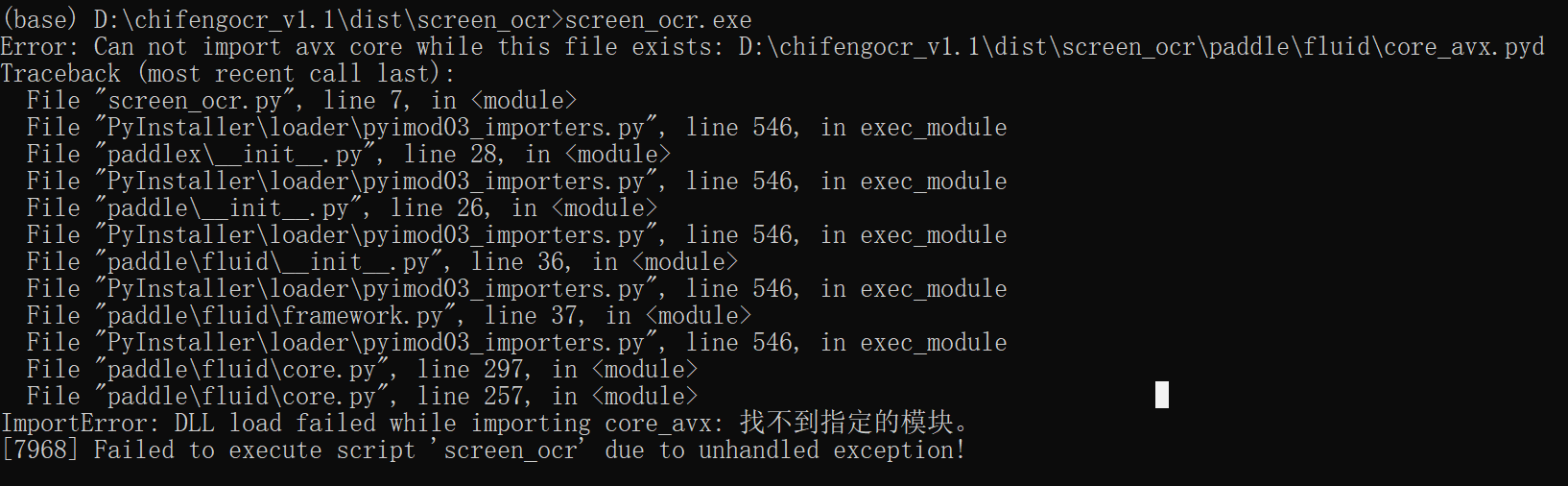

问题类型:其它  **PaddleX版本** ====================== python 3.8.5 paddlepaddle 2.2.1 paddlex 1.3.11 **问题描述** ======================== pyinstaller 打包报错,是因为paddlx 1.3.11 与paddlepaddle 2.2.1 不兼容的问题吗?如何解决这个问题?

(此 ISSUE 为 PaddlePaddle Hackathon 活动的任务 ISSUE,更多详见[PaddlePaddle Hackathon](https://www.paddlepaddle.org.cn/PaddlePaddleHackathon)) 【任务说明】 - 任务标题:为PaddleX新增TVM部署方式支持 - 技术标签:深度学习框架,模型部署,TVM - 任务难度:中等 - 详细描述:PaddleX 支持飞桨多个CV套件模型的部署,也支持多种推理引擎,包括OpenVINO、TensoRT、PaddleInference等。目前TVM已集成Paddle支持,为了进一步提升用户的部署体验,在PaddleX中新增TVM的部署方式 【提交内容】 - 项目 PR 到 [PaddleX](https://github.com/PaddlePaddle/PaddleX) - 相关技术文档 - 项目单测文件 【技术要求】 -...

问题类型:模型部署 **问题描述** 生成dll成功,部署时,模型加载失败。   ,看到是加载模型的·,python 推理也可以推理,使用的是mask  ,模型初始化就直接闪退

问题类型:其它 **PaddleX版本** 您使用的PaddleX版本 2.0.0 **问题描述** 如题

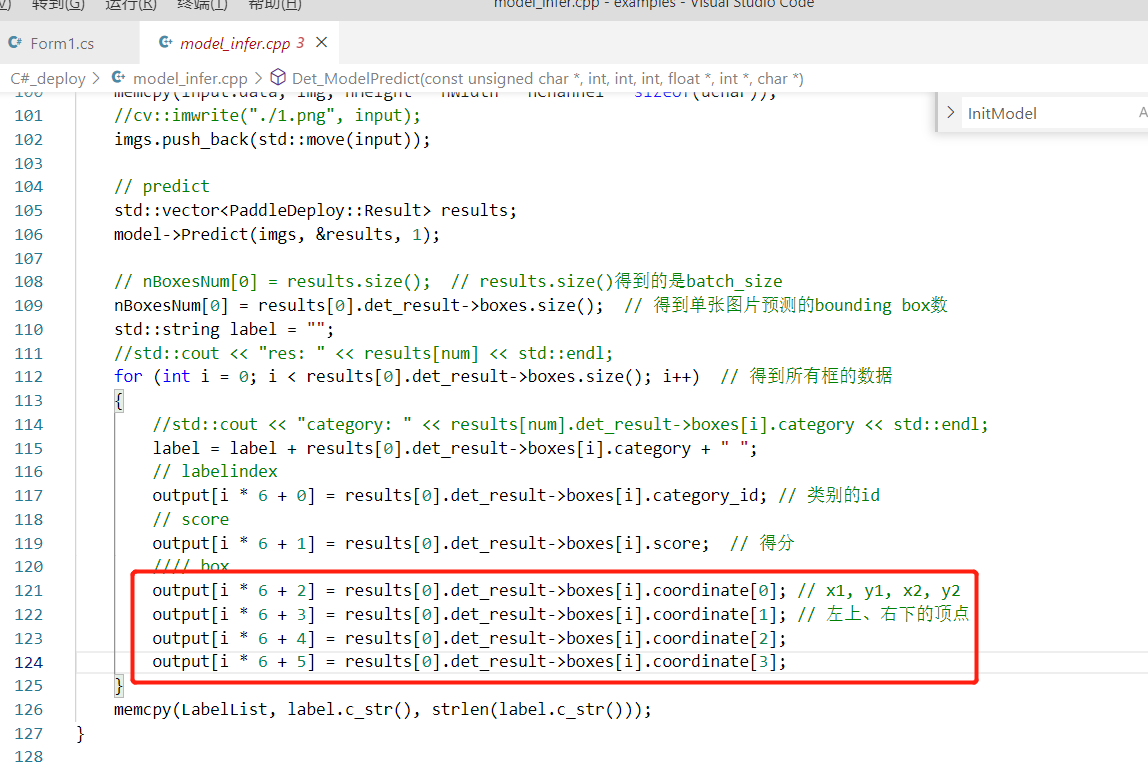

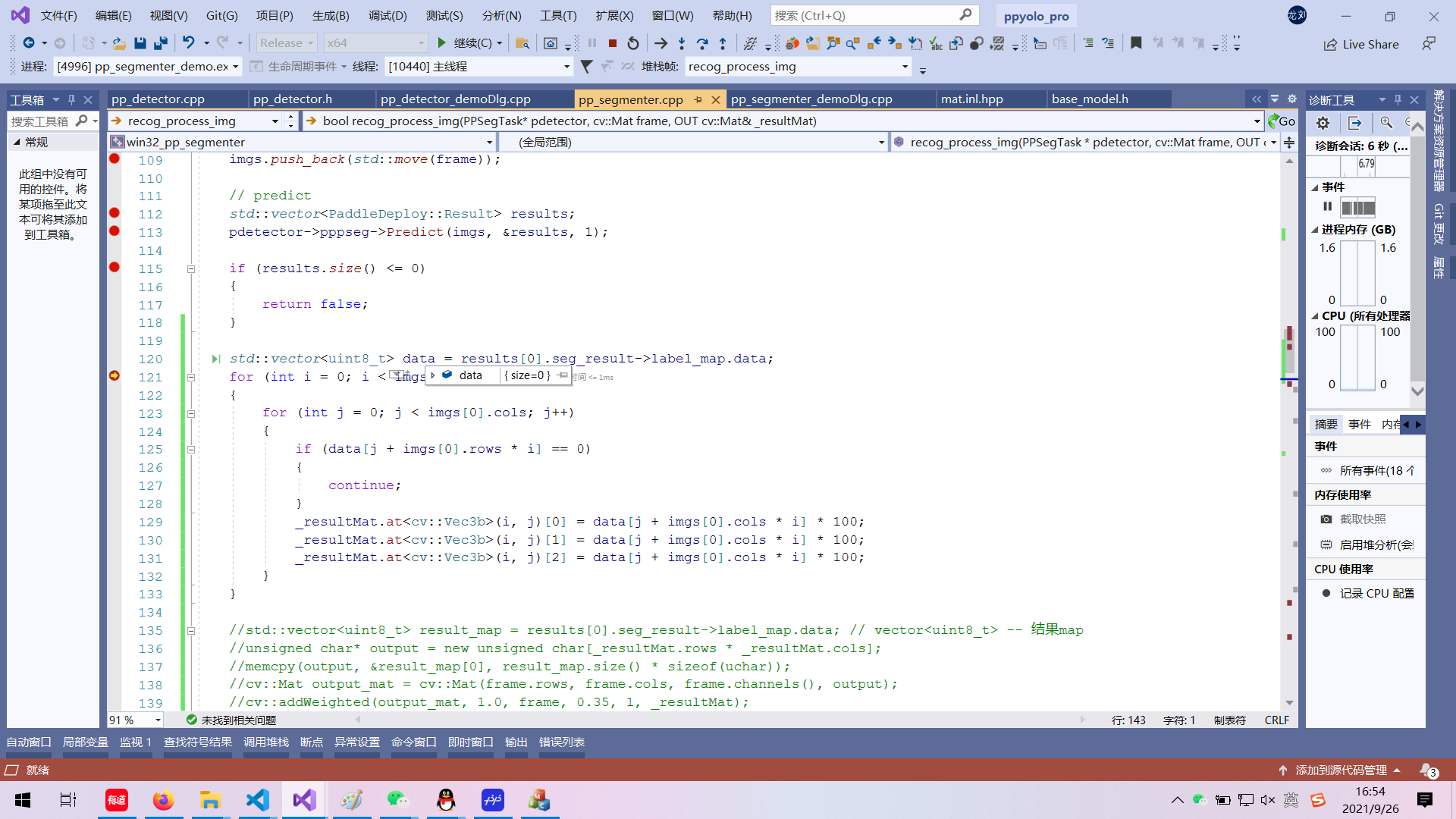

第一:detector里面推理出来的坐标信息不对:  这里坐标应该是,左上角坐标和框的长宽,这样才是对的,排查了老半天才发现。 另外,检测里面,没做阈值顾虑和iou过滤,看到阈值过滤是放到了外面,但是iou过滤外面也没做。 第二:seg分量,使用PaddleX.exe里面的样例:视盘分割,训练出来的代码,使用seg模块加载后推理,推理处理的data为1024,但是暗像素访问data[j + imgs[0].cols * i这样必越界,远远大于1024,没法可视化:  可否提供你们测试使用的模型,找了半天都没找到测试使用cpp的模型,然后自己训练的视盘分割,但是不知道是模型训练问题,还是啥问题。 cpp里面提供了,四种类型的推理,det seg clas mask,可否都提供一个代码调试的模型和测试图片?

问题类型:模型部署 **问题描述** c# 调用 c++生成的.dll文件过程中开启了 tensorrt加速发生了报错,报错内容见以下图片,说的是‘please enable trt dynamic_shape mode by SetTRTDynamicShapeInfo’, 但不知如何配置的具体步骤,求解答。 ======================== 请在这里描述您在使用过程中的问题,说明您的部署环境,部署需求,模型类型和应用场景等,便于开发人员快速响应。

问题类型:模型部署 **问题描述** 设备硬件环境:英伟达2080ti,CUDA10.2,CUNN7.6,TensorRT 7.0 PaddleX分支PaddleX-release-2.0.0rc3 参考model_infer.cpp 更改为分割模型,生成dll和lib,编写MFC程序,初始化模型时选择GPU方式,调用生成的dll和lib。读取文件夹下的图片可以实现图像的分割,接入工业相机采集后,将采集的图像(一段内存地址)内部已经生成为opnecv的Mat图像传给深度学习预测推理程序就报错,报错的地方为ppinference_engine.cpp的Infer函数,中的 in_tensor->CopyFromCpu(im_tensor_data);这句话,我一开始觉得是相机没有数据或者数据的格式不对,特地在传入推理程序前,将相机采集的图像保存,图像没有问题,后来我将初始化时改为CPU方式,也可以实现图像的语义分割。想问下这个是什么问题?读取文件夹下的图片进行语义分割没有问题,改为CPU方式下读取工业相机也没有问题,在GPU下就出现上述错误? ======================== 请在这里描述您在使用过程中的问题,说明您的部署环境,部署需求,模型类型和应用场景等,便于开发人员快速响应。

-------------------------------------- C++ Traceback (most recent call last): -------------------------------------- 0 paddle::framework::SignalHandle(char const*, int) 1 paddle::platform::GetCurrentTraceBackString[abi:cxx11]() ---------------------- Error Message Summary: ---------------------- FatalError: `Process abort signal` is detected by the operating system. [TimeInfo:...