Fu Dayuan

Fu Dayuan

如题

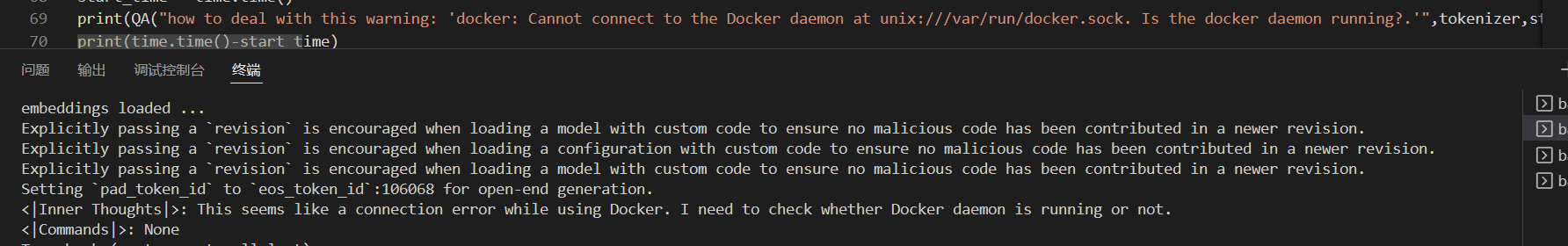

如图,因为我把你们的网络插件部署到server端口的时候出了点问题(图里的报错),就像看看MOSS能不能解决我的问题: ),不过他直接回答了“: None”导致下一步的检索过程没办法执行。这该怎么办呢? (顺便一问,有不用docker的后端部署方法吗?虽然直接load你们的网络插件还挺快的(比加载模型快很多))

I just use the code below to check the environment ``` import time import ai2thor.controller controller = ai2thor.controller.Controller(port=5900,x_display="10") controller.start() print(f"Start Resetting") controller.reset('FloorPlan28') print(f"Start Initializing") controller.step(dict(action='Initialize', gridSize=0.25)) for i in range(10):...

如果tokenize “阅读者”,在结果中没有pad token(290)(仅有阅读、者、结束符三个token).我在其他的例子中都没有发现这个bug

I receive such log so I report it. I use Ubuntu 20.04.4 LTS and java version "11.0.15.1", and my JAVA_PATH is /usr/local/java/

也就是每篇文章是什么时候发表的?

it seems that codalab only gives 100MB discs instead of 10GB and one hour now(I fill the form but not apply). Under this setting, it seems I can not upload...

1. 文章中说"对于Agent-FLAN实验,我们遵循AgentTuning中的做法,将ShareGPT和Agent语料库以1:1的混合比例混合进行训练。"  我注意到你们给出了数据集,想请教一下你们数据量和配比是什么呢?(包括flan版本和你们复现的agenttuning版本)(shareGPT应该就90000多条吧,你们是把这几个怎么混合(or过采样)到一样的呢?) 2.想在了解一下超参数的问题,因为我看agenttuning有一些非常奇怪的超参数,您这里是直接使用deepspeed默认的超参数吗?(for example 10%的warmup,最大token是2048还是4096之类的)

很想了解一下你们的项目,请问有文章中所说的50个问题以及他们的难度等级吗?