ChengsongLu

ChengsongLu

> > same question > > solved using latest docker version which version of docker you are using? mine: Docker version 26.0.0, build 2ae903e docker-compose version 1.25.0, build unknown

我的文档中有一个短句A,我让大模型根据A扩写句子为B,然后A作为query,B作为pos是可以的吧?(有点反直觉,不知道这个操作会不会影响效果)

> 您好,如果您只想 finetune bge-m3 的 dense embedding,二者没有区别,可以参照 bge-v1.5 的参数进行微调 https://github.com/FlagOpen/FlagEmbedding/tree/master/examples/finetune#3-train 还是有区别的吧?bge-m3支持中英文,而bge-1.5只是单语言不是吗

你好,请问你们说的QA和QQ数据分别表示的是,问答数据和相似句子数据对吗。

另外,英文的passages用中文的query,这样的数据用来微调是可以的吗?(微调BGE-M3)

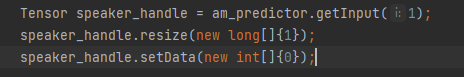

> 在请教了子龙之后,问题得到解答。 Java目前确实不能设置long类型的数据,因此在将模型转为静态模型时,需要将[am_to_static方法](https://github.com/PaddlePaddle/PaddleSpeech/blob/1af9bd47d964f7c9f56be5a3b214687627eabfb7/paddlespeech/t2s/exps/syn_utils.py#L413)中的int64(long)改为目前Java支持的类型 我这边将int64改为了int32,再将模型转为静态模型,然后使用该静态模型转为移动端可用的naive_buffer模型,在输入讲话人id时,使用int类型输入就能正常输出  > > 感谢子龙的解答,给子龙加鸡腿 你好,请问模型转为静态和转回naive_buffer的过程在哪,从哪里可以修改。多说话人好像text和spk_id都要求为long类型

I am using the same device as yours, an running the command as showing above, the problem persist no matter how many times I try.

torch 2.0.1 diffusers 0.24.0 can I ask which version of diffusers you're using?

Do you mind to post your pip requirement.txt file to this repo?

Yep, I am on linux. My pip list showing below: ``` absl-py 2.1.0 accelerate 0.26.1 addict 2.4.0 aiofiles 23.2.1 altair 5.2.0 annotated-types 0.6.0 anyio 4.3.0 attrs 23.2.0 basicsr 1.4.2 cachetools...