tensorRT_Pro

tensorRT_Pro copied to clipboard

tensorRT_Pro copied to clipboard

C++ library based on tensorrt integration

请问,能否出一个多线程推理视频流的demo?让我们学习一下

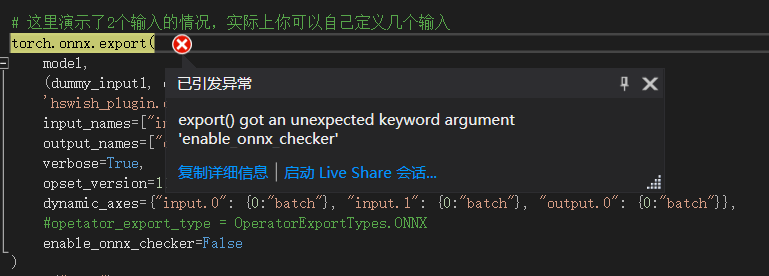

老师,您好!我在windows下配置了pytorch1.11.0,在对自定义插件进行export()时,会报异常  查看原生函数接口,发现在1.11.0版本下enable_onnx_checker并不在export()的参数列表中。请问在不换pytorch版本的情况下有没有什么好的解决方法。

刚刚实验了一下 yolov5 6.2模型无法使用旧的(6.1)版本代码转出onnx 使用6.2的参数转出的onnx模型无法被trtpro读取

您好,tensorRT_Pro的作者,非常感谢您的无私奉献。有个问题需要请教您,我在使用您提供的example-simple_yolo时,遇到yolo*.onnx模型转换为yolo*..FP*.trtmodel时,生成的trrmode模型体积比onnx更大,推理速度没有提升的问题。

According to app_fall_recognize(), three models are used. auto pose_model_file = "sppe.FP32.trtmodel"; auto detector_model_file = "yolox_m.FP32.trtmodel"; auto gcn_model_file = "**fall_bp.FP32.trtmodel**"; We use pose model, human detection model and gcn model. The...

[2022-08-23 14:34:48][info][app_yolo.cpp:132]:===================== test YoloX FP32 yolox_m ================================== [2022-08-23 14:34:48][info][trt_builder.cpp:474]:Compile FP32 Onnx Model 'yolox_m.onnx'. [2022-08-23 14:34:49][error][trt_builder.cpp:30]:NVInfer: /home/tcy/dev/tensorRT_Pro-main/src/tensorRT/onnx_parser/ModelImporter.cpp:736: While parsing node number 249 [Resize -> "onnx::Concat_921"]: [2022-08-23 14:34:49][error][trt_builder.cpp:30]:NVInfer: /home/tcy/dev/tensorRT_Pro-main/src/tensorRT/onnx_parser/ModelImporter.cpp:737: --- Begin node...

大佬,unet还会接着做吗?比如unet++之类的