thomaszheng

thomaszheng

> > 配置文件没有对吧。 你安装【预训练示例】章节的示例来操作 > > 我最后是把 init_checkpoint 改成 albert 官方项目提供的那个中文预训练模型就可以了,不知道您提供的版本和官方的有哪些差异呢? 我用google的albert,加载albert_zh上下载的模型会遇到同样的报错,加载albert上的zh模型是正常的。

是说这个报错信息是不影响的,模型是成功转换的

确实可以推理,这个错误目前看不影响转换后的模型使用

@shentanyue 链接: https://pan.baidu.com/s/1OvU7GRYU4Sju2vDyLNKgqQ 提取码: e4fn 里面包含模型,和生成so文件

@sprouteer 你好,网盘中的模型和so,你这边会遇到同样的报错吗?

我们项目中以前的模型都是使用tensorflow的部署方案,后续希望新增的模型还是可以复用之前的部署方案,不希望增加部署这块相关的成本。

嗯,paddle的部署的方案我们也是有使用的,支持也是非常好的。只是我们在一些业务上需要和之前保持一致的。 我们也是在尝试了onnx-tensorflow转换失败后(paddle->onnx是没有问题),才在你们这提的issue。因为onnx那边沟通和开发效率感觉都不高,而且链路比较长,所以问问看看你们有没有计划。

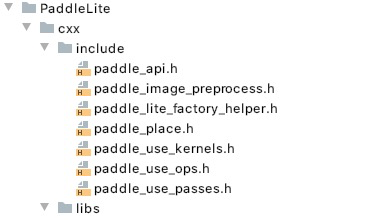

> 静态库使用需要包含paddle_use_op.h 和 paddle_use_kernel.h 具体内容请查看C++文档:https://paddle-lite.readthedocs.io/zh/latest/user_guides/cpp_demo.html 我搜了一下整个paddlelite的项目,自己编译还是官方提供的预编译的库,都没有这两个头文件的。 目前项目里面用的头文件是:

那就是头文件是正确的话,这个报错是什么原因呢?

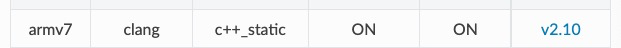

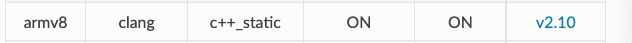

下载的是官方文档中提供的这两个