HyperLPR

HyperLPR copied to clipboard

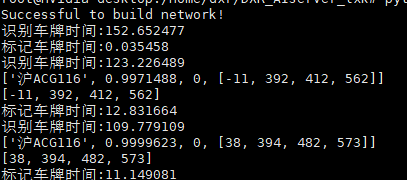

tensorrt和cuda速度比cpu还慢

tensorrt和CUDAExecutionProvider的时候比CPU跑还慢,这合理吗

tensorrt和CUDAExecutionProvider的时候比CPU跑还慢,这合理吗

请提供给我们更多的信息,比如是cpp平台还是python平台

请提供给我们更多的信息,比如是cpp平台还是python平台

您好。是arm架构的python平台,Provider采用CPU的时候时间最快

@tunmx 有结果了吗是因为onnx中间的原因吗

onnxruntime框架推理在Provider指定为CUDAExecutionProvide推理有时候确实比cpu慢,这个我在yolo8上遇到过类似的情况。如果把onnx模型转化为tensorrt了,然后速度还是很慢,这就不合理了

哈罗,邮件收到了,我会尽快查看,回复,谢谢!