openspeech

openspeech copied to clipboard

openspeech copied to clipboard

batch_size 2에서 학습을 하였는데, out of memory가 발생을 합니다.

❓ Questions & Help

batch_size 2에서 학습을 하였는데, out of memory가 발생을 합니다. 사용된 GPU는 Tesla V100 32GB, 2장을 사용하였습니다. 전체 메모리를 대부분 사용하던데 학습에 사용된 장비와 배치 사이즈를 좀 알수 있을까요??

Details

어떤 모델 사용하셨는지 등의 정보를 저희에게 주실래요?

저도 동일한 오류를 겪고 있습니다. openspeech/dataclass/configurations.py 에서 BaseTrainerConfigs 클래스의 batch_size의 default를 32에서 1로 줄인 후에도 동일한 오류가 발생하여 질문 남깁니다. 앞서 있었던 Tokenizer Nonetype error에 관해서는 질문을 올려주신 분과 동일하게 처리하여 넘어갔습니다.

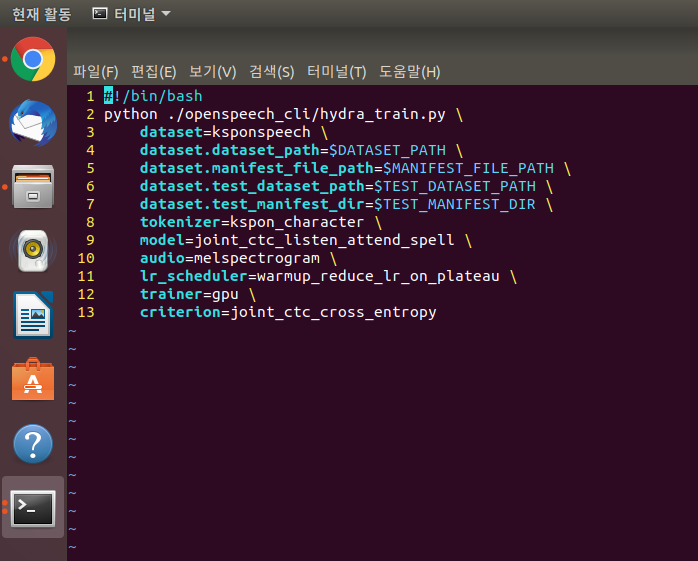

실행 명령입니다.

각 패스는 알맞게 설정해주었습니다.

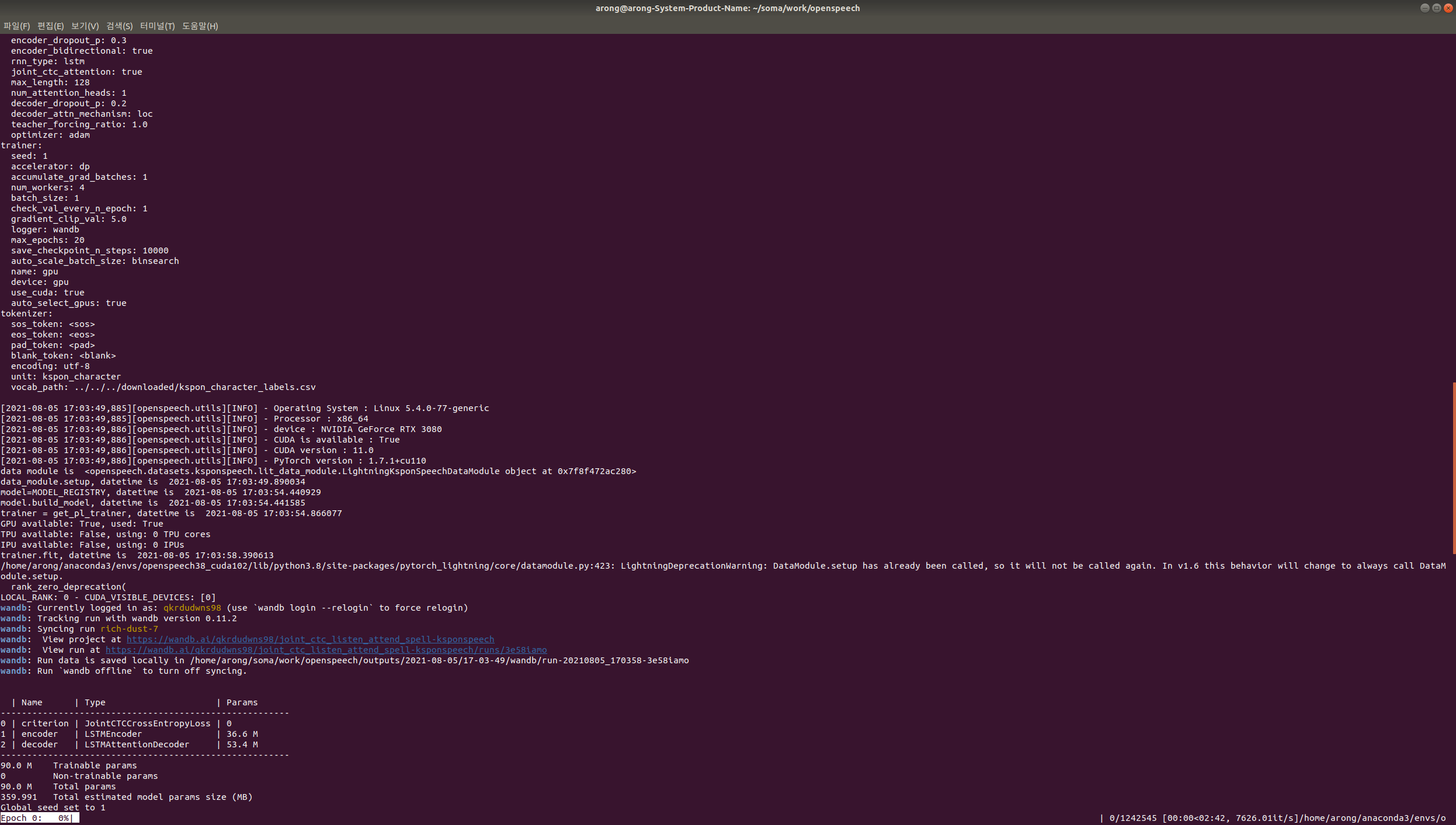

gpu는 rtx3080 10gb 사용중입니다.

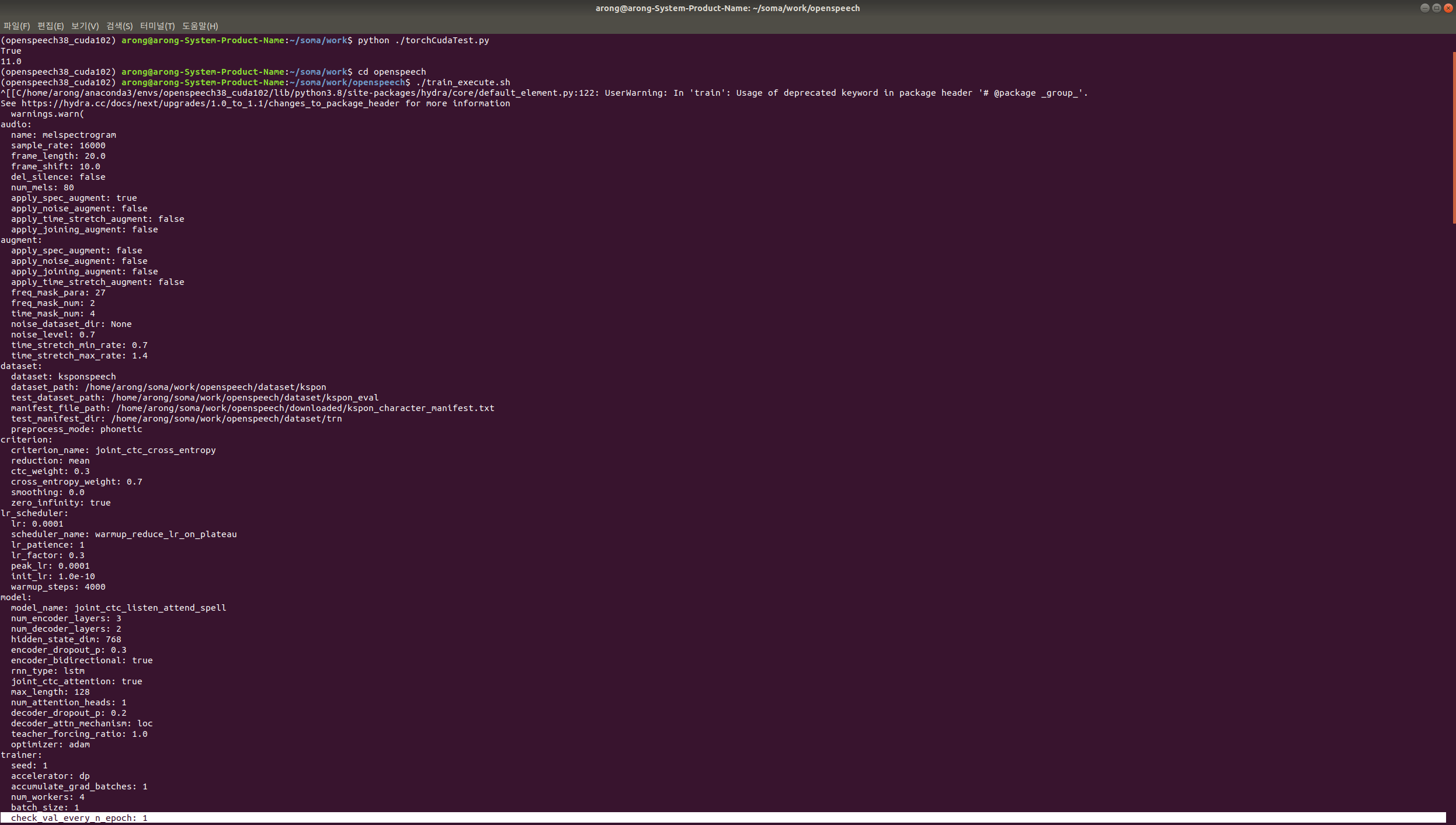

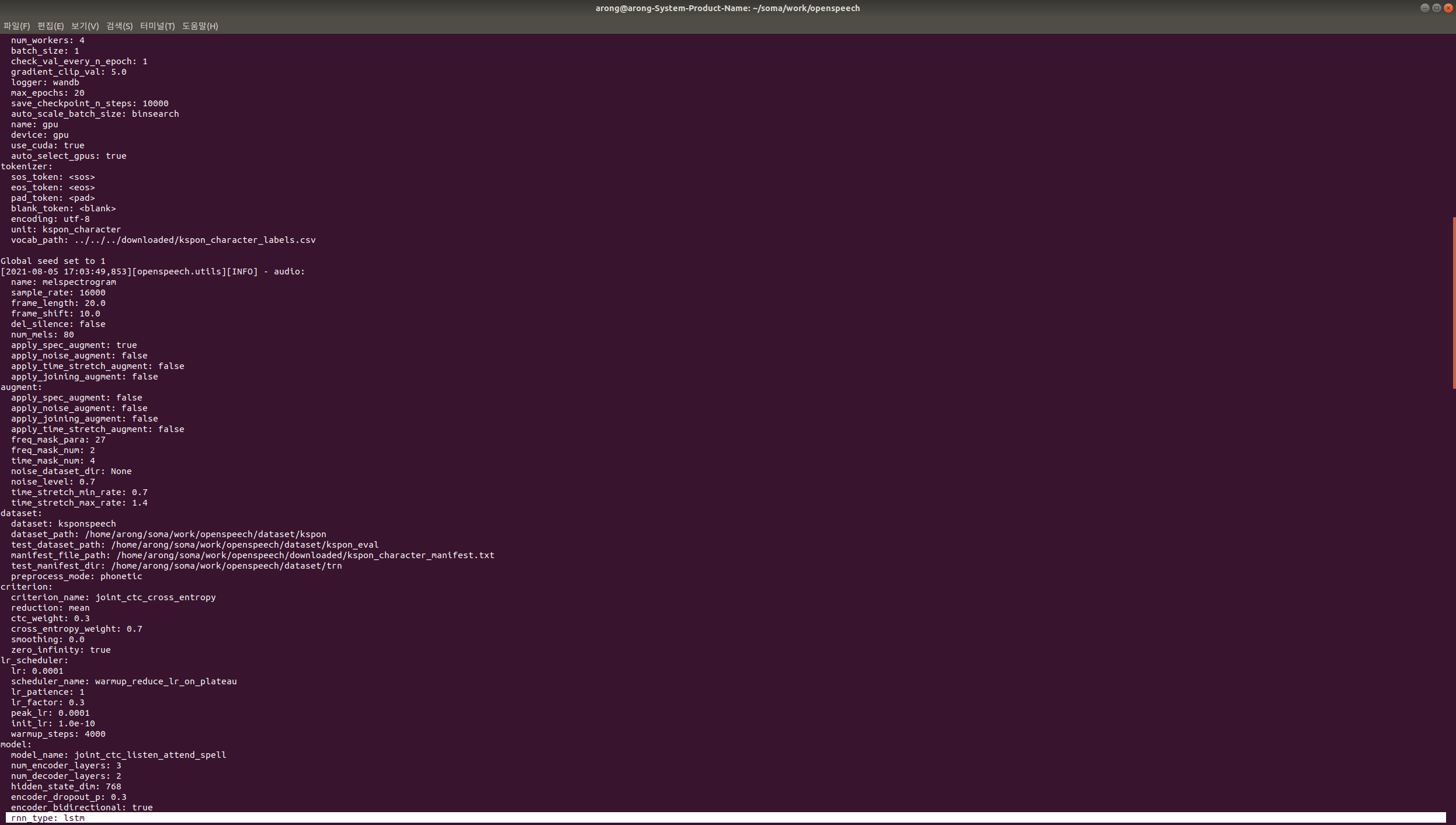

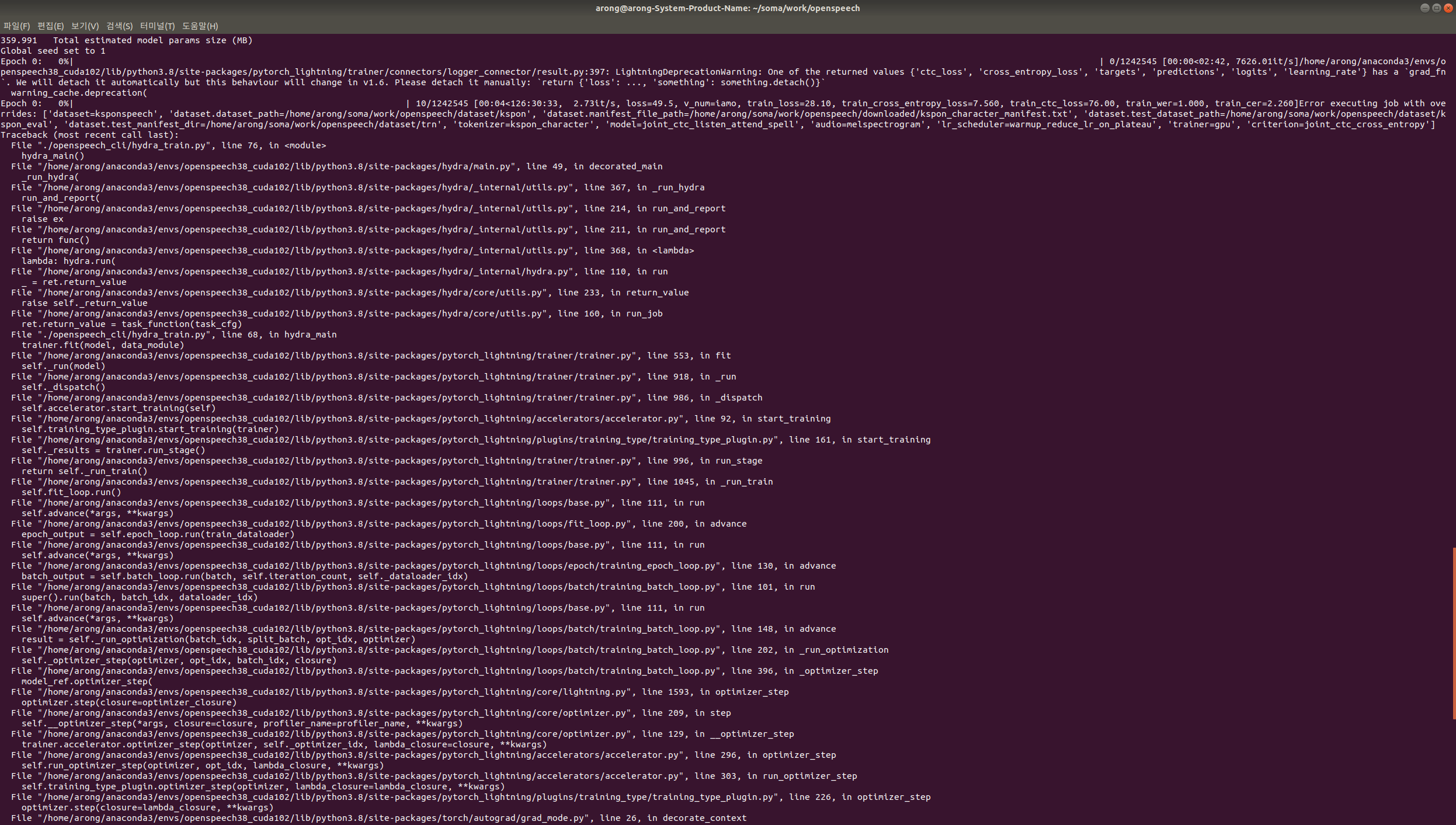

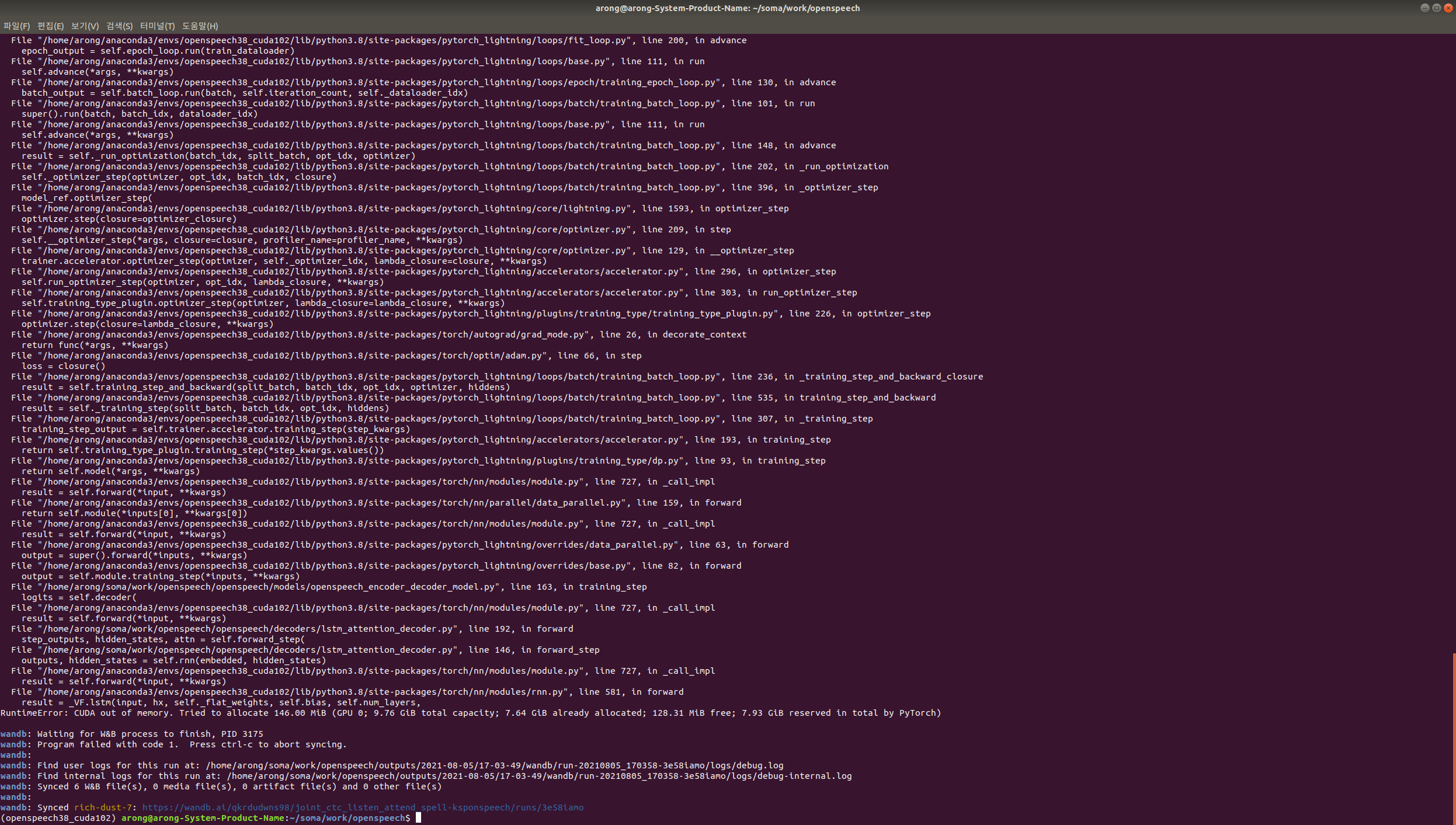

실행 로그입니다.

감사합니다.

저도 동일한 명령어로 모델을 사용하였습니다. 감사합니다

@hasangchun

답이 늦어 죄송합니다. 최근 일이 바빠 신경을 쓰지 못했네요.

rtx3080 10gb에서는 아무래도 OOM에러가 날 확률이 높습니다.

오디오 길이가 긴 데이터는 빼주고 학습을 진행하는것을 추천드려요.

V100 32GB에서 2대에서 배치사이즈 2로 에러가 난다는건 조금 의아한데요.

혹시 아직 에러가 나고 있을까요?