Kai Li

Kai Li

楷体加粗问题解决了吗

我觉得恰恰相反,我觉得作者前两章写的很好,看得出来是经过静心思考的,特别是作者一直强调什么是随机变量,什么是观测值,而且文中所有公式都将两者进行显式区分,还有期望那部分,到底是对谁求期望,到底哪些东西是随机的,哪些是确定的,我觉得写的很好,这些其实在RL paper里都没有特别区分,好多公式直接就是一个期望的符号,新手根本不知道对谁求期望,容易产生疑惑。

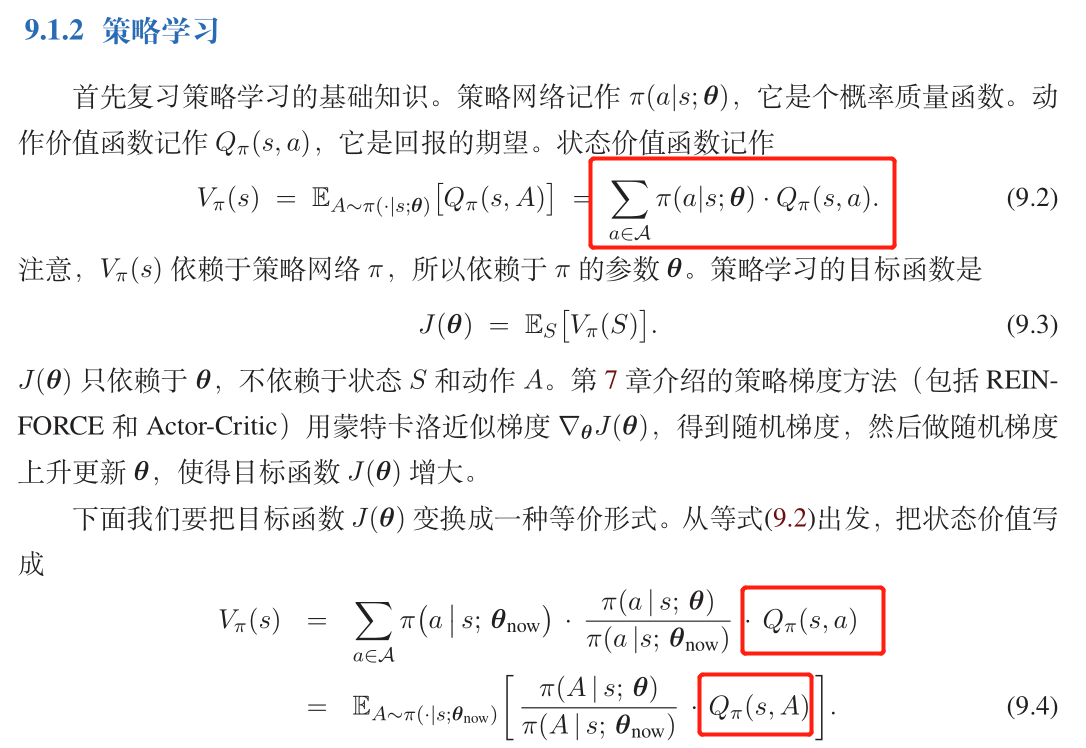

按照前面的推导,感觉Q_phi(s,a)应该指的是策略theta的Q值 那么就相当于用theta_now的策略产生的样本估计theta的Q值了,这又相当于一个近似。 可以这么做的原因应该是theta_now和theta差异比较小吧。 如果我理解的正确,希望王老师可以把这部分再详细说一下,否则容易引起误导。

> 方便告诉我你的姓名吗?我在书里感谢一下你。 王老师,我是中科院自动化所的李凯,您这本书写的非常好,希望不断完善,可以作为国内学习RL的学生的必备书籍。

> 多谢!你非常厉害!找到了我从来没想到的问题。 王老师客气了,您的教学风格和写作风格我特别喜欢,能把复杂的问题简单化,很了不起,RL界的一股清流。

@patriciaaa82 @jonbakerfish I think you may find the answer here https://gluon.mxnet.io/chapter03_deep-neural-networks/mlp-dropout-gluon.html#Accessing-is_training()-status

@DuinoDu @JianjinChen 您好,您这个python的版本和作者公布的matlab 版本结果差别大吗?