ChatGLM-Efficient-Tuning

ChatGLM-Efficient-Tuning copied to clipboard

ChatGLM-Efficient-Tuning copied to clipboard

即使在训练集上,预测效果也非常差

1、训练集loss非常低: 83%|████████▎ | 200/240 [27:39<05:26, 8.16s/it]{'loss': 0.0011, 'learning_rate': 5.367076727981382e-05, 'epoch': 15.05}

2、预测代码:

python src/train_sft.py

--do_predict

--model_name_or_path glm/chatglm2-6b

--use_v2

--dataset dataset-cs

--max_source_length 3000

--max_target_length 100

--checkpoint_dir sft/checkpoint-200

--output_dir pred

--per_device_eval_batch_size 2

--predict_with_generate

--fp16

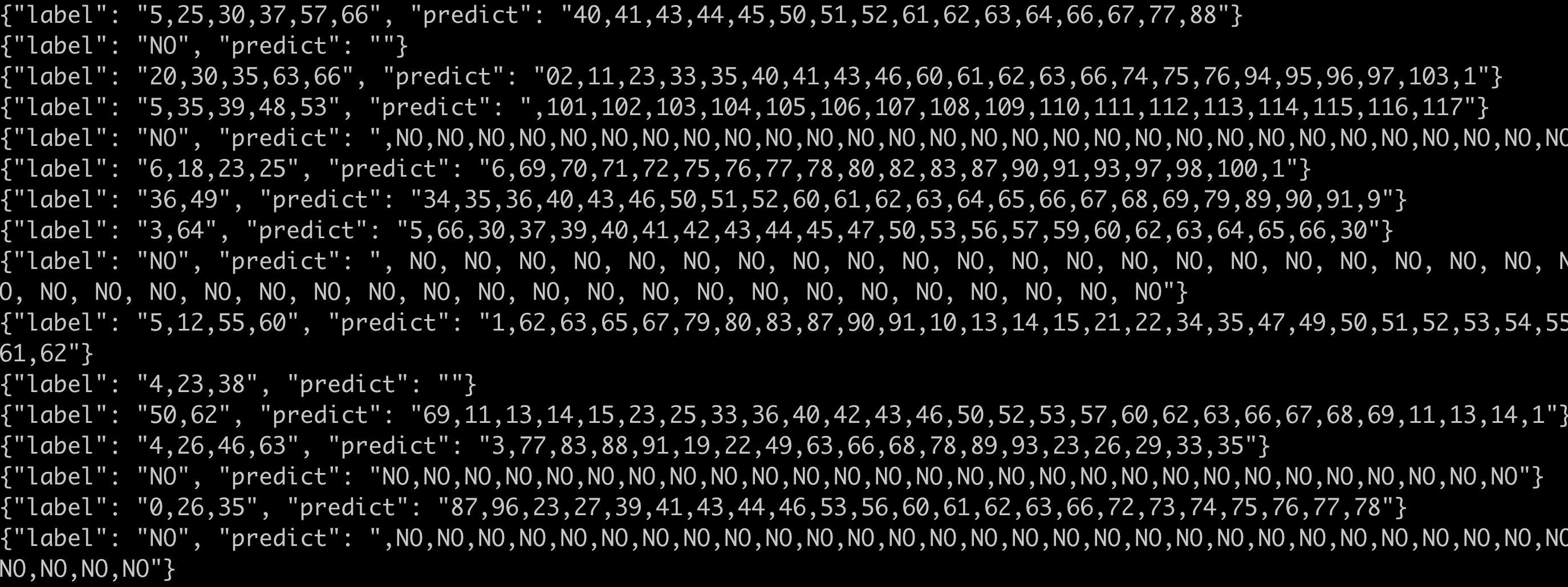

3、预测结果

有数据集吗?我本地复现一下

有数据集吗?我本地复现一下

内部私密数据,不方便发出来。

之前的预测脚本有 bug,现在已经更新,重新跑一下

1、训练集loss非常低: 83%|████████▎ | 200/240 [27:39<05:26, 8.16s/it]{'loss': 0.0011, 'learning_rate': 5.367076727981382e-05, 'epoch': 15.05}

2、预测代码: python src/train_sft.py --do_predict --model_name_or_path glm/chatglm2-6b --use_v2 --dataset dataset-cs --max_source_length 3000 --max_target_length 100 --checkpoint_dir sft/checkpoint-200 --output_dir pred --per_device_eval_batch_size 2 --predict_with_generate --fp16

3、预测结果