hf62580

hf62580

7767517 308 380 Input in0 0 1 in0 Convolution convrelu_0 1 1 in0 1 0=64 1=7 11=7 12=1 13=2 14=3 2=1 3=2 4=3 5=1 6=9408 9=1 Pooling maxpool2d_125 1 1...

Softmax_x86 平台的

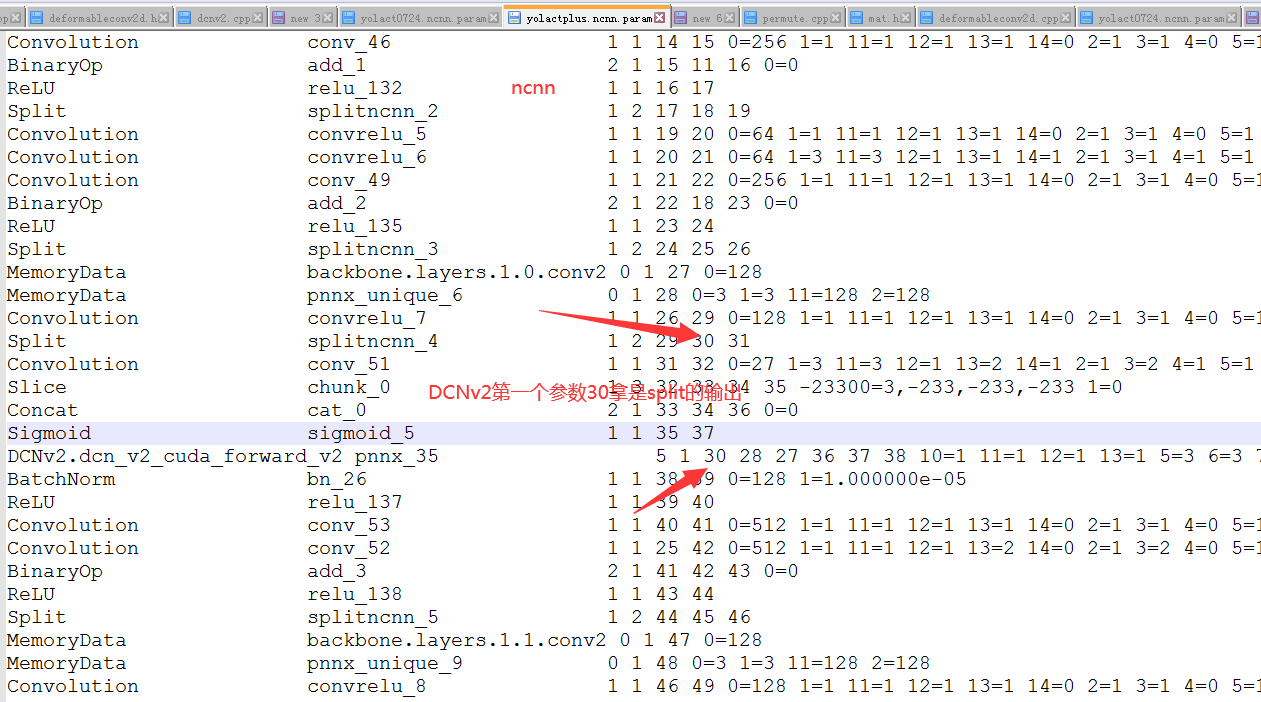

按你说的修复了代码,现在用yolact++的模型进行推理,出来的结果不对 这个是 yolact++的param参数 7767517 308 380 Input in0 0 1 in0 Convolution convrelu_0 1 1 in0 1 0=64 1=7 11=7 12=1 13=2 14=3 2=1 3=2 4=3 5=1 6=9408 9=1 Pooling...

> pnnx 会自动把模型末尾的 reshape transpose 删除,这里和原始模型不太一样 那我这边需要怎么处理?

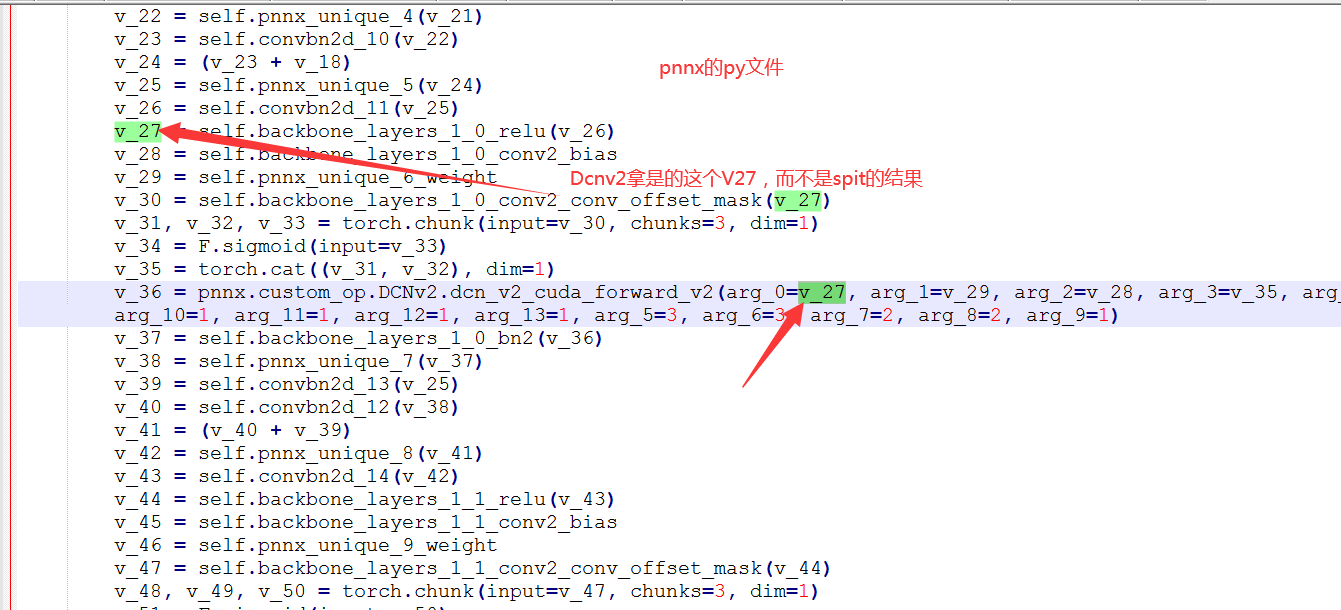

Ncnn的dcnv2的第一个输入,跟pnnx的拿的不一样,是不是有问题,还是我理解错了?

> #4074 通过你的代码修改之后,bottom_blob拿到的d还是1 然后通过print MemoryData的d值,拿显示的是0 int MemoryData::load_param(const ParamDict& pd) { w = pd.get(0, 0); h = pd.get(1, 0); d = pd.get(11, 0); printf("MemoryData d:%d\n",d); c = pd.get(2, 0); return 0;...

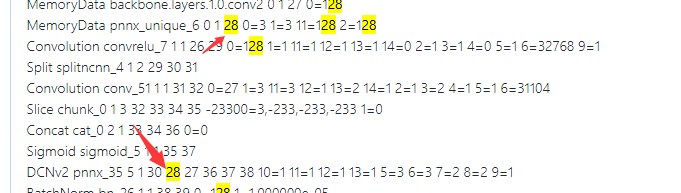

pd.get(11, 0);在load_param拿到了正确的参数(这里是128),但不知为何在forward的时候就拿不到了

7767517 310 382 Input in0 0 1 in0 Convolution convrelu_0 1 1 in0 1 0=64 1=7 11=7 12=1 13=2 14=3 2=1 3=2 4=3 5=1 6=9408 9=1 Pooling maxpool2d_125 1 1...

Dcnv2的 28输入的11参数拿得不对,其它的都对

我感觉是net的extract这里没有处理 好