ghostbreaken

ghostbreaken

> Hi! Thank you for this amazing repository. I want to build my own backbone and integrate it into pysot, what are the necessary steps and can you please list...

> 我也有这个问题,有时候加注意力反而掉点,我一直好奇注意力放哪才最有用,我之前放主干卷积块里效果并不好,现在放在检测头里,目前实验结果来看效果也不好,难道我没掌握注意力的正确使用方法?希望作者能解答下疑惑,谢谢! @xmu-xiaoma666 老哥,你好,请教一下你加注意力机制是在backbone上加的嘛?比如cbam你是引入了cbam模块嘛?放到了卷积输入的最后一层?

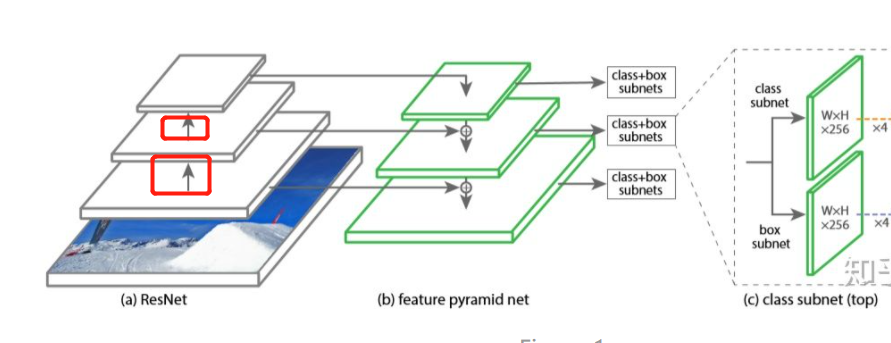

> @ghostbreake 一般两种方式:1.放在骨干网络的每个stage之间,放在最后一个stage居多吧 2.resblock的残差边上 > > 具体选哪个,看下原论文,没记错的话cbam是第一种方式的 老哥 感谢回复,每个stage之间指的是conv1和conv2中间这种嘛?

> @ghostbreaken 是layer层之间的位置,比如FPN输入位置 > >  > > 多谢老哥回复、老哥,你能留一个你的qq嘛?我有个具体问题想请教一下,感谢🙏

> 用matplotlib就行 老哥,能具体说一下嘛?相关代码在哪能能参考一下呢?我用matplotlib画出来的图不是论文里这种的,而是那种紫色背景,黄色目标的这种

作者,你有试过使用learned的position embedding嘛?和sine比差距大嘛?