KnowStreaming

KnowStreaming copied to clipboard

KnowStreaming copied to clipboard

一站式云原生实时流数据平台,通过0侵入、插件化构建企业级Kafka服务,极大降低操作、存储和管理实时流数据门槛

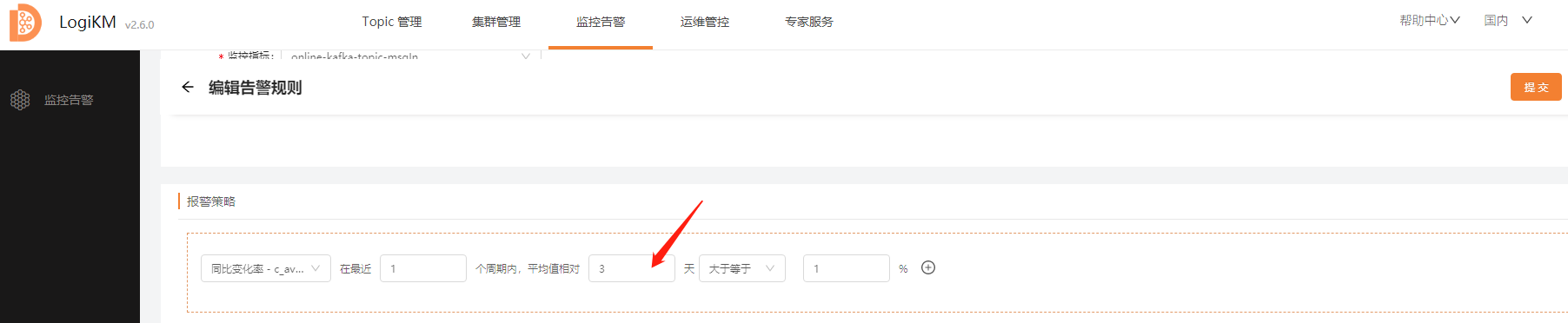

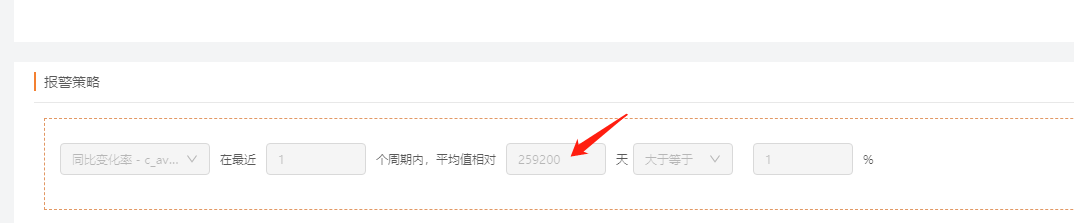

同比变化率 这个策略 里面的 天 字段 出现 填写的与之后显示的不一致

022-05-25 11:30:30.020 [pool-20-thread-15] ERROR c.x.k.manager.task.component.AbstractScheduledTask - customScheduled task running, but without registrant, and so sch eduled tasks can't execute, scheduledName:newCollectAndPublishCGData. 2022-05-25 11:31:15.136 [pool-20-thread-11] ERROR c.x.kafka.manager.service.cache.KafkaClientPool - create kafka admin client...

数据采样异常

#### 先说背景: Topic是自动创建的没有通过LogiKM,在集群接入LogiKM后,进行数据采样,发现不是空就是报错:  但是我通过命令` kafka-console-consumer & kafka-run-class kafka.tools.GetOffsetShell`是可以消费到数据的:

在进行迁移中,目前查看只支持集群内部迁移topic。 在后面的版本中,是否可以将集群A上面的所有topic进行迁移到新的集群上 目前只找到一个思路:https://blog.csdn.net/kafka_zsxq/article/details/121739868

用户权限问题

个人觉得用户角色定义的有点问题 之前也有人提过 研发人员可以删除修改运维人员的账号有点不合理  这种对用户的操作一般只有最高权限的角色才能操作 目前看来logikm的最高权限角色就是运维人员角色 个人拍脑袋的建议 普通角色 只读权限 申请等权限 研发角色 更高的读权限 申请审批等 运维角色 所有功能的读写权限 包括对用户的操作 集群的操作等等

您好,我们在使用km时遇到一个问题就是km的用户角色有3个,普通用户,研发,运维,目前我们建了一个普通用户开放给业务使用,但是发现在topic消费组中,普通用户可以使用重置offset,虽然需要停止应用,才会生效,但是我们认为这个权限开放给业务还是不太适合,我们需要完全的一个只读的账号,普通用户只查看和提交工单。 请问,关于这块有没有什么好的建议?

2022-02-08 11:42:15.164 [pool-16-thread-3] ERROR c.x.k.m.t.s.metadata.FlushBKConsumerGroupMetadata - collect consumerGroupSummary failed, clusterId:1 consumerGroup:connect-cluster. java.lang.IllegalArgumentException: Consumer Group connect-cluster with protocol type 'connect' is not a valid consumer group at kafka.admin.AdminClient.describeConsumerGroup(AdminClient.scala:165) at com.xiaojukeji.kafka.manager.task.schedule.metadata.FlushBKConsumerGroupMetadata.collectConsumerGroupSummary(FlushBKConsumerGroupMetadata.java:108) at...

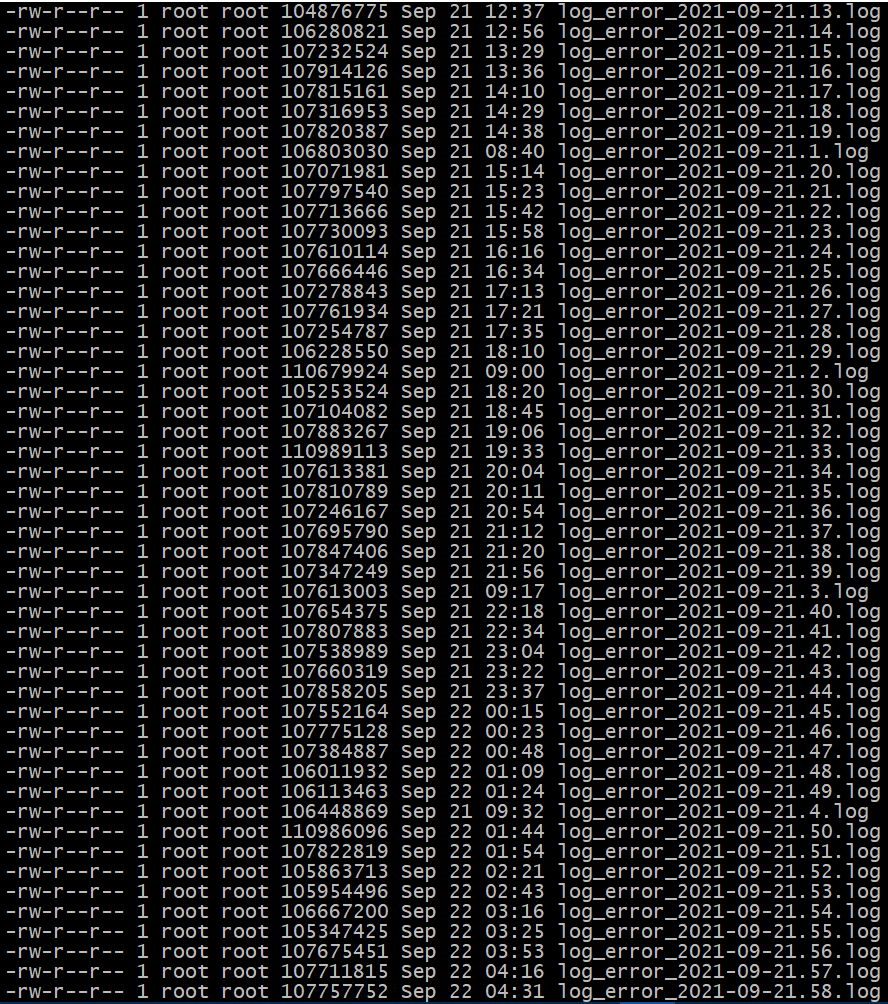

日志文件中暴露大量关于`c.x.k.manager.service.service.impl.JmxServiceImpl - get attributes failed,`的错误,具体内容如下: 日志内容,一天可能会打60多个log  然后看具体报错: ```java 2021-09-21 23:51:18.698 [Collect-Metrics-Thread-1-91] ERROR c.x.k.manager.service.service.impl.JmxServiceImpl - get attributes failed, metrics:TopicMetrics{appId='null', clusterId=8, topicName='CDC-IMX-CTO.dbo.INI', metricsMap={}} objectName:kafka.server:type=BrokerTopicMetrics,name=BytesOutPerSec,topic=CDC-IMX-CTO.dbo.INI. java.io.IOException: Connection closed at javax.management.remote.rmi.RMIConnector.getMBeanServerConnection(RMIConnector.java:400) at javax.management.remote.rmi.RMIConnector.getMBeanServerConnection(RMIConnector.java:389)...

LogiKM涉及到的监控视图貌似是存在bug,显示比较诡异 我在前端的一些页面中发现多次这样的图像,建议逐个排查一下,下图是“运维管控--集群列表--历史流量”发现的。

由于之前在2.4.2版本中存在删除Topic未同步删除DB信息,导致升级新版本后依旧存在之前不存在的Topic,显示在过期Topic中,有没有什么方法可以清理一下这种“幽灵Topic”。