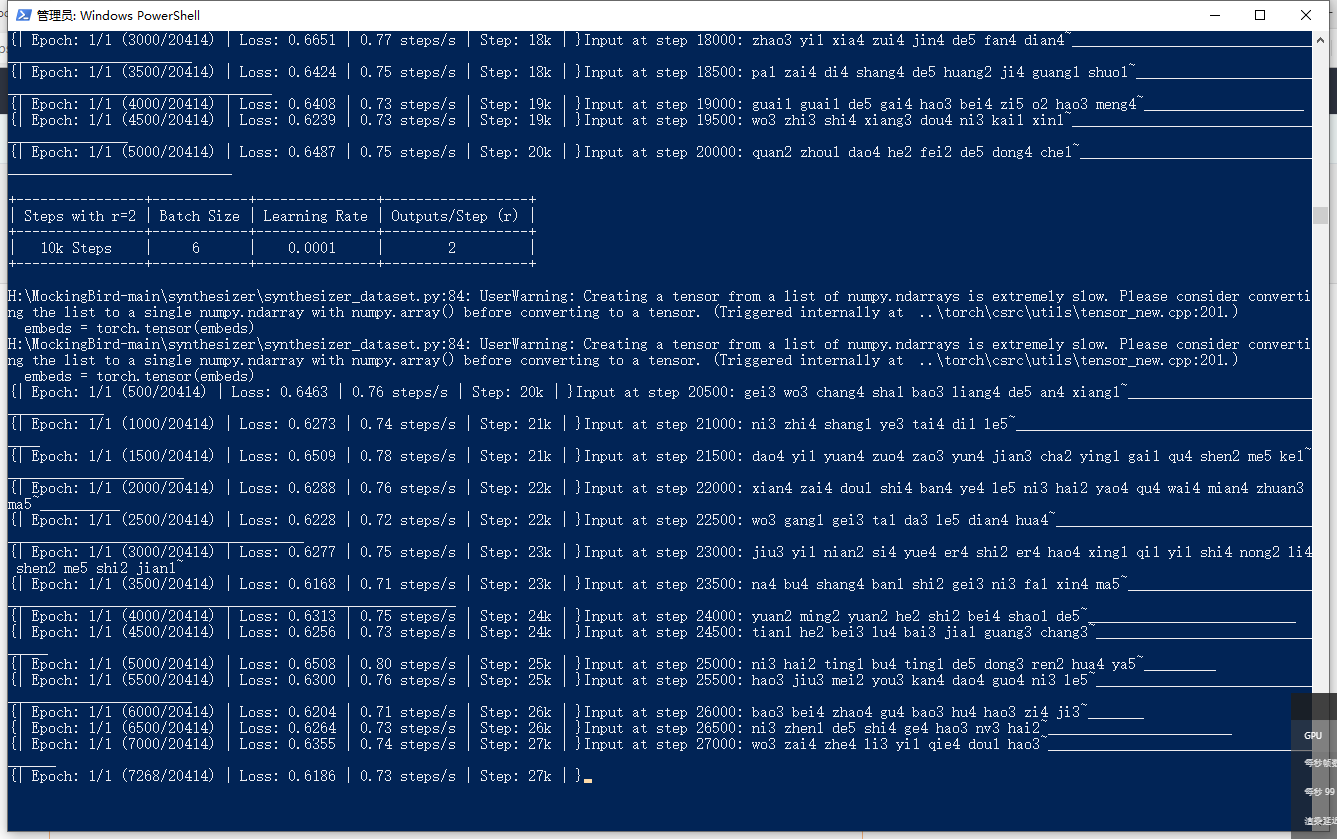

请问训练到25k的时候注意力线还是没有出来,并且文件多出了一个出来这个是正常的吗?

请问训练到25k的时候注意力线还是没有出来,并且文件多出了一个出来这个是正常的吗?

这样的情况是正确的还是我操作错了

cpu是i59400F,显卡是1505ti,配置GPU是的数值只能配置到6,GPU的占用率已经在80-100%跳动了

Tacotron Training tts_schedule = [(2, 1e-3, 10_000, 6), # Progressive training schedule (2, 5e-4, 15_000, 6), # (r, lr, step, batch_size) (2, 2e-4, 20_000, 6), # (r, lr, step, batch_size) (2, 1e-4, 30_000, 6), # (2, 5e-5, 40_000, 6), # (2, 1e-5, 60_000, 6), # (2, 5e-6, 160_000, 6), # r = reduction factor (# of mel frames (2, 3e-6, 320_000, 6), # synthesized for each decoder iteration) (2, 1e-6, 640_000, 6)], # lr = learning rate

还请大佬给指点指点,谢谢!

还有想问下有没有交流群可以拉下,学习学习

_25k ,_50k 等文件是你在步数达到该步后生成的模型文件(相当于游戏存档了啊哈哈)

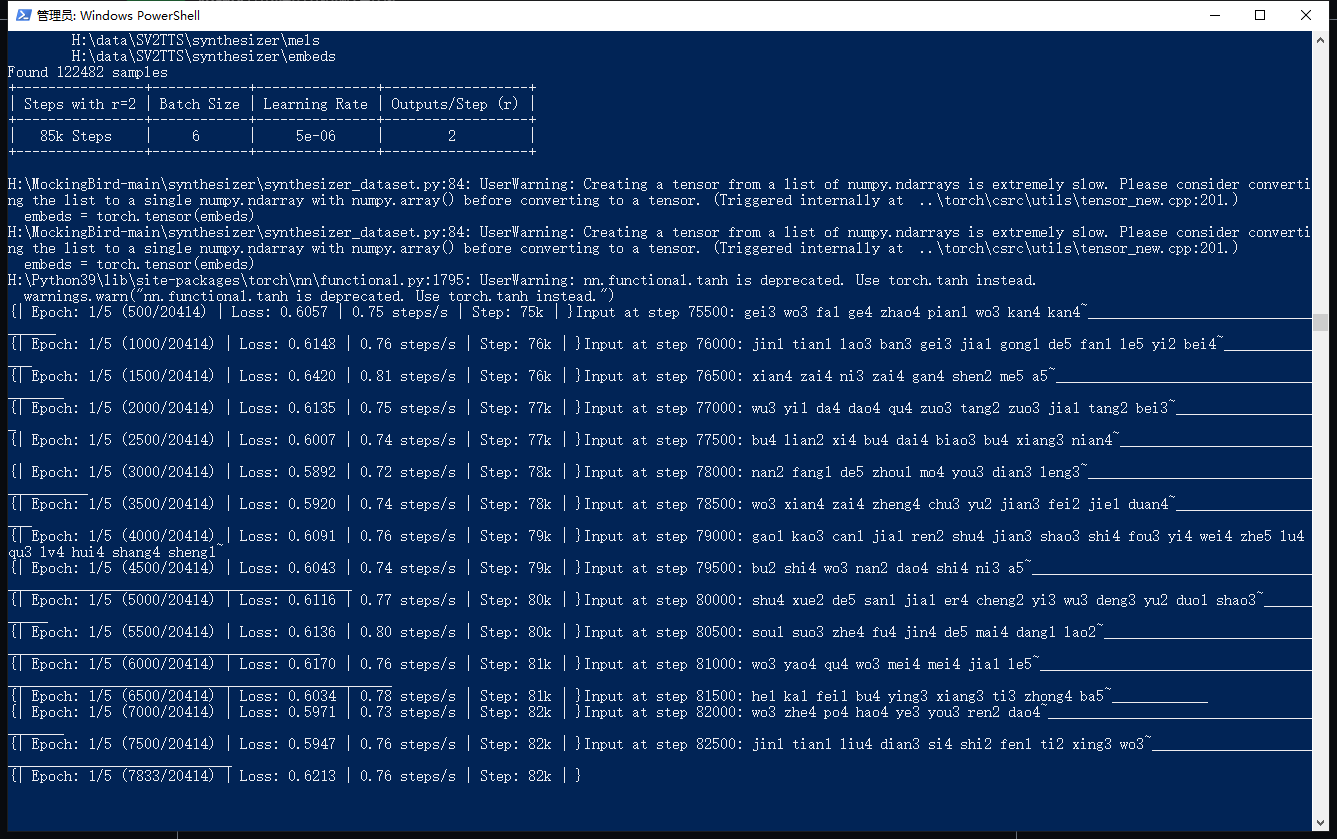

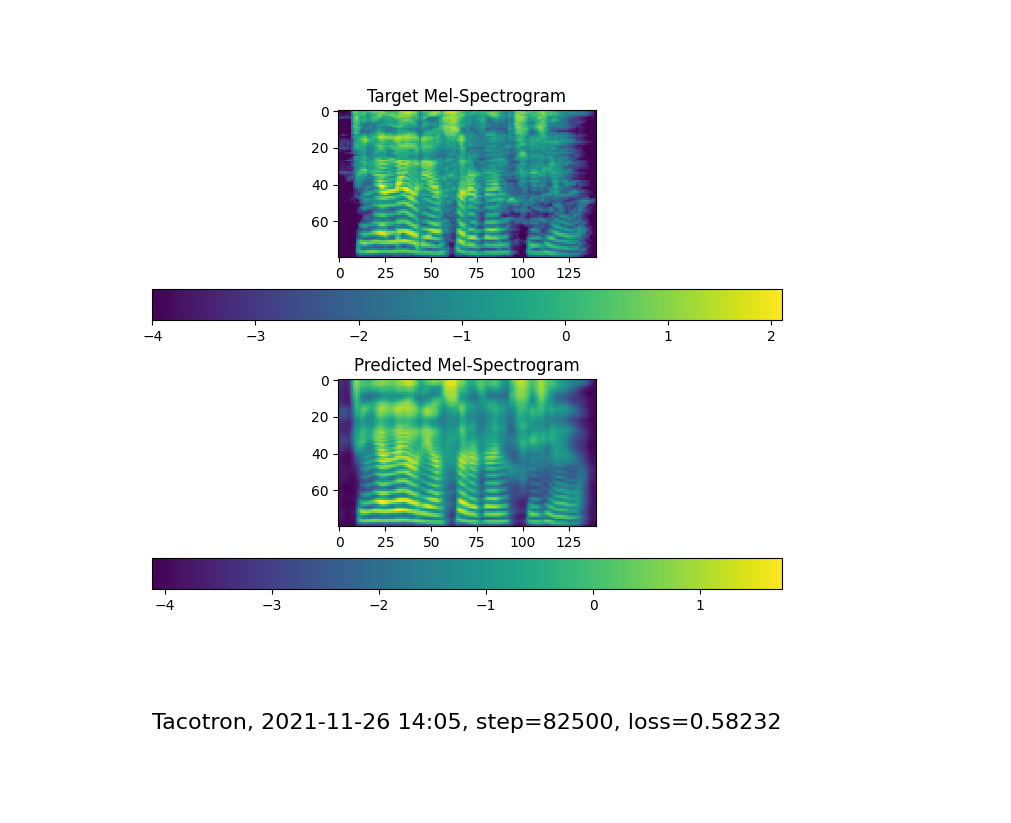

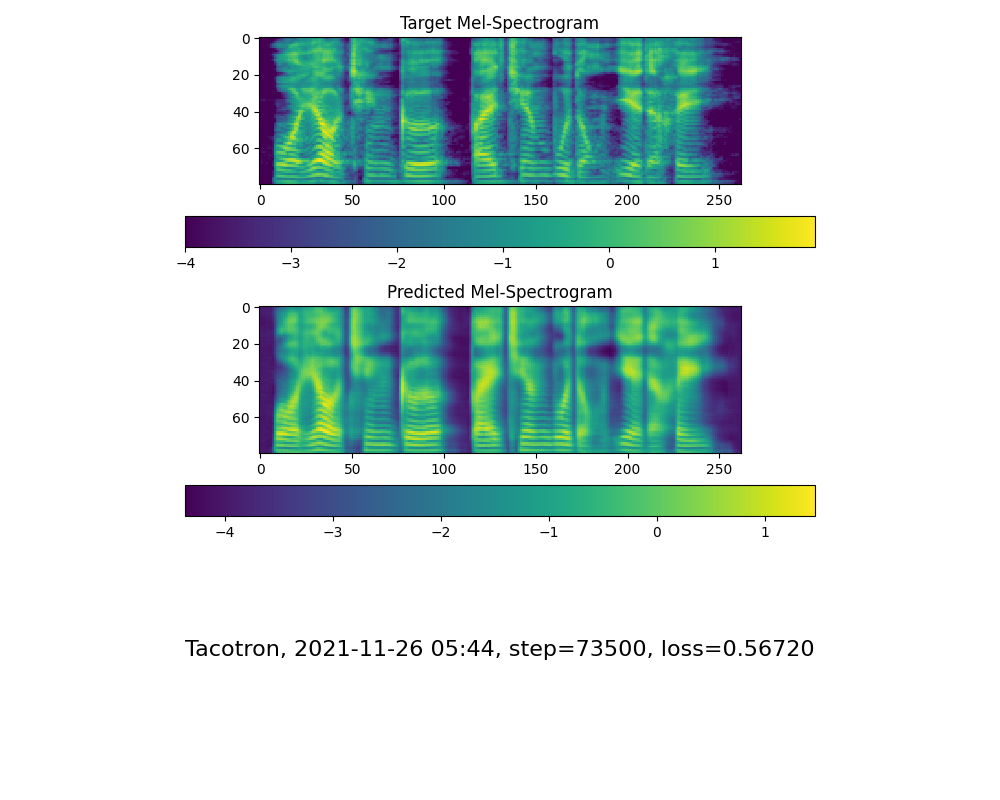

另外...我的注意力线是在步数达到72k之后才出现的...届时的loss 是 0.61, 还达不到标准 1505ti 是指1050ti的话,训练速度还要更慢一些✓ 请耐心等待

吐槽一句,我的环境跑了两个整天(48h)了都还是有明显的低频电流音...,Loss也是维持在0.6就没变过了...

@ #吐槽一句,我的环境跑了两个整天(48h)了都还是有明显的低频电流音...,Loss也是维持在0.6就没变过了...

是的,1050ti

跑得都快崩溃了哈哈,85k 还是没有注意力线

同1050TI 已经75k了,loss浮动在0.8-0.5之间,多数分布在0.6

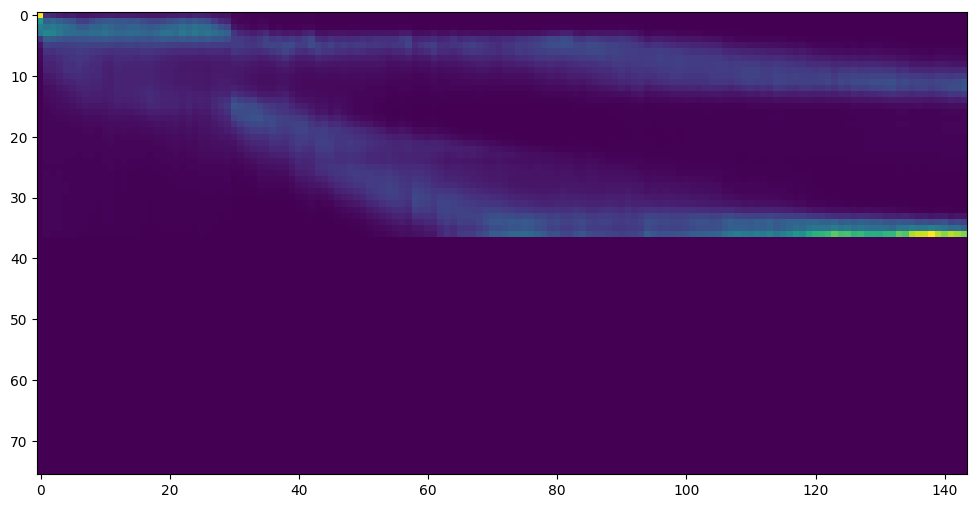

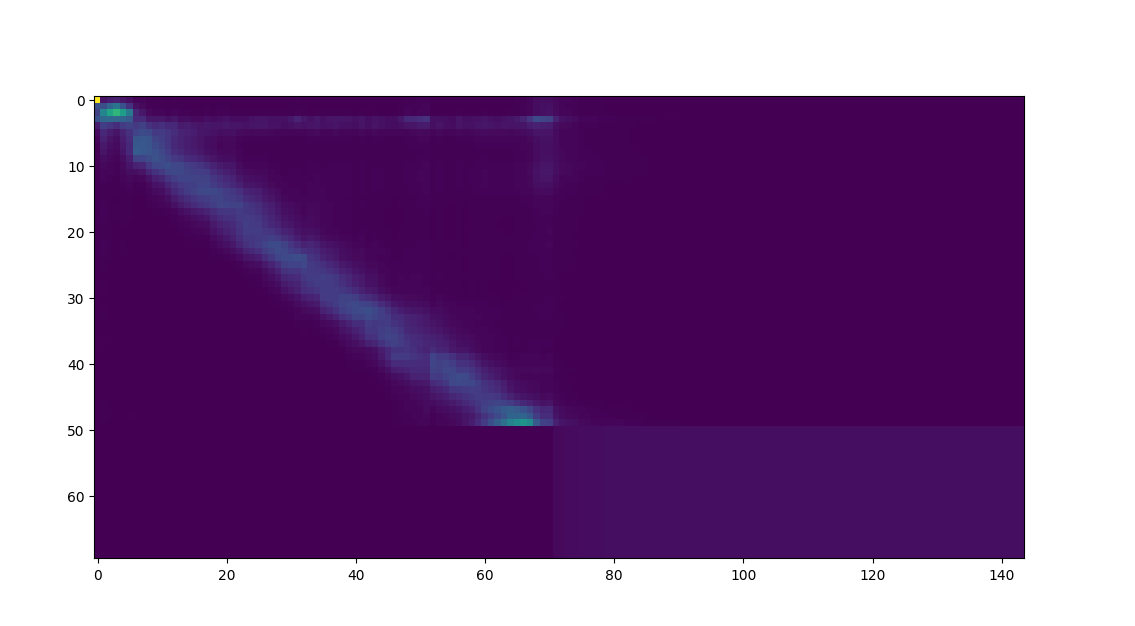

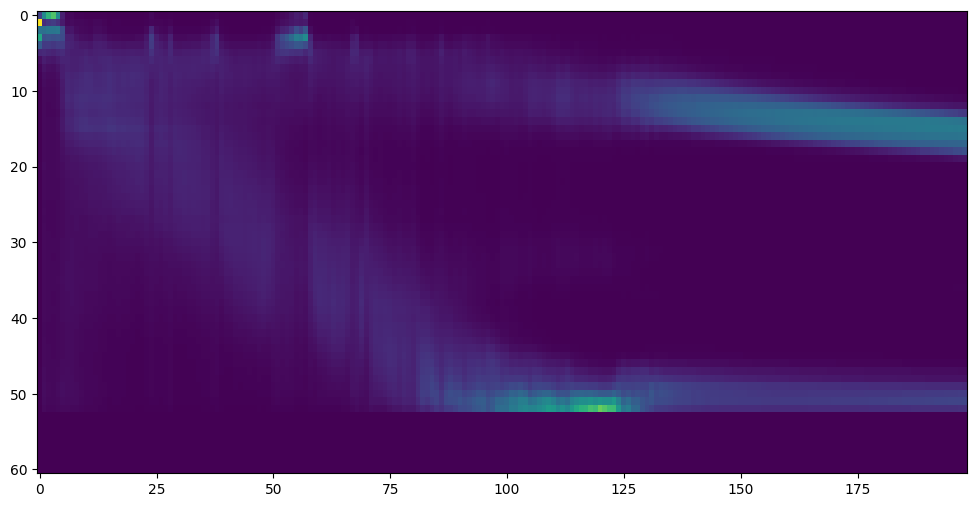

hmm。看这个attention图貌似问题比较大,考虑基于我分享的模型上跑?

在别人分享的模型基础之上继续训练,训练集要求和之前的一样吗。我的显存8g,batchsize设置多少不会报错,太小了就没必要折腾了

在别人分享的模型基础之上继续训练,训练集要求和之前的一样吗。我的显存8g,batchsize设置多少不会报错,太小了就没必要折腾了

训练集可以完全不一样,batchsize在20以内,你可以试探一下,只要不崩溃就可以调大

你的数据集用了多少条音源?,做下参考

我20k出现注意力线还以为是最慢的了。。

嗯。看这个attention图貌似问题比较大,考虑基于我分享的模型上跑?

想请教,您分享打的模型在哪里看到?我要咋操作在模型基础上继续跑? 要重新开始吗?

在别人分享的模型基础之上继续训练,训练集要求和之前的一样吗。我的显存8g,batchsize设置多少不会报错,太小了就没必要折腾了

训练集可以完全不一样,batchsize在20以内,你可以试探一下,只要不崩溃就可以调大

请问怎么调整batch_size,没有找到参数设置位置,默认好像是12?

可以下载别人做好的模型,名字改成和自己模型名字一样就行。显卡1050跑这个很吃力,可以在别人基础上跑。