WenJing

WenJing

OpenAI的cookbook里面说: For cl100k_base and p50k_base encodings, tiktoken is the only tokenizer available as of March 2023. Python: tiktoken(https://github.com/openai/tiktoken/blob/main/README.md)

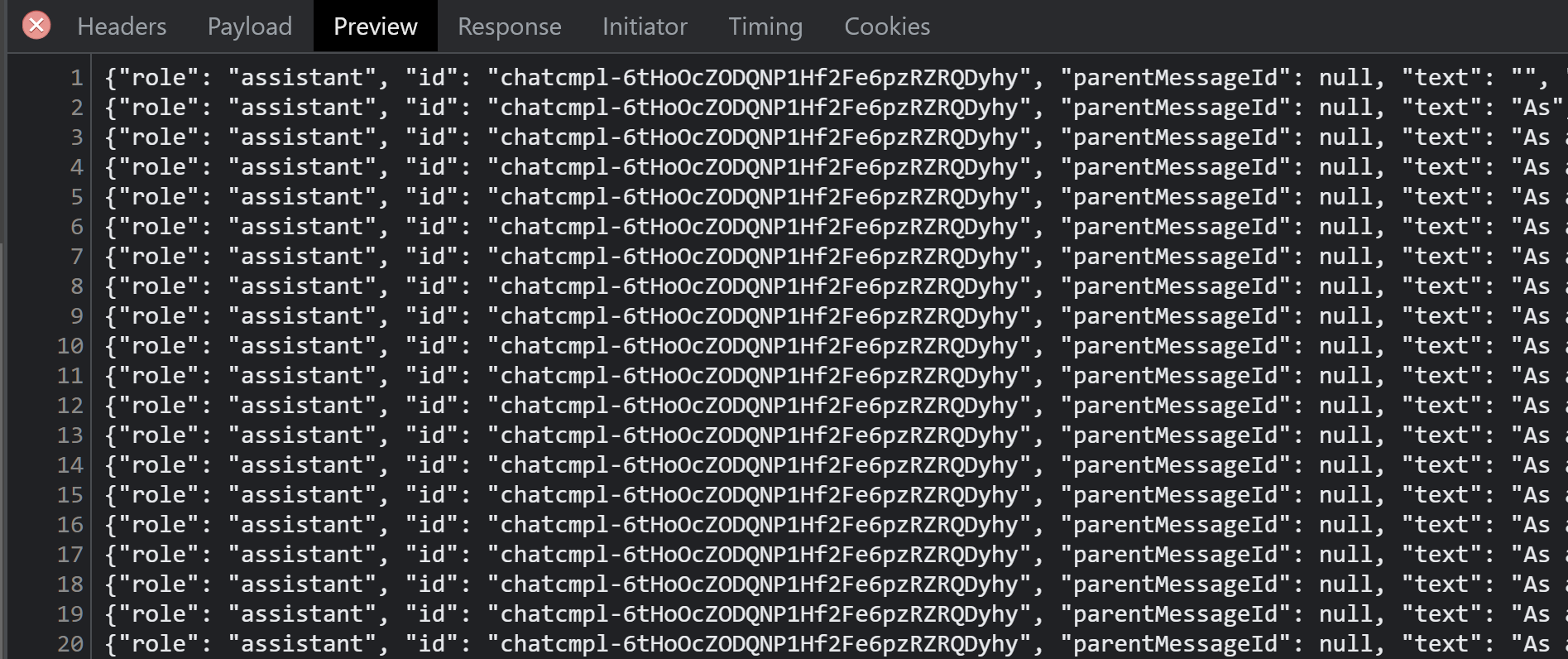

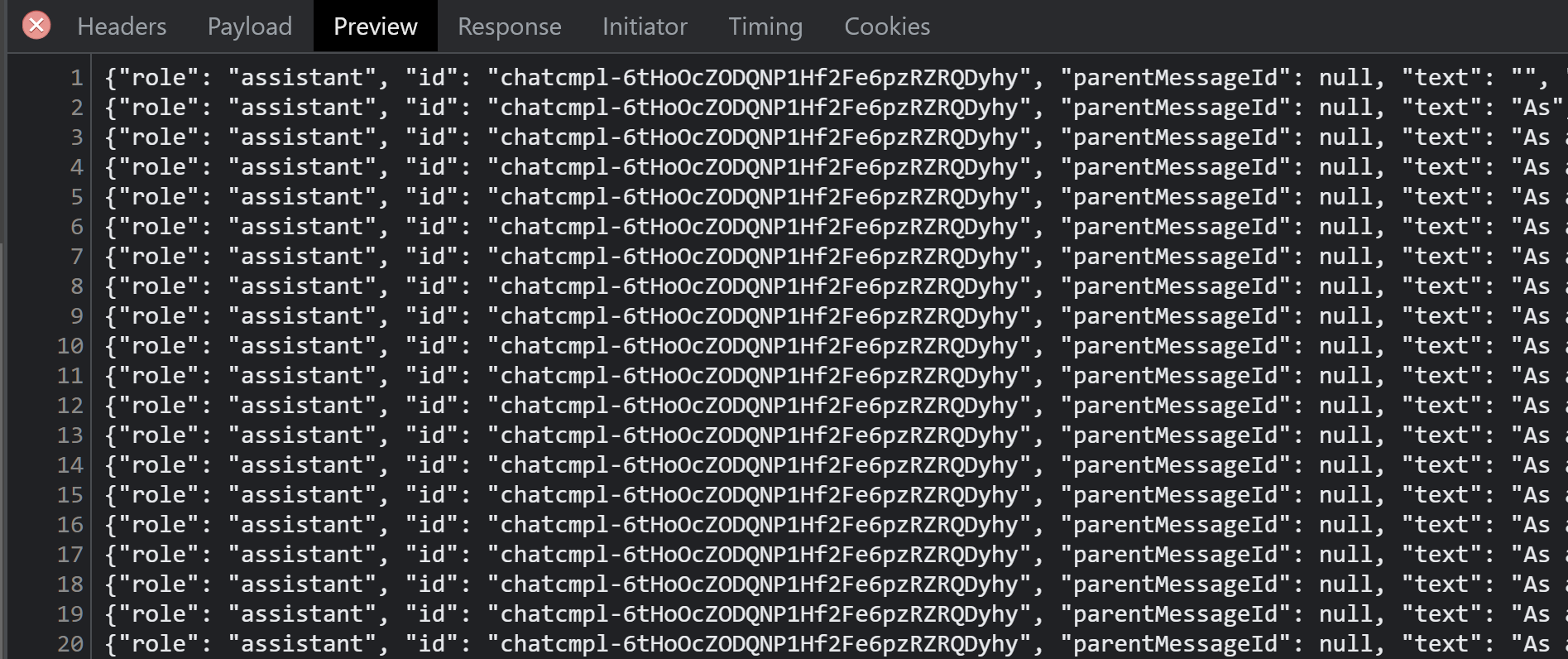

`/chat-process`这个接口的响应格式是`content-type: application/octet-stream`,不是json。响应参数也不是这些

> > `/chat-process`这个接口的响应格式是`content-type: application/octet-stream`,不是json。响应参数也不是这些  > > 你自己也写了后端吗?求Java响应式返回的代码,包括WebClient请求OpenAI接口的。直接将OpenAI接口的数据返回给前端是这样吗? [我写了python后端](https://github.com/WenJing95/chatgpt-web),你可以参考下 OpenAI官方这里有java的sdk:[community-libraries](https://platform.openai.com/docs/libraries/community-libraries) 这个项目的响应数据,好像是和官方接口有区别,我是按前端需求的格式自己修改的数据

你要找的是不是:[我的fork](https://github.com/WenJing95/chatgpt-web)