RandLA-Net

RandLA-Net copied to clipboard

RandLA-Net copied to clipboard

关于 Semantic3D训练问题

胡博士,您好!

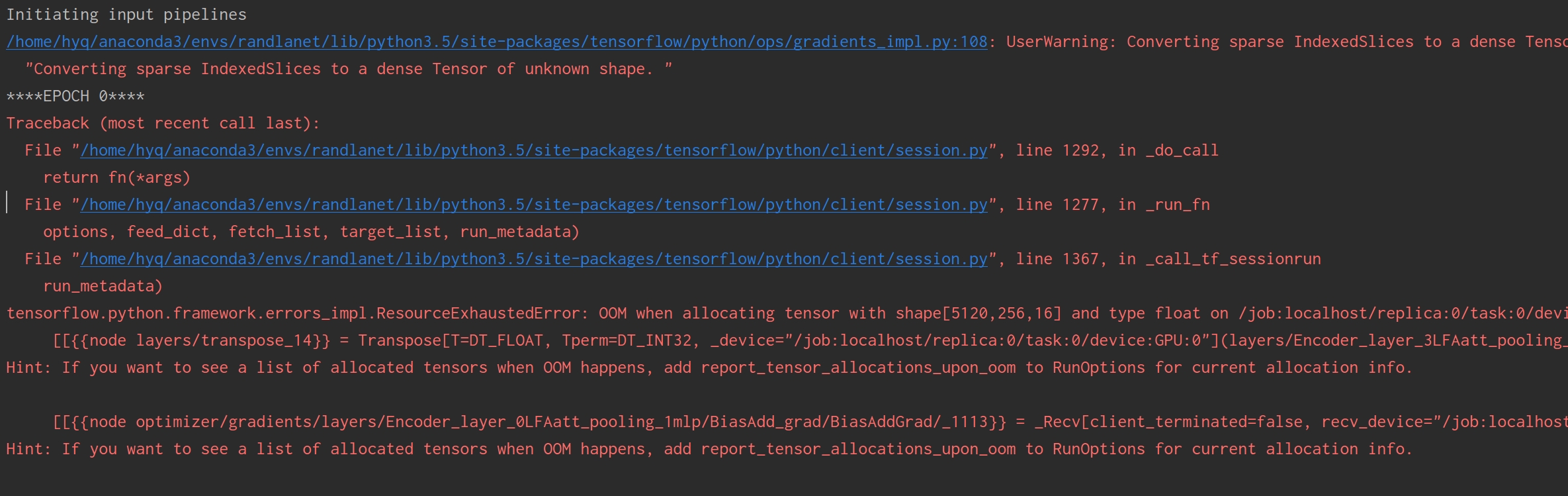

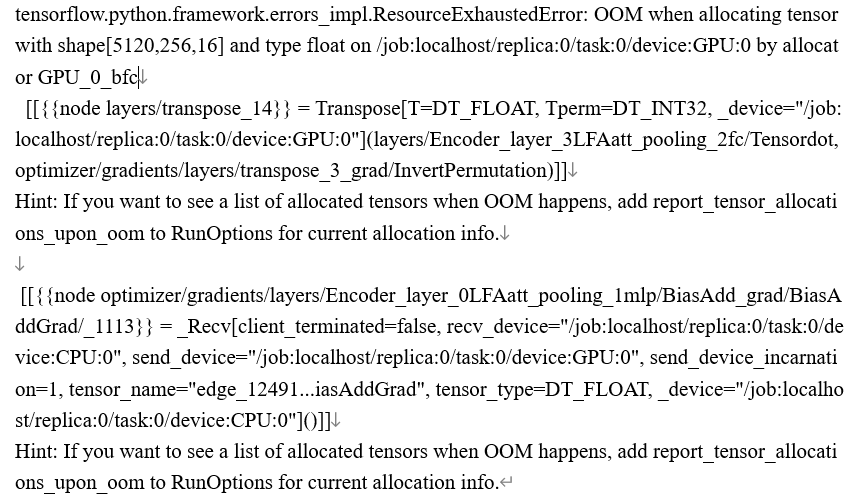

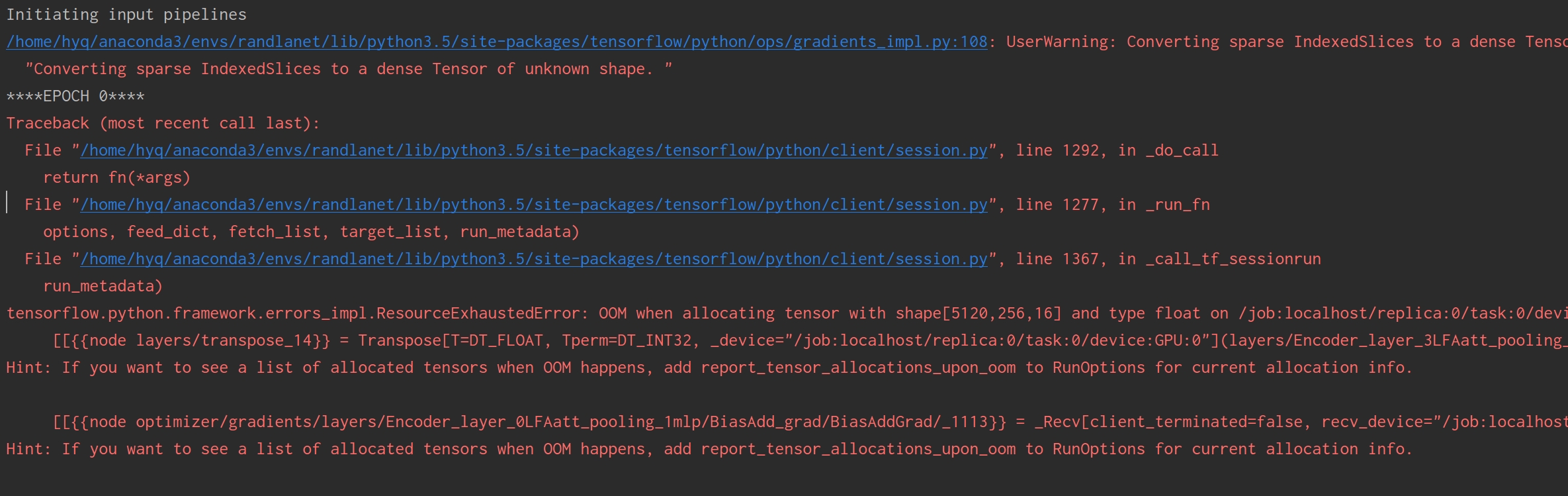

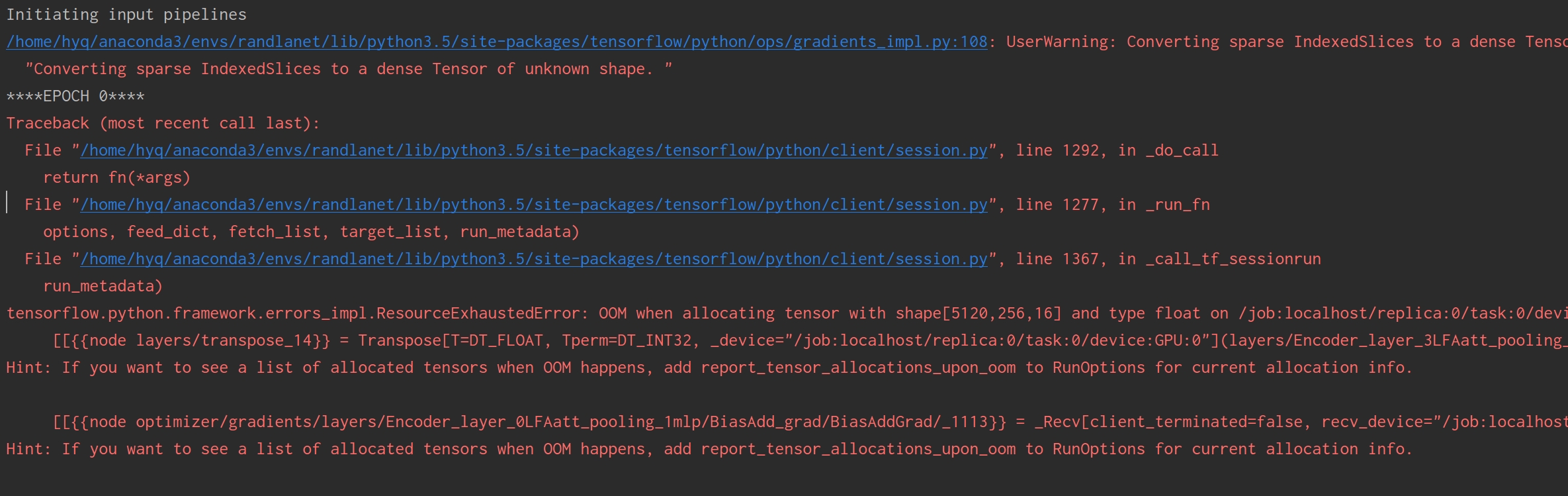

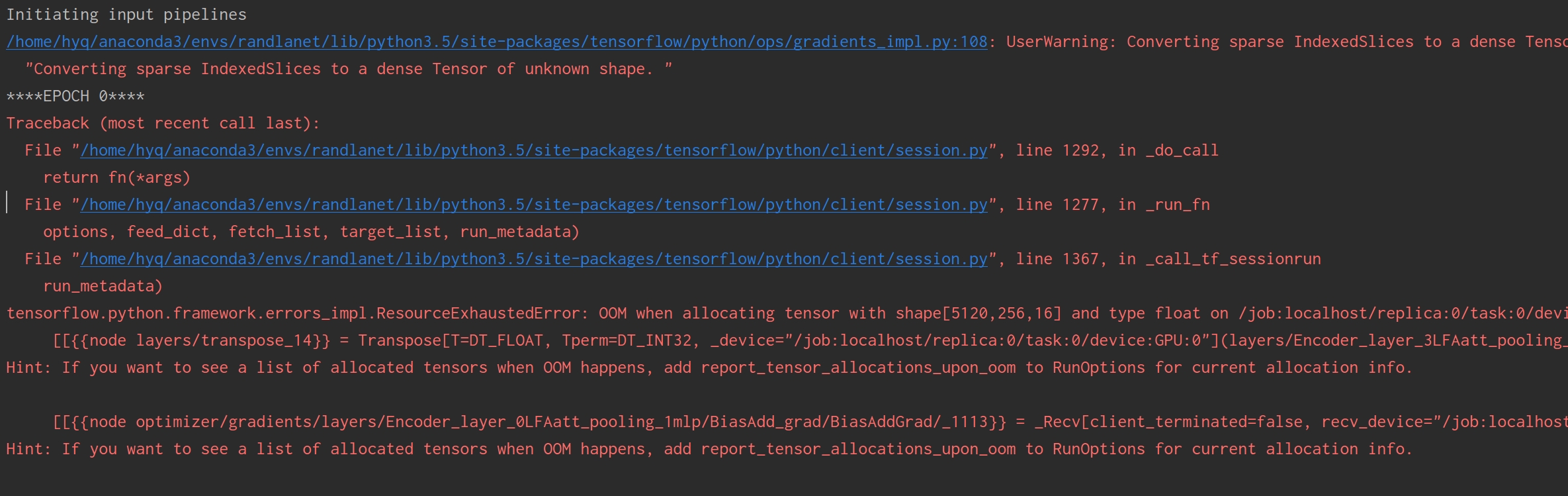

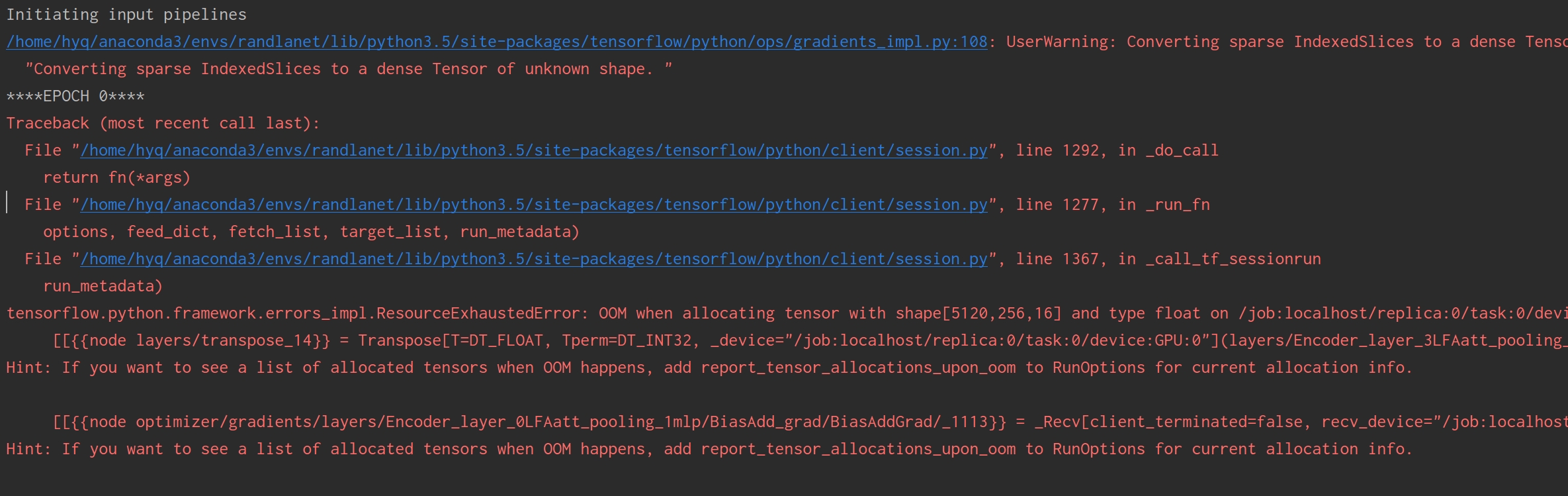

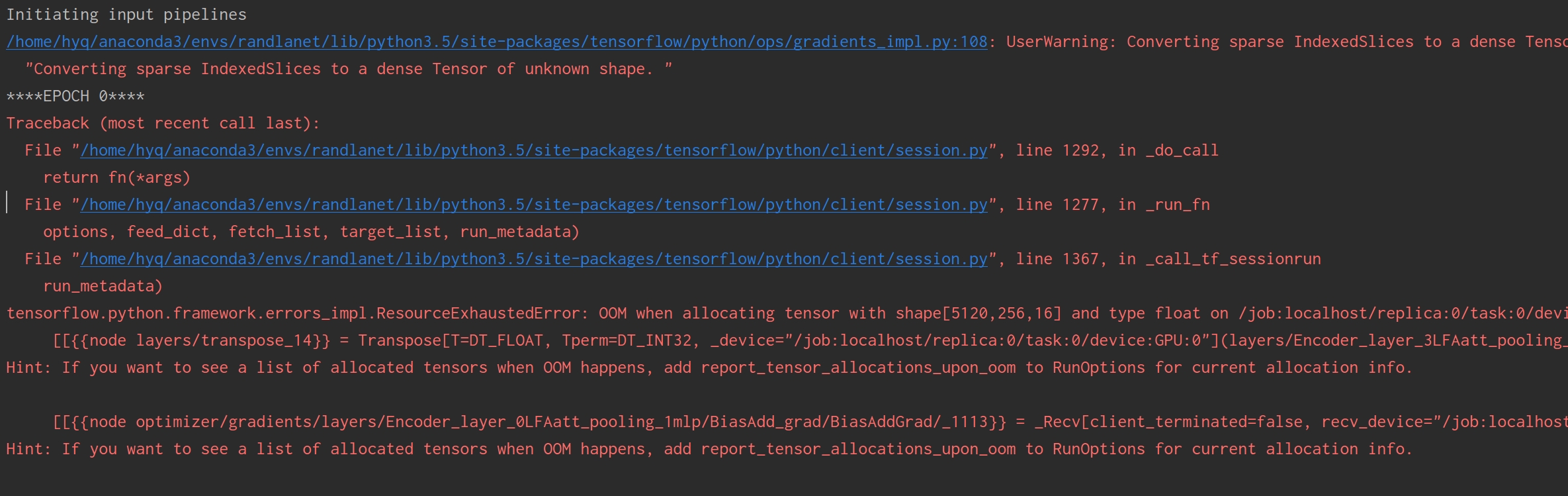

我的电脑是64G显卡也是2080ti显存是11G,在训练Semantic3D的时候batch_size为4可以运行best_mIoU只能67左右,batch_size为5的时候出现了显存错误。能给点建议吗?

胡博士,您好! 我的电脑是64G显卡也是2080ti显存是11G,在训练Semantic3D的时候batch_size为4可以运行best_mIoU只能67左右,batch_size为5的时候出现了显存错误。能给点建议吗?

您好,想问下您后来的训练结果有没有提升?我显存也是11G, batch_size也只能是4,训练出来结果比您这边好一点,72.584%,但是batch_size设置成2的时候100个epochs大概mIoU在67%左右。

胡博士,您好! 我的电脑是64G显卡也是2080ti显存是11G,在训练Semantic3D的时候batch_size为4可以运行best_mIoU只能67左右,batch_size为5的时候出现了显存错误。能给点建议吗?

您好,想问下您后来的训练结果有没有提升?我显存也是11G, batch_size也只能是4,训练出来结果比您这边好一点,72.584%,但是batch_size设置成2的时候100个epochs大概mIoU在67%左右。

您好,我后来提升了多训几次调多epochs也有到71%。我提出疑问是因为当时没看清,论文中77.4%胡博士用的是Semantic3D的reduced-8测试的,所以有差异吧

胡博士,您好! 我的电脑是64G显卡也是2080ti显存是11G,在训练Semantic3D的时候batch_size为4可以运行best_mIoU只能67左右,batch_size为5的时候出现了显存错误。能给点建议吗?

您好,想问下您后来的训练结果有没有提升?我显存也是11G, batch_size也只能是4,训练出来结果比您这边好一点,72.584%,但是batch_size设置成2的时候100个epochs大概mIoU在67%左右。

您好,我后来提升了多训几次调多epochs也有到71%。我提出疑问是因为当时没看清,论文中77.4%胡博士用的是Semantic3D的reduced-8测试的,所以有差异吧

我刚刚也注意到了这个问题: (reduced-8), 请问您这边有没有做相关的实验,是否达到论文中所说的效果?您之前大概是多少个epochs接近了71%,超100个epochs很多吗?当您训练100个epochs的话是不是普遍还是67-68左右?

@tangpan360 @brueyq 請教下代碼裏面是如何獲取每個 batch 的點雲的,因爲只看到了 self.sess.run(dataset.train_init_op),這個應該是初始化了一個 epoch 的數據,但是並沒有看到針對 self.flat_inputs = iter.get_next() 這個的 sess.run(self.flat_inputs) 來獲取每一個batch的數據,所以請教下代碼裏面是如何獲取每一個batch的數據的,謝謝

胡博士,您好! 我的电脑是64G显卡也是2080ti显存是11G,在训练Semantic3D的时候batch_size为4可以运行best_mIoU只能67左右,batch_size为5的时候出现了显存错误。能给点建议吗?

您好,想问下您后来的训练结果有没有提升?我显存也是11G, batch_size也只能是4,训练出来结果比您这边好一点,72.584%,但是batch_size设置成2的时候100个epochs大概mIoU在67%左右。

您好,我后来提升了多训几次调多epochs也有到71%。我提出疑问是因为当时没看清,论文中77.4%胡博士用的是Semantic3D的reduced-8测试的,所以有差异吧

我刚刚也注意到了这个问题: (reduced-8), 请问您这边有没有做相关的实验,是否达到论文中所说的效果?您之前大概是多少个epochs接近了71%,超100个epochs很多吗?当您训练100个epochs的话是不是普遍还是67-68左右?

您好,我想问一下您们是怎么进行训练的,我这边训练每一个epoch都大概需要3.4个小时,请问怎样才是使用gpu训练呢

胡博士,您好! 我的电脑是64G显卡也是2080ti显存是11G,在训练Semantic3D的时候batch_size为4可以运行best_mIoU只能67左右,batch_size为5的时候出现了显存错误。能给点建议吗?

您好,想问下您后来的训练结果有没有提升?我显存也是11G, batch_size也只能是4,训练出来结果比您这边好一点,72.584%,但是batch_size设置成2的时候100个epochs大概mIoU在67%左右。

您好,我后来提升了多训几次调多epochs也有到71%。我提出疑问是因为当时没看清,论文中77.4%胡博士用的是Semantic3D的reduced-8测试的,所以有差异吧

我刚刚也注意到了这个问题: (reduced-8), 请问您这边有没有做相关的实验,是否达到论文中所说的效果?您之前大概是多少个epochs接近了71%,超100个epochs很多吗?当您训练100个epochs的话是不是普遍还是67-68左右?

@tangpan360 您好,您有跑过S3DIS数据集的结果吗?我跑过几次mIoU都只有58左右,离论文里report的70还差得远,是有什么训练技巧吗?