Serving

Serving copied to clipboard

Serving copied to clipboard

A flexible, high-performance carrier for machine learning models(『飞桨』服务化部署框架)

请问 build_dag_each_worker 设置为 True 且 worker_num > 1 时 , grpc-gateway 会自动做负载均衡吗? 如果不会 ,那么 build_dag_each_worker 为 True 的意义是什么? 如果会,那么该怎样才能让多个进程同时工作?

```bash $ cmake -DPYTHON_INCLUDE_DIR=$PYTHON_INCLUDE_DIR/ \ -DPYTHON_LIBRARIES=$PYTHON_LIBRARIES \ -DPYTHON_EXECUTABLE=$PYTHON_EXECUTABLE \ -DOpenCV_DIR=../opencv4 \ -DWITH_OPENCV=ON \ -DSERVER=ON .. ... CMake Error: Cannot open file for write: /root/PaddleOCR/deploy/pdserving/Serving/build_server/core/Makefile.tmp CMake Error: : System Error: Not...

使用serving docker开发镜像版本:registry.baidubce.com/paddlepaddle/serving:0.8.0-devel 编译安装过程中报错如下图:  报错显示git clone代码失败,网络链接超时 但是我单独使用git clone https://github.com/pybind/pybind11.git 是能正常拉取代码的且网络是和github链接正常。 请问这种问题我能否在make之前单独把依赖程序git clone 下来吗?但是这些clone下的代码要放在那个目录下才能在make时识别到

在尝试本地服务化部署的时候,日志抛出数组越界异常  代码: ``` midped_batch = [] for idx in range(len(feed_batch)): predict_res, error_code, error_info = func_timeout.func_timeout( self._timeout, self.process, args=([feed_batch[idx]], typical_logid)) #midped_batch[idx].append(predict_res) #上述写法错误,因改为如下 midped_batch.append(predict_res) ```

Paddleserving OCR例子中,web_service.py 实现了检测模型和识别模型的串联,我想实现首先输入数据通过检测模型,然后将检测结果根据判断条件分成两部分,分别送入不同的两个识别模型,即检测模型串联两个并联的识别模型,根据判断条件分支。想请教各位专家paddleserving是否支持,如何实现?

问题描述: GO 1.18.X --- 会在serving-gateway这里build不过。 描述: Go版本差异造成。1.17的go, go mod vendor会自动做类似tidy的工作,不报错。1.18就不会,直接报错。 python/util.py这里, 应该有点问题。 应该是先go mod tidy,然后再go mod vendor才对的。 其实感觉好像不需要vendor啊。 vendor是在本地mod目录下,拷贝依赖进到vendor目录。 不需要魔改vendor的话,没必要这么做。

1、如题:C++Serving 是否支持 TRT 模型的直接部署? 2、目前 cuda10.2应该是可以支持 TensorRT 8(对 BERT 类模型加速效果好),C++Serving 好像并没有提供对于的镜像,是否支持重新编译对应的C++ Serving(还是因为有问题,所以未提供)?

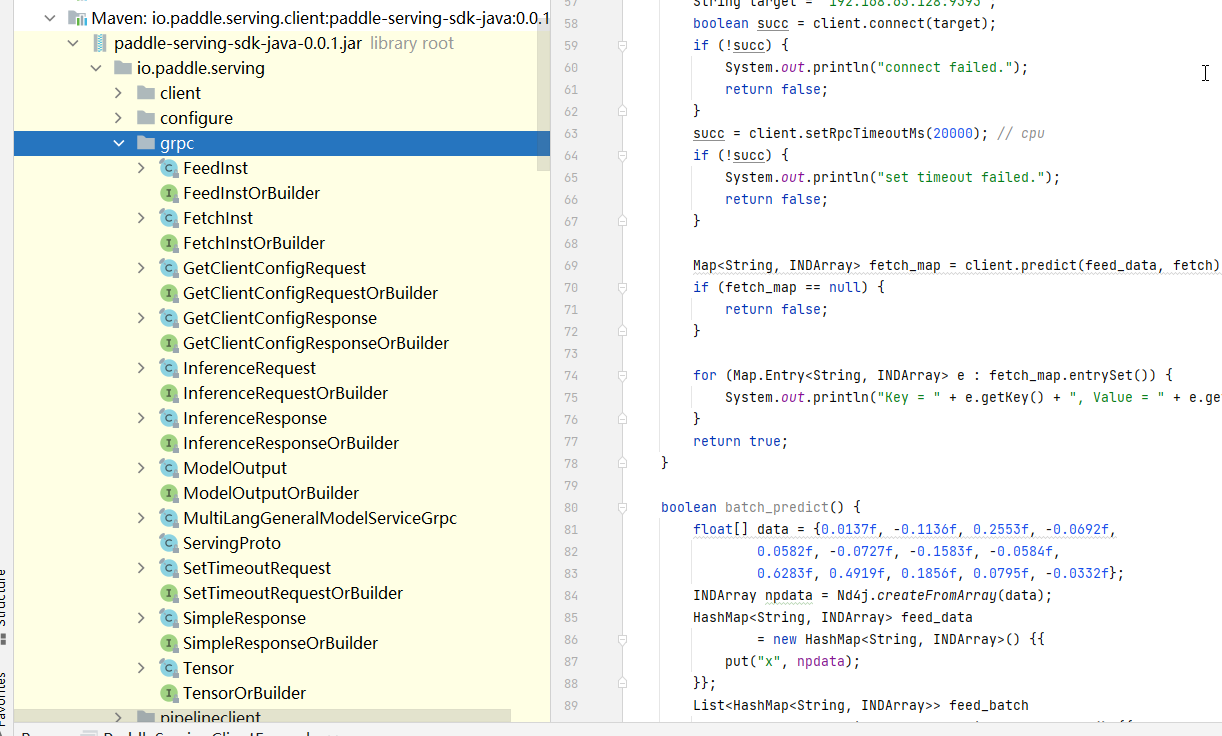

我根据java文档https://github.com/PaddlePaddle/Serving/tree/develop/java 放在win中idea打开,并且maven导入了  但是在执行的时候报错,错误提示是

1、在serving中部署了OCR,最后只能得到识别的文字,怎样才能获得对于文字的位置, 2、检测模型检测多个结果,识别模型预测出来的结果的顺序和检测模型给出的顺序是不是一样,(我试的结果是有时候一样,有时候不一样)