Linly

Linly copied to clipboard

Linly copied to clipboard

腾讯格式的权重转换成HF格式的转换脚本在哪里?

同样的问题

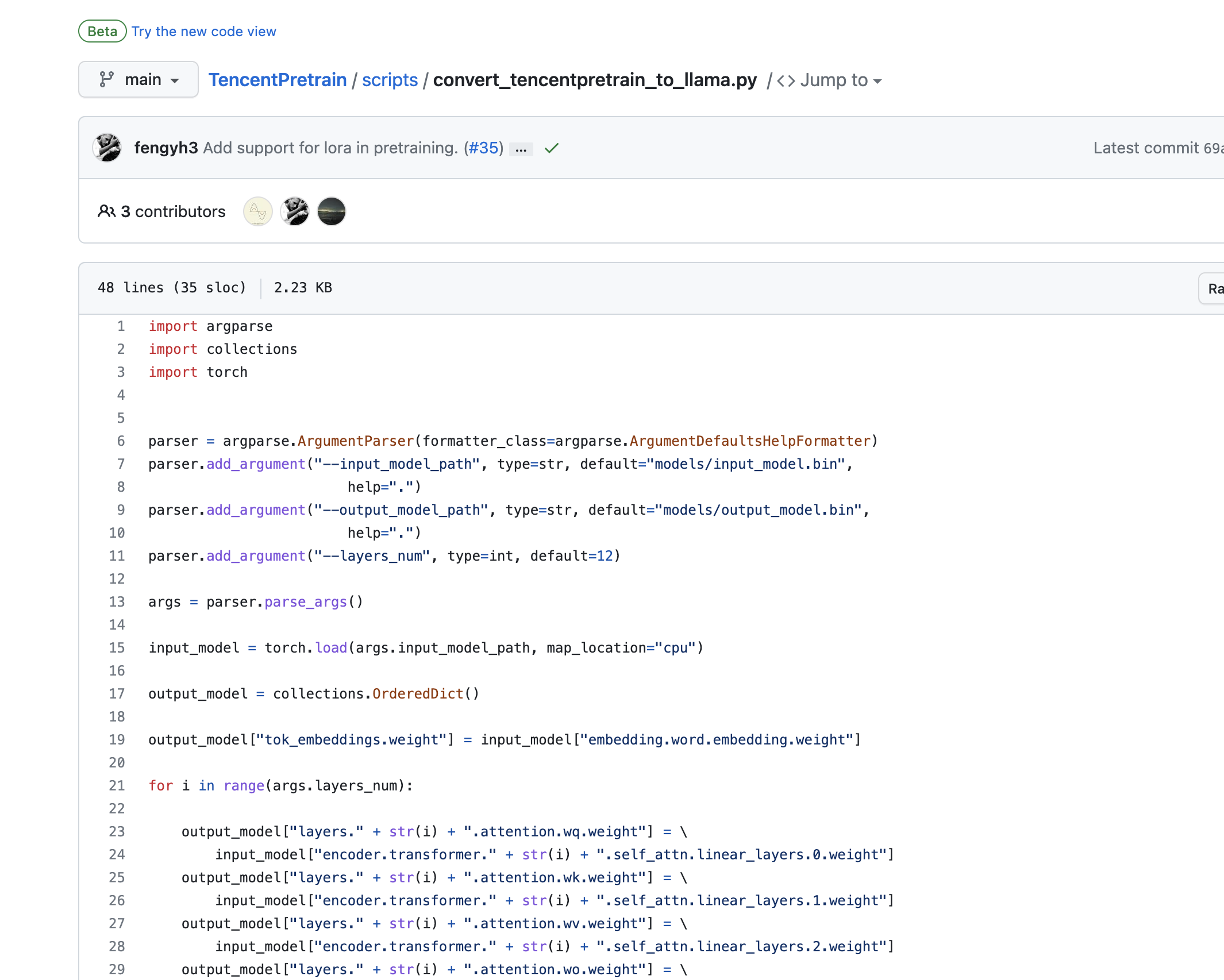

TencentPretain scripts

- Tencent -> Llama

convert_tencentpretrain_to_llama.py

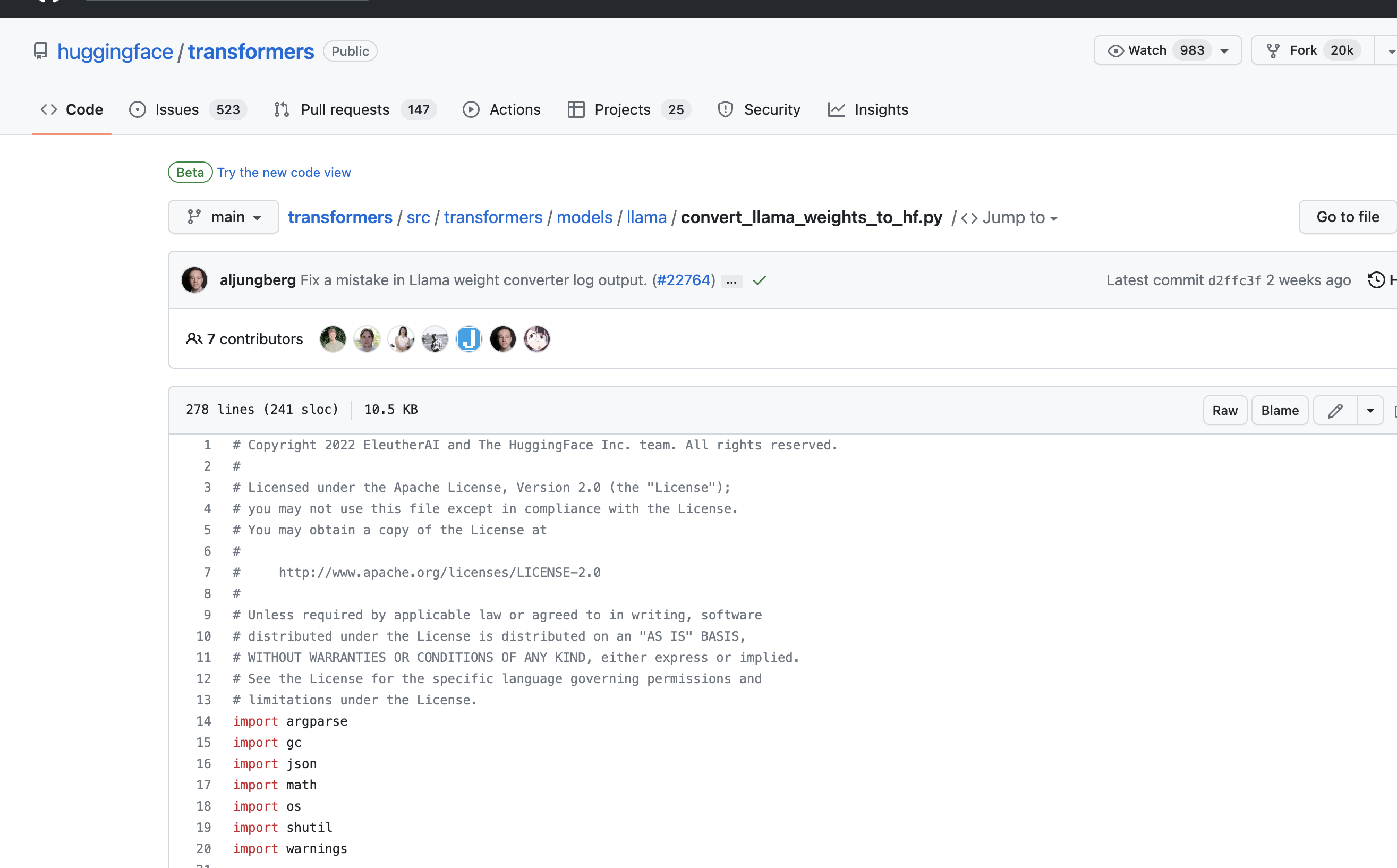

- Llama -> Huggingface

convert_llama_weights_to_hf.py 我理解的路径应该是这样

转llama的时候,layer_num参数怎么设置,是用默认(12层)么?

直接转到hf的脚本还在测试中,近期会上传

发件人: 张夜白 @.> 发送时间: Tuesday, April 25, 2023 2:35:01 PM 收件人: ydli-ai/Chinese-ChatLLaMA @.> 抄送: Subscribed @.***> 主题: Re: [ydli-ai/Chinese-ChatLLaMA] 腾讯格式的权重转换成HF格式的转换脚本在哪里? (Issue #44)

- Tencent -> Llama

convert_tencentpretrain_to_llama.py

- Llama -> Huggingface

convert_llama_weights_to_hf.py 我理解的路径应该是这样

― Reply to this email directly, view it on GitHubhttps://github.com/ydli-ai/Chinese-ChatLLaMA/issues/44#issuecomment-1521225552, or unsubscribehttps://github.com/notifications/unsubscribe-auth/AE3SPV3DIZTSYUVCLG4LR33XC5WBLANCNFSM6AAAAAAXJQW52E. You are receiving this because you are subscribed to this thread.Message ID: @.***>

期待作者给出 ChatLLaMA-zh-7B 到 ChatLLaMA-zh-7B-hf的转换脚本,在线等

期待作者给出 ChatLLaMA-zh-7B 到 ChatLLaMA-zh-7B-hf的转换脚本,在线等

其实能直接转llama我很合用,因为我是用llama.cpp

转llama的时候,layer_num参数怎么设置,是用默认(12层)么?

自己回答自己的问题。7B的模型是32层,13B的模型是40层。 如有错误请大家指正。

转成huggingface后效果咋样,会有损失吗?

@riverzhou 请问llama.cpp你是如何运行的?

@riverzhou 请问llama.cpp你是如何运行的?

先用 TencentPretrain 项目里的转换脚本把作者的腾讯格式的数据转成原始的 llama 的格式(layer_num参数:7B的模型是32层,13B的模型是40层。), 再用 llama.cpp 项目里 转换脚本转成 ggml 的格式, 最后,可选做量化,Q4 Q5 Q8都可以。