Xiaoyu Zhang

Xiaoyu Zhang

> 修正了一下代码, 目前报错是 > > ``` > loaded library: /lib/libibverbs.so.1 > Distributed env is not set up, configure it by default (single node, single gpu). > Traceback (most recent call...

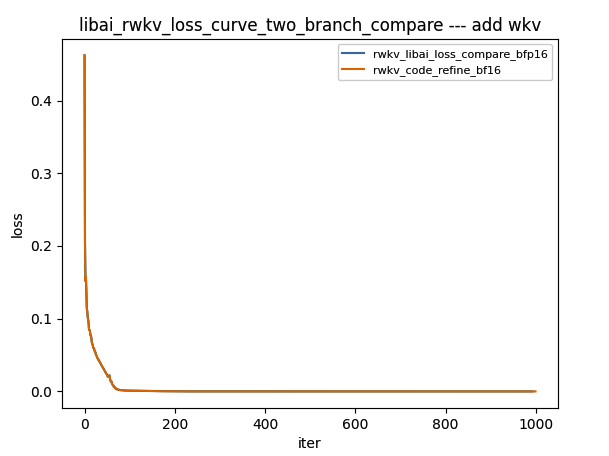

和 rwkv4 分支的loss做对比,结果如下:  正确性和rwkv4分支一致。

> 能不能再functor上判断一下并做个cast 可以

debug了一下,问题的原因在于flow.equal和torch.equal在两个输入都是Tensor时返回值不一样,flow.equal返回和原始Tensor一样大小的tensor,而pytorch返回一个scalar(只有全部元素相等才为True,否则为False),并且equal算子的广播逻辑也是错误的,后续需要重构下equal算子解决这个问题。

@daquexian 这个行为要改一下么?

> 暂时不支持nn.pairwisedistance() 及 Variable,然后我就用torch.nn.pairwisedistance() 代替了,Variable也使用了torch的,请问这对训练结果或者训练速度有影响吗? 回复到这里吧。https://github.com/Oneflow-Inc/OneTeam/issues/1207#issuecomment-1073432125 Variable这个是过时的用法就不用写了,用Tensor代替吧

> 我本地试了一下是正常的,python3 -m oneflow --doctor 可以查看一下你的oneflow版本,另外可以直接用torch跑一下确认一下gpu是否正常工作。

> > python3 -m oneflow --doctor > > 您好,我的oneflow版本是0.8.0,我的torch gpu可以正常工作。但是运行还是没有出结果 意思是oneflow运行的时候没有出结果,pytorch正常出结果吗?

原始需求: ```python class WKV(torch.autograd.Function): @staticmethod def forward(ctx, B, T, C, w, u, k, v): ctx.B = B ctx.T = T ctx.C = C assert T

@hjchen2 @guo-ran 我们那个bfp16感觉不能和fp16一起用一个名单维护,我这里发现的一个问题是如果layernorm用fp16计算loss可以对齐,如果用bfp16计算的话loss就会突变,变成这样:  所以fp16和bfp16应该分2个List维护吧,不是适合用fp16做训练的模型也一定适合用bfp16,我目前的做法是先注释掉了gray list的layernorm来保证bf16模式的正确性。