tensorRT_Pro

tensorRT_Pro copied to clipboard

tensorRT_Pro copied to clipboard

C++ library based on tensorrt integration

佬,去年使用yolox推导没有问题,然后现在突然报错:Tensor allocator query failed. 而且我要是从加载onnx开始一套走下来,不会报错,但是单独加载引擎文件也会报上面的错:Tensor allocator query failed. 去年是用的老版的yolox训练然后来推导,今年使用较新版的yolox(归一化有区别  )

Hello, if I want to work by vs2015, how can I do? Thank you!

使用如下命令生成带nms的yolov7_tiny版本onnx: python export.py --weights yolov7-tiny.pt --grid --end2end --simplify --topk-all 100 --iou-thres 0.65 --conf-thres 0.35 --img-size 640 640 --max-wh 640 然后使用simple_yolo中的compile转换onnx成tensorrt, 转换的时候: output shape is 100x7  转换完加载模型的时候,反序列化时, output is 1x7...

YoloV7's trt engine is created input image size(640,640). i want to resize input image's width and height.(for example,(608,608)) what i have to do?

请问:如何将tensorrt的生成结果(如yolov5),用在deepstream中?是否需要自己书写相关插件?

GTX3070,加载YOLOV5M模型,占用了3G左右的内存显存,有办法改善吗

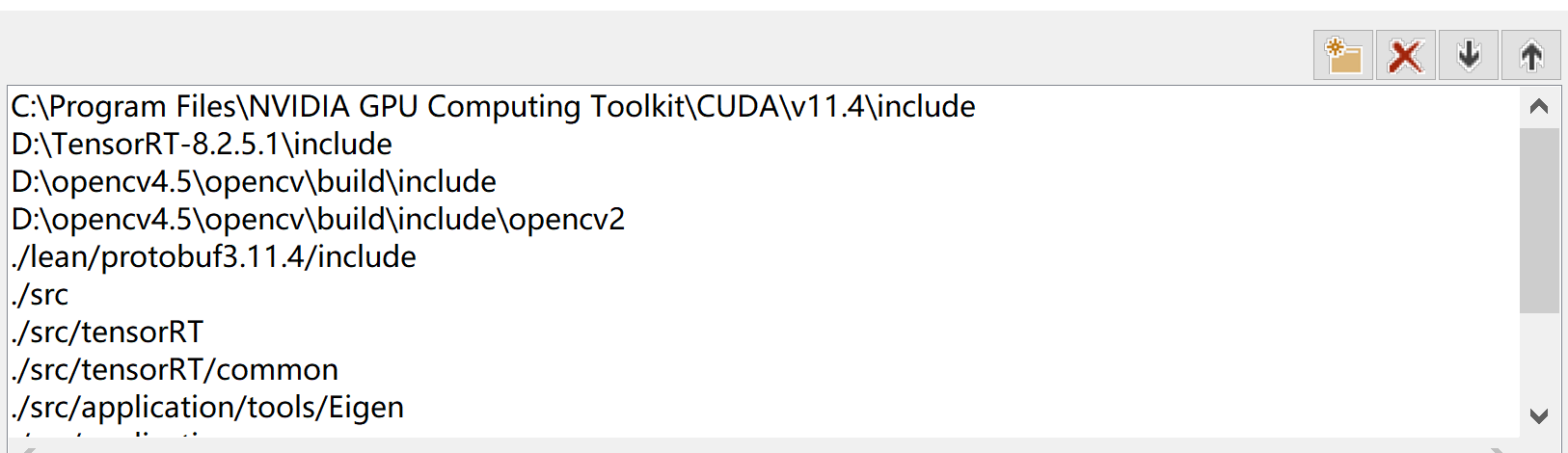

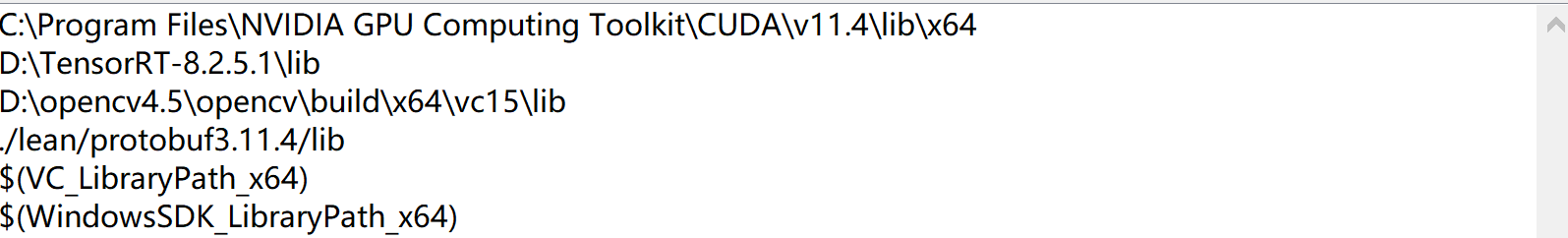

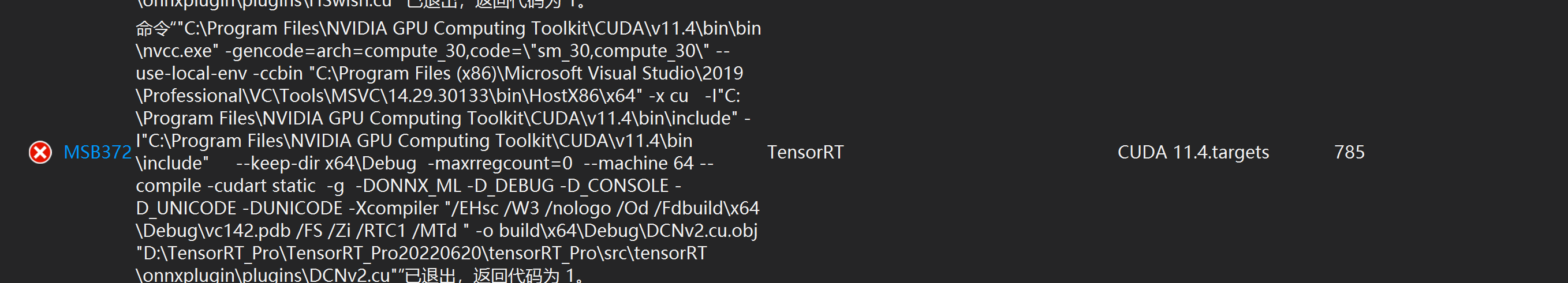

环境: VS2019+cuda11.4+trt8.2+opencv4.5 包含目录:  库目录:  报错信息:...请问这是哪里除了问题了吗,

除了修改TensorRT.vcxproj中的配置还需要修改其他的吗 严重性 代码 说明 项目 文件 行 禁止显示状态 错误 LNK2019 无法解析的外部符号 "class std::shared_ptr __cdecl AlphaPoseOld::create_infer(class std::basic_string const &,int)" (?create_infer@AlphaPoseOld@@YA?AV?$shared_ptr@VInfer@AlphaPoseOld@@@std@@AEBV?$basic_string@DU?$char_traits@D@std@@V?$allocator@D@2@@3@H@Z),该符号在函数 "int __cdecl app_fall_recognize(void)" (?app_fall_recognize@@YAHXZ) 中被引用 TensorRT C:\Users\77288\tensorRT_Pro-main\tensorRT_Pro-main\tensorRT_Pro-main\app_fall_recognize.obj 1 严重性 代码 说明...