UER-py

UER-py copied to clipboard

UER-py copied to clipboard

如何pretrain bert_wiki_word_model.bin?

你好, 十分欣賞閣下的model及對中文NLP的深入理解。

當中尤其是, word-based bert 這個model...因為坊間所有bert乃character-based ,使其無法做到對詞搜詞的操作。

可否一問, 我是住香港的nlper. 我使用的是繁體字, 如何可finetune bert_wiki_word_model.bin?

我想過先把近三十萬句繁體字句子先進行分詞, 然後使用閣下build_vocab.py 再把繁體字vocab 加入google的vocab.txt之中。

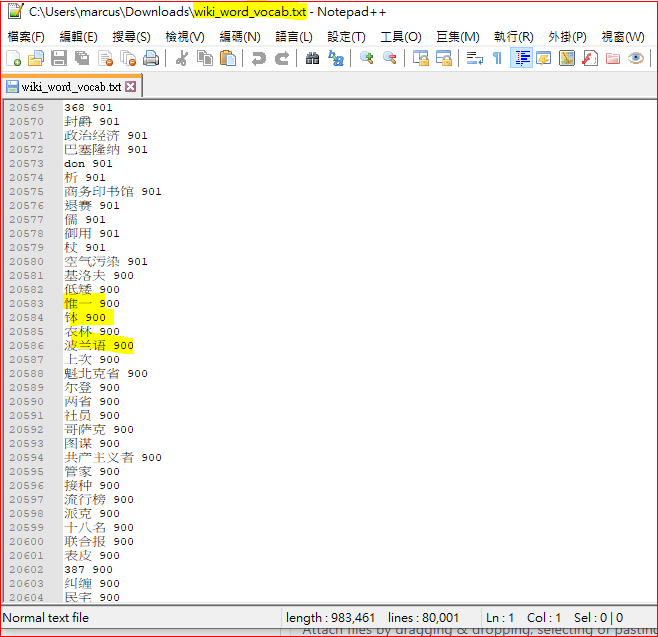

但在閣下的word-based bert vocab.txt 之內, 詞語旁是有weighting的, 這使我大為不解?

可否請教, 如我使用繁體字, 可如何pretrain bert_wiki_word_model.bin?

然後使用topn_words_dep.py ?

謝謝

您好 首先建立自己的词典 然后下载bert_wiki_word_model.bin对应的词典 然后使用scripts文件夹下面的dynamic_vocab_adapter.py,改变bert_wiki_word_model.bin的word embedding和softmax之前的层,使其能够对应到您自己的词典 然后就可以使用您自己的词典,语料,在转换后的模型上增量预训练了 词典的第一列是单词,第二列是语料中的频数 这块的readme我会进一步完善,更多细节问题可以邮件沟通