binary-husky

binary-husky

duplication of https://github.com/binary-husky/chatgpt_academic/issues/554

websockets模块的问题,查不到相关的解决方法。尝试用anaconda配置一个干净的python环境试试?

@Akihisa-Watanabe Thank you for your support! v3.1 would be fine, we have implemented ChatGLM in this branch

请验证这个PR是否有效 https://github.com/binary-husky/gpt_academic/pull/1594

> > 请验证这个 PR 是否有效 > > #1594 > > 根据 [OpenAI Models](https://platform.openai.com/docs/models/gpt-3-5-turbo),max token应该是16,385 tokens吧。 是的,我再修改一下

PR修改到https://github.com/binary-husky/gpt_academic/pull/1598 把max token 修改了

你好,这个pdf可能经过一些保密措施 - 用火狐浏览器打开该pdf(正常显示) - 复制题目粘贴到记事本中(乱码):  这种pdf是读取不了的

GPT-4-32k似乎没开放吧?

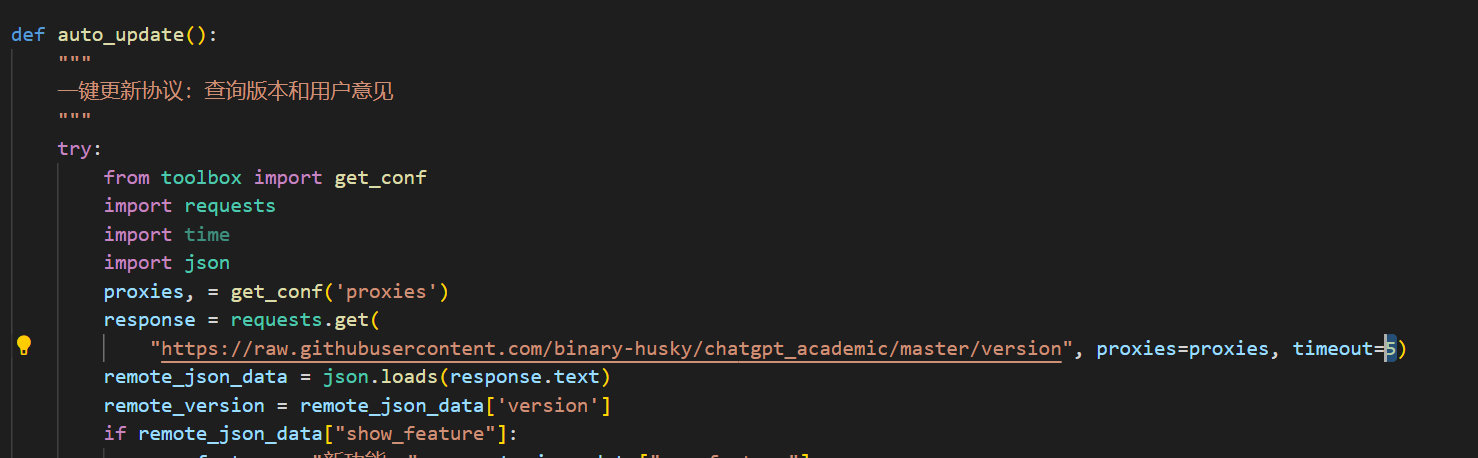

- 自动更新在main.py运行时自动触发。如果不触发,直接去github下载新版解压覆盖即可 - 如果很想用自动更新,请尝试在check_proxy.py中把timeout加大

> 如何去解压覆盖原文件,是指把config文件换成原来的吗? 谢谢 @BOBW-Y @aizensuk - 如果之前配置用了`config_private.py`,直接无脑覆盖就行 - 如果没有,先把`config.py`重命名为`config_private.py`,然后覆盖