DataSphereStudio

DataSphereStudio copied to clipboard

DataSphereStudio copied to clipboard

DataSphereStudio is a one stop data application development& management portal, covering scenarios including data exchange, desensitization/cleansing, analysis/mining, quality measurement, visualizati...

From the perspective of DSS architecture, it not only spans data application tools in different fields, but also interfaces with the Hadoop base platform at the bottom. Its installation and...

Scriptis supports shell script creation

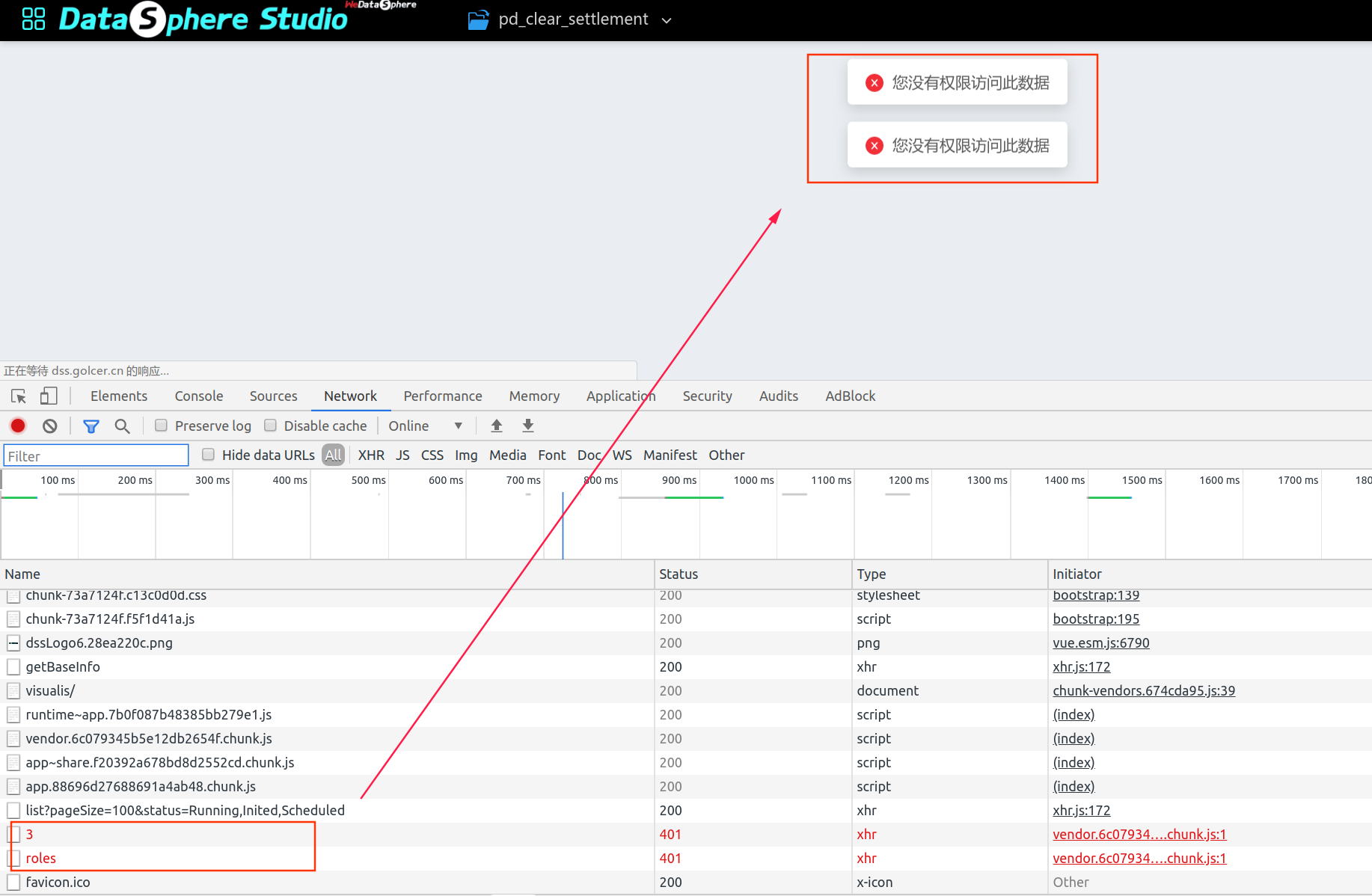

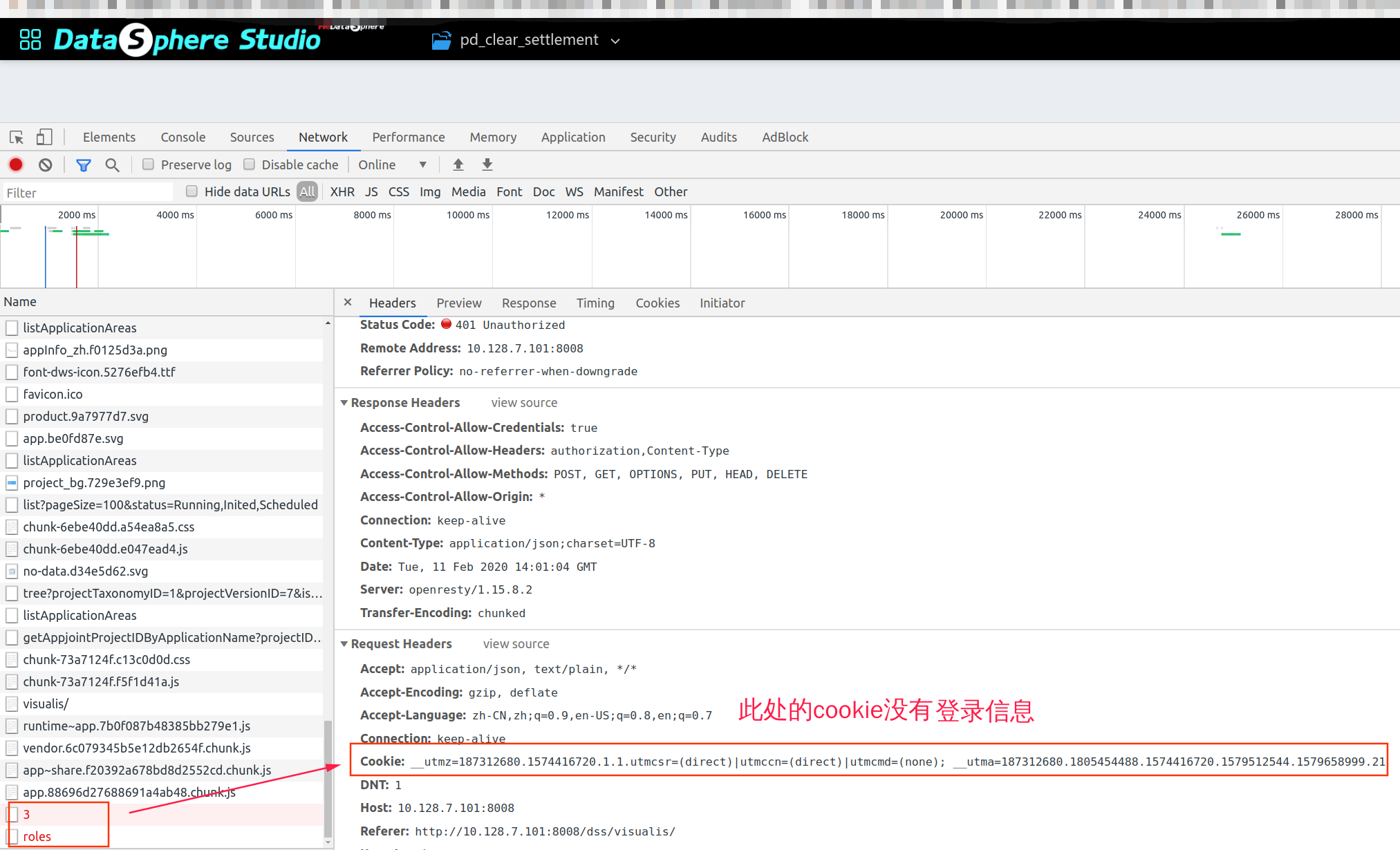

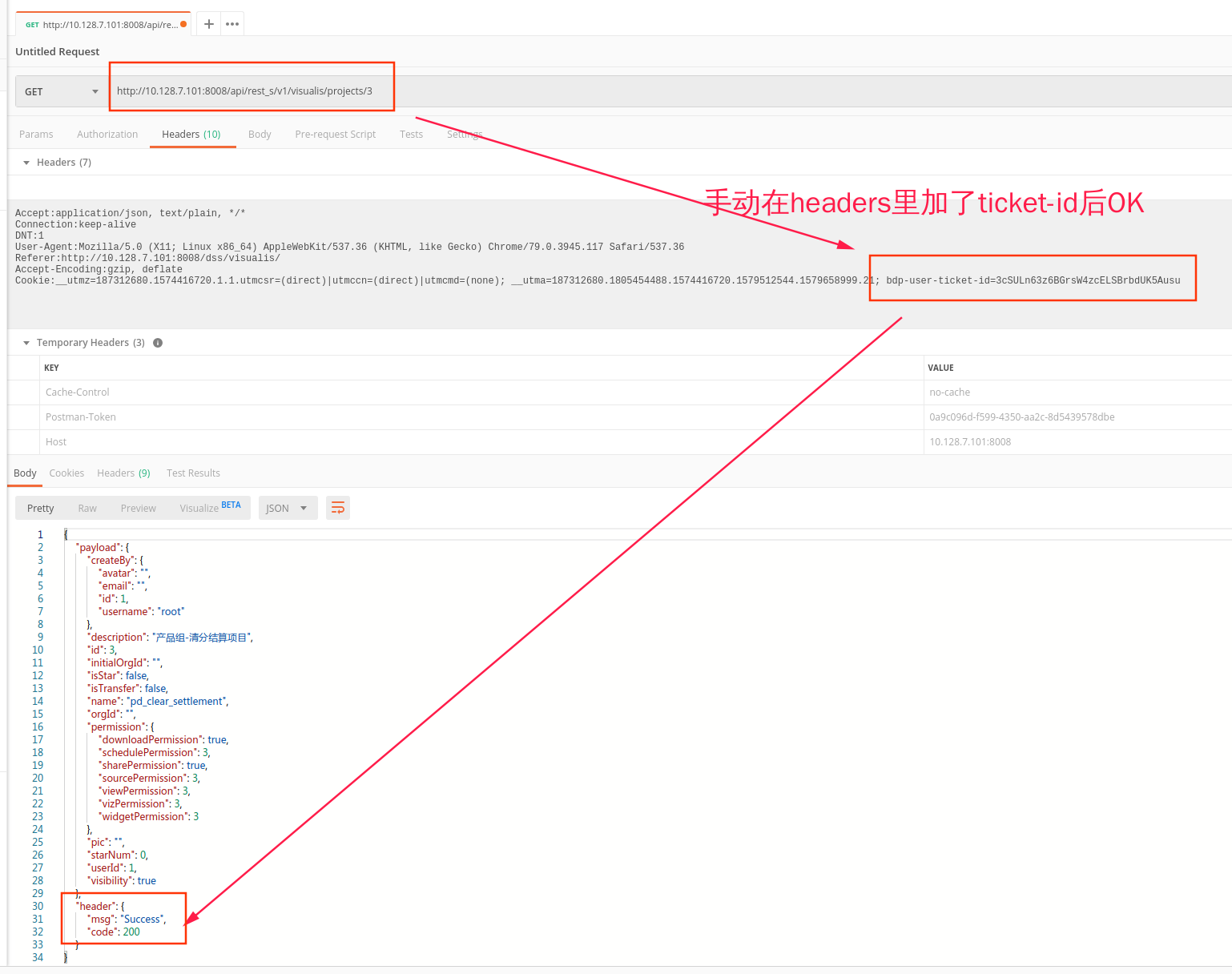

问题描述: - visualis页面无法打开  - 此时的cookie信息  - **使用Postman测试发现,在header中手动添加bdp-user-ticket-id参数后,返回值正常**  版本: dss0.6.0与dss0.7.0均有此问题,请问如何解决?

第一次执行包含两个不同jdbc节点的工作流还可以成功。编辑之后(可以增加一个新节点),第二次,执行工作流,则执行失败。失败的情况,如下图:  其中,jdbc01和jdbc03的url是同一个ip下的不同库。如下图: jdbc01:  jdbc03:  同时,单独执行jdbc02,得到了成功的结果:  而单独执行jdbc03,得到失败的结果:  此时,删掉jdbc03的节点后,又可以正常执行:  查看日志:jdbc03失败的原因,是因为jdbc03虽然配置的url库为prestoConf,但是最终执行jdbc时,所用的却是test01库(即jdbc01所用的库) 日志如下:  日志中可以看到,执行以前加载的jdbc是prestoConf,但是执行时的报错,却用的是test01。可能是因为com.webank.wedatasphere.linkis.entrance.execute.EntranceExecutorManagerImpl中的findUsefulExecutor在加载缓存时,加载错误。 似乎这个问题在相同ip下的不同库就会出现。 控制台配置图也没有进行默认配置,控制台配置图:  麻烦帮忙排查下该问题,谢谢。

linkis控制台->设置->数据开发spark->spark资源设置 该配置在实际使用中并未生效,页面修改保存后,数据库中并未修改

引擎查询完数据之后,并不会退出,需要手动退出

按照要求安装了精简版(昨天在百度网盘下载的dss_linkis.tar.gz安装包)。其中安装环境可能不满足要求的有一项:jdk版本是build 1.8.0_91-b14。都按照缺省参数安装,只修改了db.sh 的mysql参数(手动测试可连接) 安装完毕后,在Eureka(20303端口)界面中只看到了7个服务: CLOUD-PUBLICSERVICE | n/a (1) | (1) | UP (1) - xxxx:cloud-publicservice:9102 -- | -- | -- | -- DATAWORKCLOUD | n/a (1) | (1) | UP...

在工作流编辑界面中,拖出一个sql节点,关联脚本时,能打开目录树,无法看到在scriptis中已编辑保存的sql。其他类型节点可以,官方提供的sendbox中是可以的。 我们部署的界面:  官方sandbox中的界面:  我们部署的其他节点的界面,是可以的:

For most new users, our current document is not comprehensive enough and the document format is not standard. What users need most is user manuals, such as: * Scripts: *...