Paddle-Lite

Paddle-Lite copied to clipboard

Paddle-Lite copied to clipboard

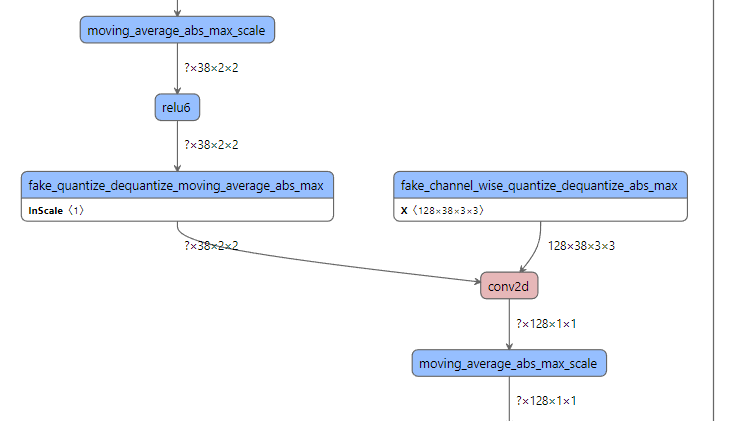

ssd_mobilenet_v1的使用联合量化剪裁策略后导出模型在opt上转换出错:不支持'moving_average_abs_max_scale'

单独执行量化策略导出的模型没有图中的'moving_average_abs_max_scale'算子,只有前面加了fake_*前缀的量化算子,可以被opt转换。但是执行量化剪裁联合策略,导出模型后发现多了'moving_average_abs_max_scale',而且不能被opt工具转换,我看了之前发布的问题也没有得到解答,求解答!!!

目前的版本信息:

错误提示:

Error: This model is not supported, because 1 ops are not supported on 'arm,intel_fpga'. These unsupported ops are: 'moving_average_abs_max_scale'.

错误提示:

Error: This model is not supported, because 1 ops are not supported on 'arm,intel_fpga'. These unsupported ops are: 'moving_average_abs_max_scale'.

您好,我们已经收到了您的问题,会安排技术人员尽快解答您的问题,请耐心等待。请您再次检查是否提供了清晰的问题描述、复现代码、环境&版本、报错信息等。同时,您也可以通过查看官网文档、常见问题、历史Issue来寻求解答。祝您生活愉快~

Hi! We've received your issue and please be patient to get responded. We will arrange technicians to answer your questions as soon as possible. Please make sure that you have posted enough message to demo your request. You may also check out the API,FAQ and Github Issue to get the answer.Have a nice day!

辛苦 @wanghaoshuang 看下导出模型中错误包含 moving_average_abs_max_scale 的问题~

@SunYF-0729 你导出模型的时候不能直接使用paddle.jit.save,需要使用quanter.save_quantized_model接口导出模型

@SunYF-0729 你导出模型的时候不能直接使用paddle.jit.save,需要使用quanter.save_quantized_model接口导出模型

就是用quanter.save_quantized_model替换ppdet/tools/export_model吗,那这个接口在哪

@SunYF-0729 你导出模型的时候不能直接使用paddle.jit.save,需要使用quanter.save_quantized_model接口导出模型

paddle2.2.2 paddledet develop paddleslim develop 用det/tools/export_model导出模型还是不行

请按照以下方式,这样导出模型:https://github.com/PaddlePaddle/PaddleDetection/tree/release/2.4/configs/slim#%E5%8A%A8%E8%BD%AC%E9%9D%99%E5%AF%BC%E5%87%BA%E6%A8%A1%E5%9E%8B