Boris

Boris

没有,可以自己在Request中携带层级参数,如 yield feapder.Request(..., depth=1), 然后层级递增 yield feapder.Request(..., depth=2)

1. 啥叫更改post请求?request有method参数可以指定请求方式 2. 后续feapder版本可以加个配置 3. 下文件tools里有方法

request有method参数可以指定请求方式, method="POST"

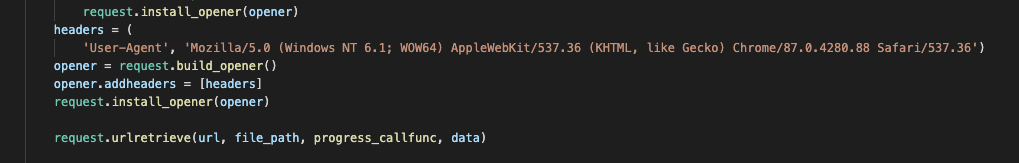

> 对了,我按照你说的是使用了tools下的download_file的方法下载照片,但是我发现他无法设置请求头,我临时改成了这个  ,我想让他像feapder.Request那样具有重试的功能 yield feapder.Request("文件地址") 然后在解析函数里保存 response.content 也是可以的

item 就是个类,可以手动创建,通过命令创建就省事些。也可以不创建,用法细节看下item文档

> @gk18965 > scrapy学了一星期没整明白,feapder学了一天项目已经跑起来了! 牛皮

加入星球或关注公众号可获得作者的微信哦~ 帮忙分享本框架,如转发到爬虫技术群或朋友圈,可获得星球38元优惠券(加作者微信,和作者索要)

> feader的批次爬虫中start_monitor_task会从mysql的任务表拉取字段拼接后会将这个请求封装到redis(包括请求头和cookie)存放到redis以实现分布式,那么当这个请求中请求头的某个字段或cookie过期了,是不是redis中已经存在的和后续的请求都是不合格会被检测的?或者我该如何通知start_monitor_task开启的进程去更改后续存放到redis的请求中的haaders 或 cookie? 在下载中间件里拼header和cookie

> @adaaaaaa > pip3 install feapder[all] > zsh: no matches found: feapder[all] 可能是pip版本问题,试试加个转译 `pip3 install feapder\[all\]`

> @xiaoyueinfo > 爬虫是否支持针对域名限制并发数量,比如一个把1000个类似的网站放到同一个爬虫里面,支持同时并发16个线程,限制每个网站域名只能并发一个线程以避免访问过于频繁。这里面的问题在于,如果把1000个网站做成1000个爬虫同时执行,一是劳动量太大,二是这1000个爬虫干的事情都一模一样,完全是重复劳动。如果1000个网站做成一个爬虫的话,无法控制并发量。如果并发太多,会导致单个网站频繁请求,如果并发太少,效率又不高。最优的方式是能设置最大并发量和单个域名的并发量。请问是否支持,以及如何设置?谢谢大佬。 不支持,1000多个网站通常用可视化配置的爬虫系统,不是feapder干的事儿